用于单张图像去雾的混合注意力网络论文

2025-03-27 14:18:24 来源: 作者:xuling

摘要:图像去雾是高级计算机视觉领域的关键任务之一。近年来,卷积神经网络和Vision Transformer(ViT)作为图像去雾的主流选择,都表现出了优异的性能,但仍无法在保留全局信息的同时还原图像的精细细节,同时也忽略了雾霾分布的多样性。

摘要:图像去雾是高级计算机视觉领域的关键任务之一。近年来,卷积神经网络和Vision Transformer(ViT)作为图像去雾的主流选择,都表现出了优异的性能,但仍无法在保留全局信息的同时还原图像的精细细节,同时也忽略了雾霾分布的多样性。为了解决上述问题,提出了一种混合注意力网络(HA-Net)的新型去雾网络,能够有效结合来自CNN和Transformer的多尺度特征,并融入多层次的注意力机制,实现了网络去雾性能的提升。所提出的HA-Net由混合注意力模块和增强特征融合模块构成。其中,混合注意力模块由改进后的Transformer模块和并行卷积层组成,通过结合二者所提取的特征从而实现优势互补。同时,增强特征融合模块利用聚合不同层次的注意力来增强模型表达不同雾霾分布的能力。定性和定量实验结果表明,所提出的混合注意力网络(HA-Net)在多个图像去雾数据集中均获得较高的评价指标和良好的视觉效果。在公开的RESIDE数据集中,HA-Net取得了室内集的最高PSNR(40.08 dB)和SSIM(0.995)。此外,消融实验也证明HA-Net中所提出的各个模块的有效性。

关键词:图像去雾;注意力机制;混合注意力;Vision Transformer;深度学习

0引言

作为一种常见的大气现象,雾霾直接影响了人们日常活动中的视觉质量,并导致了显著的安全隐患。同时,对于诸如目标检测[1-2]、场景理解[3-4]和语义分割[5-7]等高等级计算机视觉任务而言,拍摄于雾霾场景中的输入图像将显著降低各类方法和模型的性能。图像去雾的目标是从有雾的图像中恢复出高质量并且清晰的图像,它可以作为高级视觉任务的预处理流程,更有效地促进计算机视觉系统在研究和应用中的发展。因此,图像去雾已成为基础计算机视觉领域的焦点,并受到研究人员日益关注。

有雾图像的形成过程可以用大气散射模型[8-10]来近似表示,其表达式如下:

I(x)=J(x)t(x)+A(1-t(x))(1)

式中:I(x)为捕获的有雾图像;J(x)为相应的无雾图像;A为全局大气光;t(x)表示介质透射率图,可以具体表示为:

t(x)=e-βd(x)(2)

式中:β为大气的散射系数;d(x)为场景深度。

早期的图像去雾方法[11-13]是基于先验知识开发的。首先,它们分别估计A和t(x),然后使用式(1)和(2)获得清晰图像。尽管这些方法取得了一定的结果,但由于很难获取足够多的统计信息,此类方法中人为设计的先验知识便无法将现实生活中的所有情况考虑在内,导致其在真实而复杂的雾霾场景中表现出较差的鲁棒性,从而生成了失真的复原图像。

近年来,深度学习的快速发展为图像去雾方法的性能带来了显著提升。目前流行的去雾方法主要可分为两类:(1)基于卷积神经网络(Convolution Neural Net‐work,CNN)的图像去雾方法[14-17],这些方法以端到端的方式构建了从输入图像到输出图像的直接映射,因此它们不需要手工设计的先验信息,并且可以减少参数估计所引入的计算误差。(2)基于Transformer的图像去雾方法[18-21],这些方法引入了Transformer[22],利用其强大的全局特征建模能力和大的感受野,进一步增强了模型的表达能力。

上述方法在图像去雾任务中都取得了相当优秀的成就,但同时也仍然存在一些亟须解决的问题。(1)基于卷积神经网络的方法和基于变换器的方法都无法在很好地保留全局信息的同时恢复图像的精细细节。前者受到卷积固有的等变性和局部性的约束[22],导致远程依赖性和全局上下文建模的限制;后者虽然拥有灵活的感受野和通过多头自注意力(Multi-head Self-attention,MHSA)获得的远程特征依赖性,但无法保留局部特征细节[23-25]。(2)现有的去雾网络[14,16,26]中使用的注意力机制没有有效平衡局部空间信息和全局上下文信息。在现有的图像去雾方法[14,16,26]中,专门设计了像素注意模块来预测位置相关的局部变量t(x),设计了通道注意模块来预测全局共享变量A,然后它们被单独编码。(3)网络模型参数较多,计算开销较大。基于CNN的网络模型[14,16,27,28]倾向于堆叠卷积模块来增加网络的深度和宽度,而基于Transformer的模型[29,21,30]可以通过堆叠编码器达到类似的效果。这些方法通过牺牲内存和计算资源来实现性能改进,使得这些网络变得越来越复杂并且难以在资源受限的环境或嵌入式设备中部署。

为了解决上述问题,本文提出了一种以U-Net[31]作为骨干的新型混合注意力网络(Hybrid Attention Network,HA-Net)。它由本文所设计的混合注意力块和增强特征融合块构建而成。

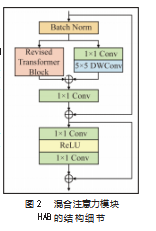

混合注意力模块是一种结构风格类似于Transformer的单元块,它通过改进传统Transformer结构[22]中的归一化层和空间信息聚合方案并引入并行卷积层来对其进行优化。本文的方法将Transformer与卷积神经网络相结合,同时利用前者强大的全局建模能力与后者优秀的局部表示能力,以提升模型对于雾霾特征的表达能力。卷积层具有较小的内核,可以专注于提取信息丰富的局部特征,包括有雾像素、局部细节和纹理;同时,本文改进后的Transformer块因具有较大的感受野,因此可以专注于捕获和传达图像内的全局上下文信息。

本文还提出了增强特征融合块,它包含了1个门控卷积模块和1个选择性核融合模块[32-33]。其中,门控卷积模块用于提取特定位置的局部信息,类似于提取特征的像素级注意机制模块;选择性核融合模块则是基于通道级注意机制,从原始特征中提取共享的全局信息。通过融合不同层次的注意力,增强特征融合模块使模型能够有效地应对各种不同的雾霾分布。

此外,受AECR-Net[26]的启发,本文采用对比学习损失来进一步提高模型的性能。与AECR-Net不同,本文提出的HA-Net使用VGG-16[34]网络作为对比学习的主干网,因为与VGG-19[35]相比,它更轻量并且在对比学习方面几乎没有性能损耗。

综上所述,本文的贡献概括如下。

(1)提出了混合注意力模块,由本文改进后的Transformer块和一个平行卷积层组成。这种结构设计使得该模块不仅能够提取信息丰富的局部特征,同时还能聚合全局上下文信息。

(2)提出了增强特征融合模块,它的设计目的是通过融合像素级别和通道级别的不同层级注意力,使模型能够有效地处理多变的雾霾分布。

(3)在多个数据集上进行了大量实验,结果表明,本文所提出的混合注意力网络HA-Net的性能优于同期的去雾方法,较好地权衡了模型成本和性能表现。

1相关工作

图像去雾方法主要可以分为基于先验的方法和基于学习的方法。最近,视觉变换器[36](Vision Transformer,ViT)因其在计算机视觉领域的成功而备受研究人员的关注。与传统的基于CNN的模型不同的是,ViT不受固定感受野的限制,在理解全局语义和建模长距离依赖方面具有优越的能力。

1.1基于先验的图像去雾方法

早期的去雾方法通常通过利用从经验统计中得出的手工设计先验,并依赖于大气散射模型来消除雾霾。例如,暗通道先验(Dark Channel Prior,DCP)[11]、颜色衰减先验(Color Attenuation Prior,CAP)[12]和非局部先验(NCP)[13]。尽管这些方法取得了不错的去雾效果,但由于它们对预定义先验和假设的依赖,导致在不符合先验假设的区域,特别是在复杂的现实世界场景中,方法的鲁棒性较低。

1.2基于学习的图像去雾方法

深度学习的快速发展为基于学习的图像去雾方法开辟了新时代,此类方法展示出了卓越的性能和稳定性。

这些方法主要是由数据驱动的,利用深度神经网络预测大气散射模型中的关键参数,如传输图t(x)和大气光A。这允许网络模型以端到端的方式直接从雾霾图像中生成恢复图像或者学习从雾霾图像到清晰图像的直接映射。

此类方法的早期工作主要关注于对传输图t(x)和大气光A的直接估计。DehazeNet[37]首次使用端到端的CNN来学习传输分布t(x),而MSCNN[38]则是引入了一个多尺度网络来预测传输t(x)。这些方法专注于预测t(x),并与传统方法所估计的A一起产生去雾结果。相比之下,AOD-Net[39]创新地将传输分布t(x)和大气光A统一为一个单一的未知变量K,使得网络只需估计一个未知量。

后续研究则专注于直接估计清晰图像或清晰与雾霾图像之间的残差。例如,通过结合多尺度注意力机制,GridDehazeNet[14]直接由雾霾图像预测出对应的清晰图像,并首次提出学习恢复图像而不是估计t(x)。GFN[40]通过融合三种预处理方法获得的特征与网络输出的恢复图像,从而生成最终的清晰图像。FFA-Net[16]采用自适应特征融合和注意力机制,在复杂雾霾场景中增强去雾性能。受FFA-Net启发,AECR-Net[26]构建了一个更紧凑的去雾网络,使用FeatureAttention块,并引入对比正则化来提高去雾性能。PMNet[17]将提出的可分离混合注意力(Sep‐arable HybridAttention,SHA)模块与密度图相结合,以更好地感知雾霾密度并进一步细化提取的特征。尽管这些方法显著提高了去雾性能,但同时它们的网络模型结构复杂度更高,加上随之不断增长的计算开销,对此类模型进行训练和部署将是不小的挑战。

1.3 VisionTransformer

最近,Vision Transformer[36]在高级视觉任务中展示了卓越的性能,并已被用于各种低级视觉应用。因此,不少基于ViT的去雾方法也开始出现。例如,DeHamer[18]采用特征调制来聚合由变换器和CNN提取的特征,通过3D位置嵌入模块将雾霾密度先验引入变换器。尽管DeHam‐er减少了由于特征差异导致的细节纹理损失,但也引入了额外的计算开销和训练成本。Dehazeformer[30]结合了Swin Transformer[41]和U-Net,并对Swin Transformer进行了关键修改,使他更加贴合图像去雾任务的特点,但它没有解决变换器对局部特征关注不足的问题。

Transformer在长距离建模方面具有优越能力,一些研究[42-45]提出卷积层可以补充Transformer的短板,从而让模型获得更强的表示能力。此外,基于CNN的模型在结构上比基于ViT的模型更加灵活。因此,本文的方法基于CNN开发设计,以积极地激活输入图像的像素,并辅以ViT的强大表示能力,不引入过多的网络参数和计算成本。

2混合注意力网络HA-Net

本节首先描述了所提出的用于图像去雾的混合注意力网络(HA-Net)的整体结构。随后,进一步介绍混合注意力模块的细节。混合注意力模块是本网络的基本模块,它包含两个部分:用于建模全局上下文信息的改进Transformer块和用于提取信息丰富的局部特征的卷积层。接着,对增强特征融合模块进行介绍,该模块对跳跃连接和主支路赋予了不同的关注度,并根据其各自的关注度选择性地进行融合。最后,对网络的损失函数做了简要的说明。

2.1网络整体结构

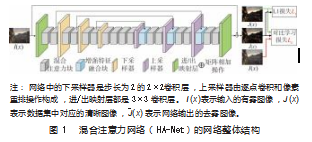

图1显示了HA-Net的整体结构。HA-Net是一个以U-Net为基础的7阶段网络,其中每个阶段都由一组混合注意力模块堆叠而成。在网络的最后三层引入了增强特征融合模块,以融合跳跃分支和主分支。具体来说,给定一张模糊图像I(x)ϵRH×W×3,本文的模型对全局残差R(x)∈RH×W×3进行预测。然后,根据预测的全局残差R(x)得到去雾图像(x),即(x)=I(x)+R(x)。最后,使用L 1损失和对比学习损失LC来训练模型,损失函数将在小节2.4中进行简单介绍。

2.2混合注意力模块

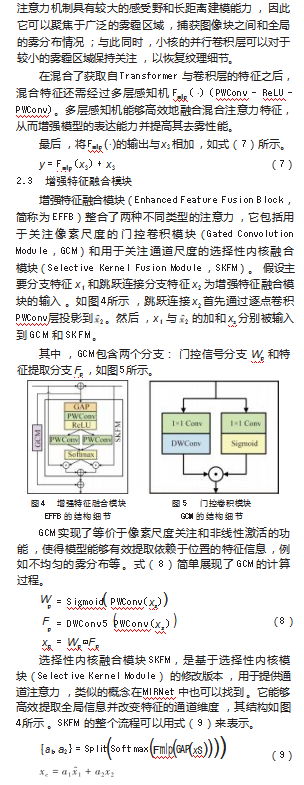

混合注意力模块(Hy‐brid Attention Block,HAB)以标准的Swin Transformer[41]块为基础进行了相应的改进,目的是使其更好地贴合图像去雾任务的特点。同时,在该模块内还设置了并行卷积层,聚合了分别来自卷积层和Transformer的局部特征和全局特征。本文所提出的混合注意力模块结构如图2所示。

Haze4K[51]是另一个合成数据集,包含3 000对训练图像和1 000对测试图像,涵盖室内外场景。由于其合成流程,Haze4K的图像比RESIDE更加逼真。本文的模型HA-Net在Haze4K上总共进行了1 000个epoch的训练。

3.1.2训练参数设置

本文的模型是基PyTorch 1.12.1实现的,使用了两张NVIDIA TeslaV100 GPU进行训练和测试。模型的每个阶段的HAB数量的设置如下:{2,2,2,4,2,2,2},对应的通道数为:{24,48,96,192,96,48,24};每个阶段包含多头自注意力模块的HAB数量分别为:{1,1,2,3,0,0,0},多头自注意力模块的注意力头数为:{1,2,4,6};每个多头自注意力模块的窗口大小设置为16。在模型训练过程中,本文通过随机旋转90°、180°和270°以及水平翻转的方式对训练数据集进行了增强。同时,数据集中的有雾图像被随机裁剪为256×256的图像块,然后输入至HA-Net中。训练总轮数设置为1 000,使用AdamW优化器进行模型训练,其中优化器的参数β1和β2分别设置为0.9和0.999。训练批次大小和初始学习率分别设置为64和8×10-4,并采用余弦退火策略逐步将学习率从初始值降低到8×10-6。超参数α和β则按照经验,设置为0.5和0.1。此外,本文从固定的预训练VGG-16中提取其第2、第3和第5个最大池化层的潜在特征用于式(12)中的LC损失,并且将它们对应的系数ωi(i=1,2,3)分别设置为0.4、0.6和1。

3.1.3评估指标

本文使用峰值信噪比和结构相似度两种定量指标对不同方法的性能进行评估。其中,PSNR越大,表示去雾结果与对应的参考清晰图像的误差越小;SSIM越接近1,表明恢复出得去雾图像与对应的参考清晰图像的结构越相似。

3.2定量实验对比

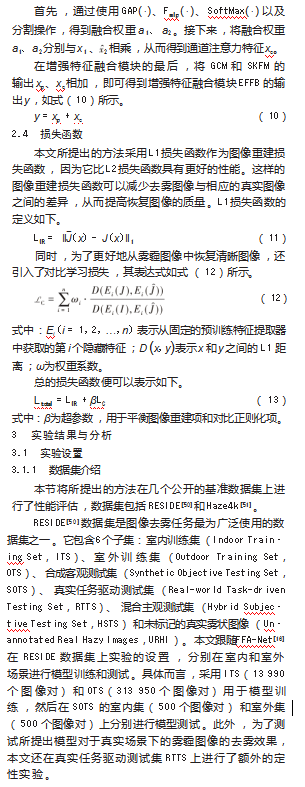

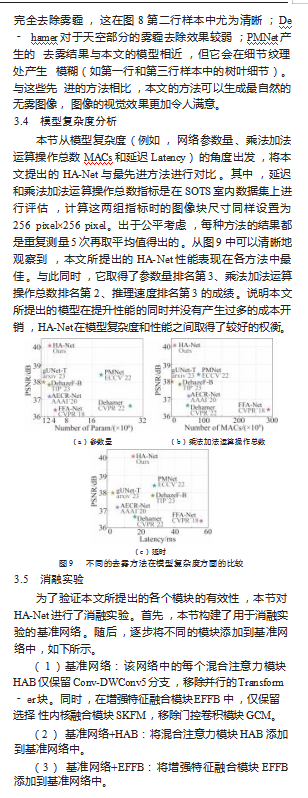

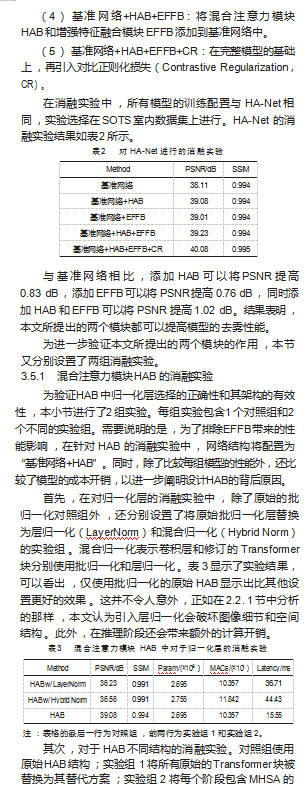

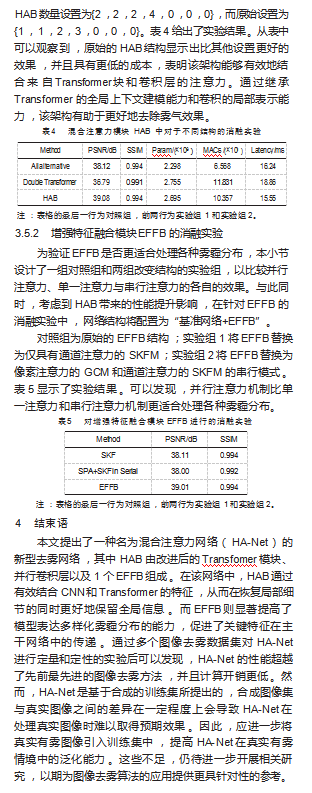

本节将所提出的HA-Net与最先进的几种方法进行了定量比较,对比结果列在表1中。从总体上来看,本文提出的HA-Net胜过了先前的最先进方法。

在RESIDE数据集上,HA-Net在SOTS室内集和室外集上都取得了最佳表现。特别是本文的HA-Net在SOTS室内集上的PSNR超过了40,与具有第二高性能的gUnet-T相比,HA-Net在SOTS室内集上的PSNR上提高了2.09 dB,在SSIM上提高了0.002 dB。

在Haze-4K数据集上,尽管HA-Net与PMNet[17]相比没有性能提升,但HA-Net更轻量级、更高效。并且,由于Haze-4K数据集的样本量较小,将会导致模型训练结果的变化幅度较大。因此,本文有理由认为,HA-Net和PMNet之间的性能差距在很大程度上源自该数据集实验所造成的随机性。

3.3定性实验对比

本节将HA-Net与最先进的去雾方法进行了可视化结果的对比和分析。

3.3.1合成图像数据集

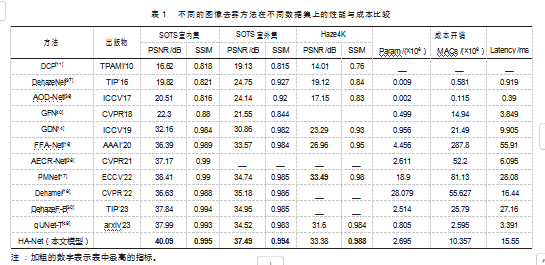

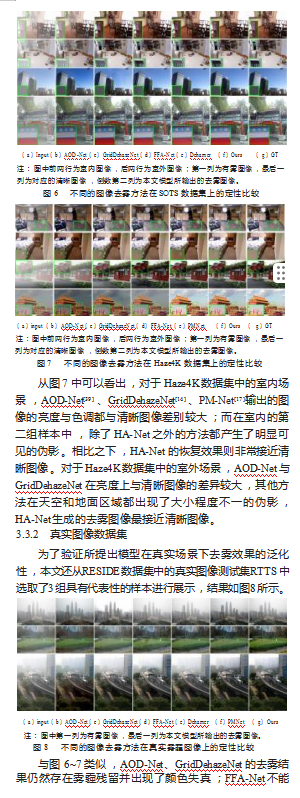

分别从RESIDE数据集的SOTS室内集和室外集以及Haze4K数据集的室内和室外场景中选择了两组具有代表性的样本,结果如图6~7所示。

从图6中可以看出,对于RESIDE数据集中的室内场景,GridDehazeNet[14]、FFA-Net[16]和Dehamer[18]都产生了伪影;尽管AOD-Net[39]没有产生伪影,但它所预测出的去雾图像中仍然残留着许多雾。相比之下,HA-Net没有产生伪影,恢复的图像在亮度和色调方面与清晰图像非常接近。此外,HA-Net能够更好地区分被雾遮蔽的浅色物体和深色物体,产生更令人满意的结果。对于RESIDE数据集中的室外场景,HA-Net生成的去雾图像也比其他方法更接近干净图像。

参考文献:

[1]REDMON J,DIVVALA S,GIRSHICK R,et al.You only look once:Unified,real-time object detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.New York:IEEE,2016:779-788.

[2]CHEN Y,LI W,SAKARIDIS C,et al.Domain adaptive faster R-CNN for object detection in the wild[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.New York:IEEE,2018:3339-3348.

[3]SAKARIDIS C,DAI D,HECKER S,et al.Model adaptation with synthetic and real data for semantic dense foggy scene under‐standing[C]//Proceedings of the European Conference on Comput‐er Vision(ECCV).2018:687-704.

[4]SAKARIDIS C,DAI D,HECKER S,et al.Model adaptation with synthetic and real data for semantic dense foggy scene under‐standing[C]//Proceedings of the European Conference on Comput‐er Vision(ECCV).2018:687-704.

[5]LONG J,SHELHAMER E,DARRELL T.Fully convolutional net‐works for semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2015:3431-3440.

[6]CHEN L C,PAPANDREOU G,KOKKINOS I,et al.DeepLab:Se‐mantic image segmentation with deep convolutional nets,Atrous convolution,and fully connected CRFS[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,40(4):834-848.

[7]ZHAO H,SHI J,QI X,et al.Pyramid scene parsing network[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.New York:IEEE,2017:2881-2890.

[8]MCCARTNEY E J.Optics of the atmosphere:scattering by mole‐cules and particles[M].New York,1976.

[9]NARASIMHAN S G,NAYAR S K.Vision and the atmosphere[J].International Journal of Computer Vision,2002,48:233-254.

[10]NAYAR S K,NARASIMHAN S G.Vision in bad weather[C]//Proceedings of the Seventh IEEE International Conference on Computer Vision.New York:IEEE,1999,2:820-827.

[11]HE K,SUN J,TANG X.Single image haze removal using dark channel prior[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2010,33(12):2341-2353.

[12]ZHU Q,MAI J,SHAo L.A fast single image haze removal algo‐rithm using color attenuation prior[J].IEEE Transactions on Im‐age Processing,2015,24(11):3522-3533.

[13]BERMAN D,AVIDAN S.Non-local image dehazing[C]//Pro‐ceedings of the IEEE Conference on Computer Vision and Pat‐tern Recognition.New York:IEEE,2016:1674-1682.

[14]LIU X,MA Y,SHI Z,et al.Griddehazenet:Attention-based multi-scale network for image dehazing[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision.New York:IEEE,2019:7314-7323.

[15]CHEN D,HE M,FAN Q,et al.Gated context aggregation network for image dehazing and deraining[C]//2019 IEEE Winter Confer‐ence on APPLICATIONs of Computer Vision(WACV).New York:IEEE,2019:1375-1383.

[16]QIN X,WANG Z,BAI Y,et al.FFA-Net:Feature fusion atten‐tion network for single image dehazing[C]//Proceedings of the AAAI Conference on Artificial Intelligence.2020,34(7):11908-11915.

[17]YE T,JIANG M,ZHANG Y,et al.Perceiving and modeling densi‐ty is all you need for image dehazing[J].arXiv preprint arXiv:2111.09733,2021.

[18]GUO C L,YAN Q,ANWAR S,et al.Image dehazing transformer with transmission-aware 3d position embedding[C]//Proceed‐ings of the IEEE/CVF Conference on Computer Vision and Pat‐tern Recognition.New York:IEEE,2022:5812-5820.

[19]VALANARASU J M J,YASARLA R,PATEL V M.Transweath‐er:Transformer-based restoration of images degraded by ad‐verse weather conditions[C]//Proceedings of the IEEE/CVF Con‐ference on Computer Vision and Pattern Recognition.New York:IEEE,2022:2353-2363.

[20]ZAMIR S W,ARORA A,KHAN S,et al.Restormer:Efficient transformer for high-resolution image restoration[C]//Proceed‐ings of the IEEE/CVF Conference on Computer Vision and Pat‐tern Recognition.New York:IEEE,2022:5728-5739.

[21]WANG Z,CUN X,BAO J,et al.Uformer:A general u-shaped transformer for image restoration[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.New York:IEEE,2022:17683-17693.

[22]VASWANI A,SHAZEER N,PARMAR N,et al.Attention is all you need[J].Advances in Neural Information Processing Sys‐tems,2017,30.

[23]PENG Z,HUANG W,GU S,et al.Conformer:Local features cou‐pling global representations for visual recognition[C]//Proceed‐ings of the IEEE/CVF International Conference on Computer Vi‐sion.New York:IEEE,2021:367-376.

[24]CHEN S,YE T,LIU Y,et al.Dual-former:hybrid self-attention transformer for efficient image restoration[J].arXiv preprint arX‐iv:2210.01069,2022.

[25]PARIHAR A S,JAVA A.Densely connected convolutional transformer for single image dehazing[J].Journal of Visual Com‐munication and Image Representation,2023,90:103722.

[26]WU H,QU Y,LIN S,et al.Contrastive learning for compact sin‐gle image dehazing[C]//Proceedings of the IEEE/CVF Confer‐ence on Computer Vision and Pattern Recognition.New York:IEEE,2021:10551-10560.

[27]DONG H,PAN J,XIANG L,et al.Multi-scale boosted dehazing network with dense feature fusion[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.New York:IEEE,2020:2157-2167.

[28]LIU J,WU H,XIE Y,et al.Trident dehazing network[C]//Proceed‐ings of the IEEE/CVF Conference on Computer Vision and Pat‐tern Recognition Workshops.New York:IEEE,2020:430-431.

[29]LIANG J,CAO J,SUN G,et al.Swinir:Image restoration using swin transformer[C]//Proceedings of the IEEE/CVF Internation‐al Conference on Computer Vision.New York:IEEE,2021:1833-1844.

[30]SONG Y,HE Z,QIAN H,et al.Vision transformers for single im‐age dehazing[J].IEEE Transactions on Image Processing,2023,32:1927-1941.

[31]RONNEBERGER O,FISCHER P,BROX T.U-net:Convolution‐al networks for biomedical image segmentation[C]//Medical Im‐age Computing and Computer-Assisted Intervention–MICCAI 2015:18th International Conference,Munich,Germany,October 5-9,2015,Proceedings,Part III 18.Springer International Pub‐lishing,2015:234-241.

[32]Li X,Wang W,Hu X,et al.Selective kernel networks[C]//Pro‐ceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.New York:IEEE,2019:510-519.

[33]ZAMIR S W,ARORA A,KHAN S,et al.Learning enriched fea‐tures for fast image restoration and enhancement[J].IEEETransactions on Pattern Analysis and Machine Intelligence,2022,45(2):1934-1948.

[34]SIMONYAN K,ZISSERMAN A.Very deep convolutional net‐works for large-scale image recognition[J].arXiv preprint arXiv:1409.1556,2014.

[35]WANG Y,YAN X,WANG F L,et al.Ucl-dehaze:Towards real-world image dehazing via unsupervised contrastive learning[J].IEEE Transactions on Image Processing,2024.

[36]DOSOVITSKIY A,BEYER L,KOLESNIKOV A,et al.An image is worth 16x16 words:Transformers for image recognition at scale[J].arXiv preprint arXiv:2010.11929,2020.

[37]CAI B,XU X,JIA K,et al.Dehazenet:An end-to-end system for single image haze removal[J].IEEE Transactions on Image Pro‐cessing,2016,25(11):5187-5198.

[38]REN W,LIU S,ZHANG H,et al.Single image dehazing via multi-scale convolutional neural networks[C]//Computer Vision–ECCV 2016:14th European Conference,Amsterdam,The Netherlands,October 11-14,2016,Proceedings,Part II 14.Springer International Publishing,2016:154-169.

[39]LI B,PENG X,WANG Z,et al.Aod-net:All-in-one dehazing network[C]//Proceedings of the IEEE International Conference on Computer Vision.New York:IEEE,2017:4770-4778.

[40]REN W,MA L,ZHANG J,et al.Gated fusion network for single image dehazing[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.New York:IEEE,2018:3253-3261.

[41]LIU Z,LIN Y,CAO Y,et al.Swin transformer:Hierarchical vi‐sion transformer using shifted windows[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision.New York:IEEE,2021:10012-10022.

[42]YUAN K,GUO S,LIU Z,et al.Incorporating convolution designs into visual transformers[C]//Proceedings of the IEEE/CVF Inter‐national Conference on Computer Vision.New York:IEEE,2021:579-588.

[43]WU H,XIAO B,CODELLA N,et al.Cvt:Introducing convolu‐tions to vision transformers[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision.New York:IEEE,2021:22-31.

[44]XIAO T,SINGH M,MINTUN E,et al.Early convolutions help transformers see better[J].Advances in Neural Information Pro‐cessing Systems,2021,34:30392-30400.

[45]LI K,WANG Y,ZHANG J,et al.Uniformer:Unifying convolution and self-attention for visual recognition[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2023.

[46]BA J L,KIROS J R,HINTON G E.Layer normalization[J].arXiv preprint arXiv:1607.06450,2016.

[47]IOFFE S,SZEGEDY C.Batch normalization:Accelerating deep network training by reducing internal covariate shift[C]//Interna‐tional Conference on Machine Learning.PMLR,2015:448-456.

[48]HE K,ZHANG X,REN S,et al.Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Comput‐er Vision and Pattern Recognition.New York:IEEE,2016:770-778.

[49]SONG Y,ZHOU Y,QIAN H,et al.Rethinking performance gains in image dehazing networks[J].arXiv Preprint arXiv:2209.11448,2022.

[50]LI B,REN W,FU D,et al.Benchmarking single-image dehazing and beyond[J].IEEE Transactions on Image Processing,2018,28(1):492-505.

[51]LIU Y,ZHU L,PEI S,et al.From synthetic to real:Image dehaz‐ing collaborating with unlabeled real data[C]//Proceedings of the 29th ACM International Conference on Multimedia.2021:50-58.