3D卷积增强的驾驶员人物交互行为识别论文

2024-06-11 10:58:30 来源: 作者:liangnanxi

摘要:驾驶员抽烟和打电话的行为属于典型的人物交互行为,为提高模型在驾驶环境中,对遮挡和光照变化的抵抗能力以及人物交互行为匹配的准确性,研究首先提出一种2D扩张分组注意力机制方法对目标检测网络进行优化,提高人路和物路的小目标检测性能;然后提出一种3D扩张分组注意力机制与3D分组卷积融合的高精度轻量化模块,构建动态视频的行为识别模型,增强时序空间的非线性特征提取能力;最后将图片的帧间交并比统计判断结果与动态视频行为识别模型预测的结果相融合以做出最终的驾驶员人物交互行为判断。实验结果证明,2D和3D扩张分组注意力机制

【摘要】驾驶员抽烟和打电话的行为属于典型的人物交互行为,为提高模型在驾驶环境中,对遮挡和光照变化的抵抗能力以及人物交互行为匹配的准确性,研究首先提出一种2D扩张分组注意力机制方法对目标检测网络进行优化,提高人路和物路的小目标检测性能;然后提出一种3D扩张分组注意力机制与3D分组卷积融合的高精度轻量化模块,构建动态视频的行为识别模型,增强时序空间的非线性特征提取能力;最后将图片的帧间交并比统计判断结果与动态视频行为识别模型预测的结果相融合以做出最终的驾驶员人物交互行为判断。实验结果证明,2D和3D扩张分组注意力机制在行为识别中的有效性,驾驶员人物交互行为平均准确率和召回率提高了12.5%及7.72%。尤其在香烟和手机遮挡或光线条件不利的场景下提升明显,并能解决驾驶员与其后排乘客的行为混淆识别问题。

【关键词】人物交互行为;3D注意力机制;3D卷积;抽烟;打电话

识别驾驶员抽烟和打电话的行为对交通安全而言具有重要的意义,研究表明,75%的交通事故都是由违规的驾驶行为引起的,其中由于抽烟打电话使驾驶员未能及时切换到适合的驾驶姿势而导致的交通事故也屡见不鲜[1]。在国标《驾驶员注意力监测系统性能要求及试验方法》[2]中明确定义了驾驶员抽烟和打电话这两种行为需要被监测并预警。《中华人民共和国道路交通安全法实施条例》[3]也将抽烟和打电话等妨碍安全驾驶的行为定义为违规驾驶,对交通安全具有较高的危害性。

目前大多数识别驾驶员抽烟和打电话行为的技术路线因考虑到成本问题,都是基于单目非深度RGB相机,并已经取检测人脸和物体,计算两者在图片中的像素距离,最后统计连续帧内目标在范围内的帧数以判断行为。代少升等[5]在检测到人脸和物体后,回归嘴部关键点,计算连续20帧内嘴型震荡变化,最后统计目标被检测到且嘴型变化在阈值范围内的帧数,当符合要求的帧数达到阈值则做出行为判断。张越[6]将CNN和LSTM网络串联应用,不仅利用了单帧图片中的外观特征和空间距离,也使用了长短时记忆网络增强了模型对时域序列的理解。这些方式依赖目标检测模型的能力,当物体被遮挡或处于光照条件不利的场景时容易出现漏检的问题。Two-Stream[7]方法将RGB的图像空间特征和光流时序特征相结合,融合了两条支路的识别结果以提高行为识别准确性,并有很多学者在这个基础上进行了优化[8-10],改善了其在长视频中的离线行为实时检测的能力。这个方法的缺点来自于光流法本身,由于光流法是在亮度恒定不变[11]的基本假设上构建的,因此这种方法对光线非常敏感,当光照强度发生变化时,会对行为识别造成强烈的干扰。而在驾驶过程中,难免会出现穿越隧道、强光直射等光照强度震荡的场景,导致了双流法识别驾驶员行为的效果并不理想。基于人体骨骼点的节点拓扑结构识别行为的方法也较为常见,ST-GCN[12]基于人体骨骼点的自然连接构造了一个空间图,并在连续帧中加入对应骨骼点的时间边缘。2S-AGCN[13]在此基础上进行改进,考虑了骨骼点连接边的二阶矢量信息,同时,它构造了全局图和局部图这两种形式的图,增强了图的灵活性。Song等[14]提出了一种多流图卷积网络模型,用于探索分布在所有骨架关节上足够多的判别特征,该模型被称为丰富激活GCN(RA-GCN),所激活的关节明显比传统方法多,进一步提升了模型的泛化性。此方法在实际应用中的问题有两点,首先此方法需要增加一个人体骨骼点模型以构建拓扑图结构,这必然会导致系统算力需求的增加;其次此方法更关注人体骨骼点间的时序特征变化而忽略了环境特征,导致空间特征信息提取不足而引起识别精度下降。C3D[15]利用3D卷积核的特性,在视频数据中对多帧图片做跨时空维度的卷积运算,非线性能力极强可以对驾驶员的动态行为和环境特征进行较为充分的提取和识别,在一些公开数据集[16]中已验证了可行性。此方法算力需求大,在轻量化的基础上还能提高或维持精度,是值得研究的课题。

本文将以驾驶员的实车驾驶视频作为研究对象,基于经典的HOI(human-object interaction)三支路交互框架[17],首先加强人路和物路的目标检测模型能力,提高小物体在遮挡和光照不利条件下的检测能力,再使用3D卷积模型进行增强,减少驾驶员抽烟及打电话行为的误识别。

1模型算法架构

HOI检测的目标是定位出图片中的人、物体以及他们之间的交互行为。HO-RCNN框架[17]对HOI检测的研究意义重大,它是一个多支路网络结构,包括人路、物路和交互路。其中人路和物路用于提取其外观特征以定位目标的位置框,而交互路则是确定人和物体的空间交互关系,它仅使用了人与物的空间位置关系,未考虑时序间的上下文联系。

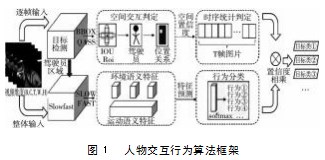

本文在HO-RCNN人物交互行为框架的基础上进行优化,提出通过3D卷积增强的驾驶员抽烟及打电话行为识别框架,优化后的算法框架见图1。

2人路与物路模型设计

2.1目标检测模型

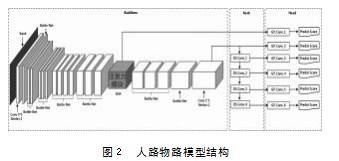

人路和物路的目标检测模型以MobileV2-SSD[19]作为基础,在主干部分增加注意力机制,模型结构如图2所示。

考虑到该网络主要解决的问题是增强小目标物体的识别能力,浅层特征的感受野小适合检出小目标,而深层特征感受野大,对大目标和抽象事物的理解更强。所以直接将注意力模块放置在主干网络中如图2所示的位置,它的输出一方面送入检测头进行目标预测,另一方面送入下一层卷积网络中。下面着重说明注意力机制模块。

2.2 2D扩张分组卷积

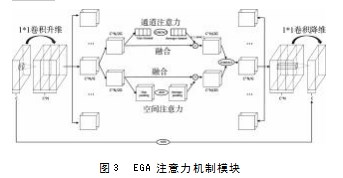

本研究提出一种新的注意力机制,膨胀分组注意力机制模块(Expansion and Group Attention Mechanism Module),以下简称EGA注意力模块,它充分借鉴了分组卷的轻量化优势,以及双通道联合使用提高性能的搭建思路,以先膨胀后压缩的方式,深度提取特征图中的语义关系,网络结构如图3所示。

此模块首先通过步长为一且1∗1的卷积核打通图像通道间的相关性,并实现通道的升维,以扩充图片中可被有效分析的特征。升维后的特征图再进行分组,每组再均分并分别对空间层和通道层进行注意力加强,然后进行拼接、合并和降维操作直至恢复到与输入的通道和尺寸大小一致。最后将输入和输出的特征进行残差连接,让注意力模块增加的前后形成特征关联。令输入特征图的维度为(B,C,H,W),B为每批次的图片数量,C为特征图的通道数,H和W为图片的高宽。图片升维和降维的公式如式(1),其中XG为输入的通道数,N为扩张和压缩的倍数。

![]()

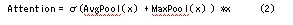

通道和空间注意力都可以用式(2)表示,差异在于对通道或者是空间平面做相关操作。其中x是输入,AvgPool(x)和MaxPool(x)对x作全局自适应平均池化和最大池化。激活函数σ采用Relu6。

EGA注意力机制的整体模块联立式1和式2,并加入分组和残差连接步骤。这个模块通过先膨胀升维后压缩降维的方法保持了输入和输出的维度一致性,便于嵌套进模型的主干网络,升维后的特征图分组进行注意力强化,减少了高维卷积的运算量,提高了运行处理速度。最后的残差连接,可以有效地作为一种保护机制,防止由注意力模块而导致的局部最优问题,从而剔除掉错误的关注区域。

3交互路增强方法

Slowfast[18]是以3D卷积作为基本计算方法的行为识别模型,其算法的核心思想在于,使用Slow分支以较少的帧数和较大的通道学习环境语义信息,并使用fast分支以较大的帧数和较少通道数学习运动信息。

本文首先借鉴Slowfast的核心思想,采用轻量化分组3D卷积技术,同时提出一种基于3D扩增分组注意力机制与分组3D卷积结合的残差模块组件,堆叠组件以完成动态行为识别的网络模型,对交互路进行增强。

3D卷积中做注意力机制增强,主要是为了能更准确地获悉一段视频中的哪几帧会对视频的行为分类起到影响。视频是多张图片的堆叠,可以看做是大小一致的图片在通道深度方向上的扩张。将EGA机制用于3D卷积时,扩张的倍率可以类比为3D卷积中的时间维度T,如果扩张倍率与分组倍率相等,则先将每张图片做注意力操作,再获得每张图片间的时序非线性关系。很多学者已经采用了这样的方式,并提高了模型精度[20-21]。同时,也关注到一部分研究中,采用时间位移模块[22]等方式,重排每帧的通道信息,以此提高了性能。EGA模块则完全具备这样的优质特性,无需再进行时间位移操作,当扩张倍率和分组倍率不相同时,就相当于已经在不同帧中进行了时间位移操作。

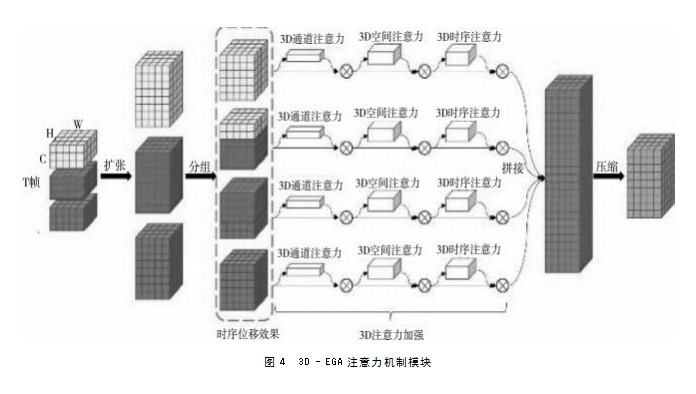

3D-EGA模块的基本形式上同2D-EGA,同样也是先扩张再分组,完成注意力增强后再拼接压缩。区别在于首先将原始输入在通道层做3D卷积扩充,再进行Split分组操作,每组分别进行通道、空间和时间维度的注意力加强,三向注意力增强采用串联方式,类似CBMA[23]注意力机制中,将通道和空间注意力串联,如图4所示。

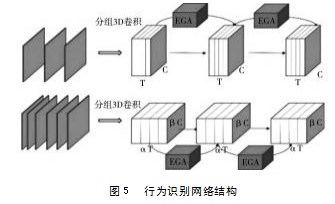

行为识别的网络结构采用多个残差模块堆叠而成,并参考Slowfast框架,分为慢支路和快支路,如图5所示。

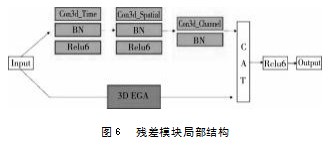

图中的每个残差模块结构见图6,其中原支路为分组3D卷积,采用Relu6激活函数,BN为Batchnor malization正则化操作,CAT指将两个特征图拼接。Con3d__Time、Con3d__Spatial、Con3d_Channel指的是分别对时序维度、空间维度和通道维度做卷积操作。

4后处理判断逻辑

识别驾驶员行为的判断逻辑可以归纳为如下三步。

第一步:计算空间交互置信度。首先目标检测网络会检测到座舱内所有的人和物体,计算所有的人体框与驾驶员座椅框的IOU交并比,以确定观测的对象是驾驶员,然后计算观测对象和目标物体中心框的二维距离,最后输出空间交互置信度见式(3),CS是空间置信度,C i human是第i个人体的检测置信度,C i object是第u个物体的检测置信度,TSi是驾驶员边界框和物体边界框IOU设定的阈值。

![]()

第二步:计算连续帧图片在时序统计内的行为置信度。令一个时间段内有T帧图片,每帧的CG空间置信度已通过上一步骤计算得到,则这段时间内统计所得的行为置信度CT等于CS的平均值,见式(4),其中CK8为第k帧的空间置信度。

第三步:令3D识别模型输出的行为置信度为CD,则最终增强后的行为置信度CP见式(5),其中a和b为权重系数。

![]()

5实验与分析

5.1实验环境及数据

本实验采用英伟达4090Ti显卡显存24G,配置pytorch深度学习框架,cuda版本11.8。用于实验的数据包括两部分,自采自标数据和AVA(Atomic Visual Actions)公开数据集。自采数据邀请6位自愿者参与,在正常驾驶车辆的真实场景中,录制抽烟、打电话和常态驾驶这三种行为,驾驶环境包括白天黑夜以及公路隧道。摄像头选用IR/RGB双制摄像头,会根据明暗程度自动补光,自动切换红外和可见光这两种制式。输入的原始图像为YUV格式,需转换为RGB格式后送入网络。

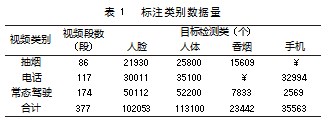

5.2连续帧静态图实验

本实验首先对原始的自采数据进行划分,分帧裁剪出抽烟、打手机和常态驾驶三个类别的视频,每个视频为150帧。裁剪后的视频共计377个。再对每个视频段进行逐帧标注,共标注人脸、人体、香烟和手机四个类别。具体数据类别数量见表1。

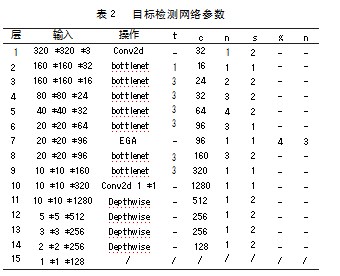

目标检测网络参数见表2,其中Conv2d为2d卷积,bottlenet和Depthwise为MobilenetV2[19]的反向残差卷积和深度可分离卷积,avgpool为平均池化层,EGA为扩张分组注意力机制。t为反向残差的升维倍率,c代表输出特征矩阵通道,n为重复次数,s代表步长,g和n分别代表EGA的分组数和维度扩张倍数。其中第7、11、12、13、14、15共6层的特征将作为SSD模块的输入,直接预测结果输出目标类的置信度和边界框坐标。

目标检测训练120epoch,选用SGD模型优化器,学习率为1∗10-4,动量0.95,丢弃率0.5,batchsized大小为64。增加EGA前MAP最高仅为0.802,loss最终收敛至1.548,平均帧率26.8fps;增加EGA模块后,loss收敛至1.276,MAP达0.818,平均帧率25.9fps。

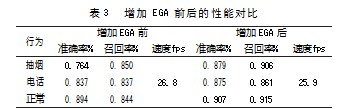

按第四章节中公式(3)和(4)对视频段进行统计计算,其中TSi设为0.6,T设为15fps,C T≥0.7时判断为正样本。因为裁剪后的视频为150帧,所以每段视频将做出10次行为判断。经过统计计算,准确率和召回率提升如表3所示。

由表3可见,在增加EGA注意力机制后,各项指标均有提升。EGA注意力模块可以提高驾驶员抽烟及打电话识别的模型性能。

5.3视频流增强实验

此实验会使用由目标检测模型检测出的人体框,在原图中根据人体坐标款选出人体区域后送入动态行为识别模型,模型结构参数如表4所示。表中,Resorig和ResEGA分别表示图6中的原支路和EGA支路,S和G为3D-EGA中的扩张和分组系数。

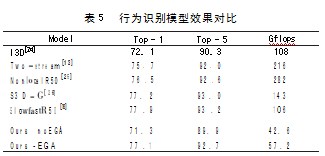

首先在AVA公开数据上进行预训练,epoch设置为20轮,让模型对抽象事物具备一定的特征提取能力。选用SGD模型优化器,学习率为1∗10-7,动量0.9,初始学习率1.25∗10-4。以AVA数据集作为标尺,将本文中的3D行为模型训练结果与现有方法进行对比,比对结果如表5所示。

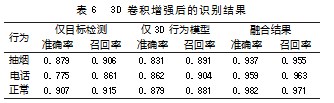

由表5可见,本文中的方法算力消耗大幅度下降,当加入3D EGA注意力模块后精度显著提升。将预训练模型作为Resume节点,更换检测的类别数量和label信息,变更为抽烟、打电话和正常驾驶这三类行为,最后导入预训练模型即可在自采数据上做迁移学习。使用公式(5)将动态行为判断的结果进行融合,统计计算准确率和召回率见表6,行为识别的效果见图7。因为增加行为识别模型后,按照T帧给出一次推理结果,无需逐帧推理,不影响实时监测的推理时效性。

6总结

本文提出一种扩张分组注意力机制EGA,将其融入目标检测模型中,并改写成3D-EGA模块与分组3D卷积融合,构建轻量化3D卷积行为识别模型。实验验证了2D-EGA与3D-EGA模块可以有效提高相关模型的检测识别精度。实验结果也表明,单独使用目标检测方法或者动态行为识别方法,都不能让驾驶员抽烟与打电话的人物交互异常行为检测达到最佳状态。仅采用目标检测的方法,对驾驶员和后排乘客的人物交互关系匹配能力差,当后排乘客有相关行为时,很容易误识别成驾驶员的行为;而仅采用3D行为识别模型的方法,由于对环境信息的特征提取能力不如目标检测模型精细,使得其常常会将一些抓耳挠腮或者捂嘴打哈欠的姿势识别成打电话和抽烟。所以,将这两种方法结合检测驾驶员人物交互行为是最优的选择。在今后的研究中,将持续对模型进行轻量化和精度上的优化,以期将驾驶员异常行为监测算法投入量产应用。

[参考文献]

[1]许骞艺.基于深度学习的驾驶员行为识别方法研究[D].长春:吉林大学,2021.

[2]GB/T 41797-2022驾驶员注意力监测系统性能要求及试验方法.

[3]张平.中华人民共和国道路交通安全法实施条例[J].司法业务文选,2004(Z1):23.

[4]文国波,袁泉,郭海涛,等.基于深度学习的乘务员接打电话行为检测方法研究[J].工业控制计算机,2021,34(3):4.

[5]代少升,黄向康,黄涛,等.一种基于深度学习的驾驶员打电话行为检测方法[J].电讯技术,2021,61(7):8.

[6]张越.基于深度学习的抽烟与打手机行为检测算法研究[D].成都:电子科技大学,2021.

[7]Simonyan K,Zisserman A.Two-Stream convolutional networks for action recognition in videos[J].Advances in neural information processing systems,2014,1.

[8]肖子凡,刘逸群,李楚溪,等.基于时移和片组注意力融合的双流行为识别网络[J].计算机系统应用,2022,31(1):204-211.

[9]齐妙,徐慧,李森,等.一种基于双流网络的行为识别方法[J].吉林大学学报(理学版),2023,61(2):347-352.

[10]丁雪琴,朱轶昇,朱浩华,等.基于时空异构双流卷积网络的行为识别[J].计算机应用与软件,2022,39(3):154-158.

[11]Barron J L,Fleet D J,Beauchemin S S.Performance of optical flow techniques[J].International Journal of Computer Vision,1994,12(1):43-77.

[12]Yan S,Xiong Y,Lin D.Spatial temporal graph convolutional networks for skeleton-based action recognition[J].2018.convolutional networks for skeleton-based action recognition[J].2019.

[14]Song Y F,Zhang Z,Shan C,et al.Richly activated graph convolutional network for robust skeleton-based action recognition[J].IEEE,2021(5).

[15]Tran D,Bourdev L,Fergus R,et al.Learning spatiotemporal features with 3D convolutional networks[J].IEEE,2015.

[16]R.Goyal,S.E.Kahou.The“something something”video database for learning and evaluating visual common sense[J].In ICCV,2017:5843-5851.network for human-object interaction detection[P].2018-8-30.10.48550/arXiv.1808.10437.

[18]Feichtenhofer C,Fan H,Malik J,et al.Slowfast networks for video recognition[C].Seoul:International Conference on Computer Vision,2019:6201-6210.

[19]杜虓龙,余华平.基于改进Mobile Net-SSD网络的驾驶员分心行为检测[J].公路交通科技,2022(03):160-166.

[20]柏正尧,陶劲宇.采用伪3D卷积网络的脑部MRI图像超分辨率重建[J].计算机辅助设计与图形学学报,2022,34(2):208-216.

[21]丰艳,张甜甜,王传旭.基于伪3D残差网络与交互关系建模的群组行为识别方法[J].电子学报,2020(07):1269-1275.

[22]Wu B,Wan A,Yue X,et al.Shift:A zero FLOP,zero parameter alternative to spatial convolutions[C].2017.

[23]Zhang Y,Kong J,Long S,et al.Convolutional block attention module U-Net:A method to improve attention mechanism.

[24]Wang X,Miao Z,Zhang R,et al.I3D-LSTM:A new model for human action recognition[J].IOP Conference Series:Materials Science and Engineering,2019:032035.

[25]Zou H,He J,Xiang S,et al.Saliency detection based on non-local neural networks in low-contrast images[C].Xi,an:Eleventh International Conference on Graphics and Image,2020(1).

[26]Xie S,Sun C,Huang J,et al.Rethinking Spatiotemporal Feature Learning For Video Understanding[J].Computer Vision and Pattern Recognition,2017(12).