深度强化学习在个性化推荐算法中的研究论文

2025-12-09 11:06:03 来源: 作者:xuling

摘要:随着互联网的飞速发展,深度强化学习(Deep Reinforcement Learning,DRL)逐渐成为电商平台挖掘潜在用户的一种新兴技术。

摘要:随着互联网的飞速发展,深度强化学习(Deep Reinforcement Learning,DRL)逐渐成为电商平台挖掘潜在用户的一种新兴技术。本文首先对DRL的基础和类别进行了简要概述;其次,对个性化推荐算法主要的模型和框架进行了总结,包括深度Q网络(Deep Q-Network,DQN)、双深度Q网络(Double Deep Q Network,DDQN)以及基于Actor-Critic的推荐框架;最后,提出了DRL在跨领域推荐的应用、DRL与注意力机制的结合以及新型深度学习架构的应用将进一步提升推荐系统的性能和用户体验,为用户提供一个更加智能、高效的个性化推荐服务。

关键词:深度强化学习;个性化推荐;推荐系统

0引言

近年来,云计算、大数据、物联网等技术飞速发展,使互联网应用呈现多样化和复杂化,引发数据爆发式增长,随之而来的信息超载问题使数据筛选与精准获取面临挑战,推荐系统应运而生。个性化推荐技术通过分析用户过往交互数据和兴趣,运用模型识别并提供定制化服务,如购物推荐、视频优化资讯推送传统推荐系统主要采用协同过滤、基于内容的推荐与混合型推荐三种范式[1]。协同过滤利用用户—项目交互数据创建评分矩阵,基于相似性度量生成推荐;基于内容的推荐侧重于物品特征匹配;混合型推荐综合多种推荐算法的优势提升推荐效果。尽管这些传统方法在一定程度上改善了推荐精准度,但仍存在不足,如协同过滤受限于数据稀疏性,难以应对用户兴趣动态变化;基于内容的推荐在处理高维复杂数据和理解行为模式方面能力有限。为突破瓶颈,强化学习逐渐成为推荐系统研究的关键方向之一。随着深度学习技术的发展,DRL应运而生,其自动特征提取和策略优化机制能精准捕捉用户动态兴趣和行为特性,在复杂用户—物品交互中显著提升预测准确性和用户体验。

本文系统分析DRL的核心技术要素,剖析个性化推荐算法构建中的关键特征,展望未来研究方向,综合评估DRL与个性化推荐融合的长期创新价值与发展前景。

1强化学习和深度强化学习

强化学习作为机器学习的一个独立分支,其范式显著区别于监督与非监督学习。其理念源于对生物体学习过程的模拟,核心机制是智能体通过与环境持续交互,经不断试错和反馈修正,逐步逼近最佳行为策略,以实现累积奖励最大化。

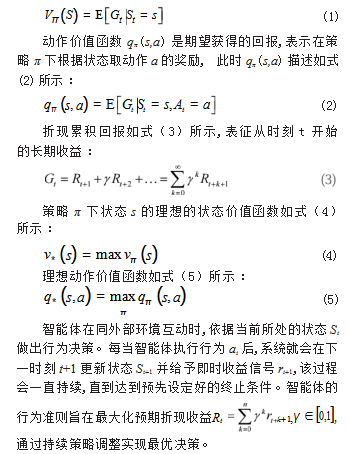

在强化学习中,MDP构成其基本理论框架。该模型由五个关键部分构成:状态集合S、动作集合A、状态转移概率P、奖励函数R和折扣因子γ。在MDP中,价值函数分为状态价值和动作价值两种,其中状态价值函数用于评估智能体在某一特定状态下,若其后续行动遵循某一策略,最终能够获得的预期总奖励。换句话说,它反映了从状态S开始,按照策略π不断采取动作后所能获得的奖励总和,其定义如式(1)所示:

DRL融合了深度神经网络与强化学习技术,突破了传统MDP在应对高维状态空间时的限制[2],为繁杂决策问题提供了有效解决方案。在DRL中,智能体通过接收环境反馈,不断更新状态并优化策略,以最大化长期累积回报。通过这一持续的交互与学习过程,DRL能够在动态环境中实现策略的自适应调整,从而显著提升智能体的整体决策性能。

自2013年DRL在Atari游戏上取得突破性成果后,该领域持续发展并不断创新,研究者将其应用拓展至更复杂的多智能体对抗环境,如DOTA II、星际争霸及雷神之锤III等复杂电子竞技平台,并成功研发出可与顶尖职业选手抗衡的AI系统[3]。在此类应用场景中,智能体依据环境变化动态制定策略并获取奖励反馈,通过多次迭代与经验累积,不断优化决策模型,实现收益最大化。

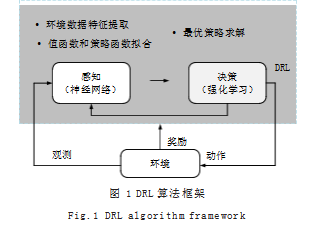

2基于DRL的个性推荐算法的经典算法

在DRL研究方面,DQN、DDQN和基于Actor-Critic的算法是典型代表。DQN及DDQN利用经验回放机制与目标网络结构,解决了传统Q-learning在高维状态空间里易训练不稳定的问题。DQN利用神经网络拟合Q值函数,实现状态到动作价值的映射;DDQN则分离策略决策和价值估计,有效降低了Q值预测误差,使算法的鲁棒性和收敛速度得到了改善[4]。如图1所示,DRL算法框架包含感知、决策和环境交互三大核心部分,感知模块提取关键特征信息;决策模块基于价值和策略函数构建优化模型以确定最佳行动;环境通过即时奖励来评价行为效果,形成感知—决策—反馈的循环[5]。这种框架在处理高维状态动作空间和连续动作空间问题时优势明显,有力地推动了游戏设计、机器人控制和自动驾驶等领域的发展。

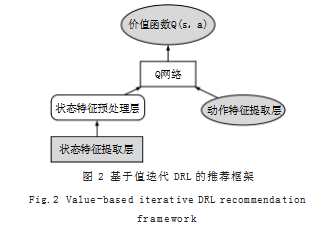

2.1深度Q网络

DQN通过参数化Q函数克服了传统Q-learning处理高维状态和复杂动作的局限。其双网络架构分别负责评估当前状态—动作对的价值函数和确定目标Q值[6]。该模型以环境当前状态为输入,输出所有可行动作的Q值估计。训练时智能体与环境交互产生的经验数据被存储在经验回放缓冲区中,后续通过随机采样进行网络训练。该算法的目标是通过最小化预测Q值与目标值的均方差,结合梯度下降算法更新网络参数,提升智能体在特定环境中的精确性。经验回放机制[7]能有效降低训练样本间的关联性,提升模型训练过程的鲁棒性,并加速算法的收敛。如图2所示,基于值迭代DRL的推荐框架含多个模块。状态特征提取层负责从环境中获取状态特征,状态特征预处理层提高输入质量,动作特征提取层处理动作特征并为Q网络提供必要输入。Q网络结合两种特征计算当前状态下各动作的Q值,使DQN能够有效处理复杂的推荐任务,通过优化Q值来提升推荐准确性和效率。

2.2双深度Q网络

DDQN算法旨在克服DQN中Q值高估的问题。传统DQN使用单一网络选择动作和计算目标Q值,易导致Q值高估,引发估值偏差累积,使智能体采用次优策略,影响模型效能并造成训练波动。DDQN通过解耦动作选择与价值评估过程,采用双独立神经网络分别执行最优动作决策和目标Q值计算[8],有效抑制Q值高估问题,优化策略精度,进而提升模型稳定性与实际性能。

2.3基于Actor-Critic的DRL推荐

结合了值函数和策略函数的优点,基于Actor-Critic的DRL推荐框架包含Actor和Critic两部分,Actor生成推荐动作,Critic评估动作质量,Actor据此优化推荐策略。该方法在策略梯度的基础上引入值函数帮助策略函数更好地学习[9]。Critic网络拟合状态价值函数,其时序差分损失函数如式(6)所示:

式(6)中,将r+γVω(st+1)视为训练目标进行梯度截断,使用梯度下降法更新“评论家”网络的参数即可。

3未来与展望

DRL在个性化推荐领域的应用潜力正逐步展现。一方面,跨域推荐凭借对多源异构数据资源的整合,打破了传统单域模型的固有局限,极大地提升了用户的匹配的精准度;另一方面,DRL与注意力机制的结合能更好地挖掘用户潜在偏好,增强推荐内容的相关性与多样性。与此同时,新型深度学习架构在自然语言处理等前沿领域不断更新发展,为推荐系统优化提供了新思路,有望进一步改善推荐效果与用户体验。推荐系统的可解释性问题也渐渐得到学术界与工业界关注,融合可解释性技术与可视化手段,系统透明度与信任度得到了提升,用户能够直观理解推荐机制。总体而言,DRL在个性化推荐中的应用正朝着高效化、智能化以及强可解释性的方向发展,为改善个性化服务品质和用户满意度提供了有力的支撑。

4结语

本文研究了DRL在个性化推荐领域的应用现状,重点分析了其在突破传统推荐方法局限的独特优势。通过动态建模用户行为特征,DRL能够有效应对数据稀疏性,并精准追踪用户偏好变化,从而提升推荐的准确性和个性化程度。同时,本文梳理了目前主流DRL算法在推荐系统中的典型应用场景,并指出其在可解释性、数据处理效率以及奖励机制设计方面仍存在挑战。在未来发展方向中,随着跨模态数据融合技术的推进、注意力机制的优化以及新型神经网络架构的发展,DRL有望在提升推荐性能的基础上,进一步提升系统的透明度和用户交互体验,推动个性化推荐智能化发展。

参考文献

[1]黄立威,江碧涛,吕守业,等.基于深度学习的推荐系统研究综述[J].计算机学报,2018,41(7):1619-1647.

[2]余力,杜启翰,岳博妍,等.基于强化学习的推荐研究综述[J].计算机科学,2021,48(10):2-9.

[3]陈卓然,刘泽阳,万里鹏,等.多智能体强化学习理论及其应用综述[J].模式识别与人工智能,2024,37(10):851-872.

[4]VAN HASSELT H,GUEZ A,SILVEr D.Deep Reinforcement Learning with Double Learning[C]//Proceedings of the AAAI Conference on Artificial Intelligence,2016,30(1):1-10.

[5]刘延飞,李超,王忠,等.多智能体深度强化学习及可扩展性研究进展[J].计算机工程与应用,2025,61(4):1-24.

[6]张涛.结合深度强化学习的推荐算法研究[D].山东:山东建筑大学,2024.

[7]姚楠,何山,赵越,等.结合强化学习和用户短期行为的新闻推荐算法[J].计算机应用与软件,2024,41(4):284-290.

[8]曹京威,何秋生.基于改进DDQN的无人车路径规划算法[J].组合机床与自动化加工技术,2024(8):48-53.

[9]陈人龙,陈嘉礼,李善琦,等.多智能体强化学习方法综述[J].信息对抗技术,2024,3(1):18-32.