基于视频帧切片用户生成视频质量评价方法论文

2025-03-13 15:38:51 来源: 作者:xuling

摘要:鉴于目前直播平台的视频质量高低不一,为了有效保证用户接收到高质量的视频,视频质量评估(Video Quality Assess‐ment)成为监测和优化直播视频流的重要手段。

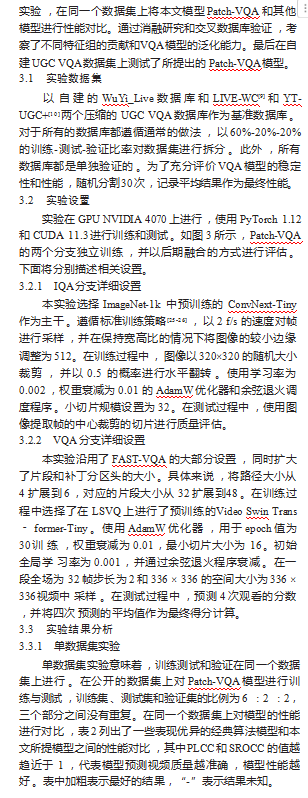

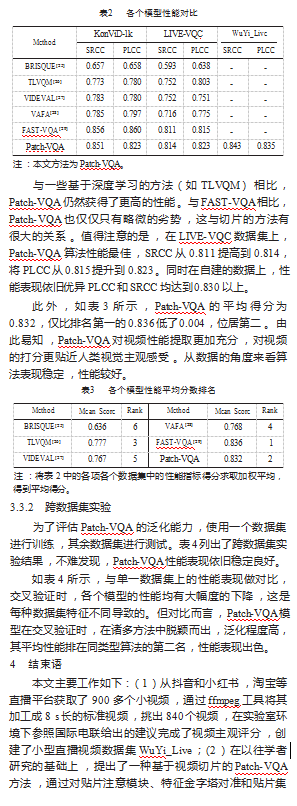

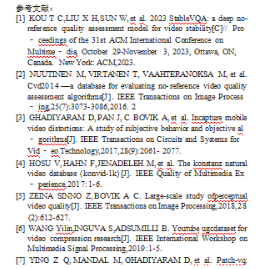

摘要:鉴于目前直播平台的视频质量高低不一,为了有效保证用户接收到高质量的视频,视频质量评估(Video Quality Assess‐ment)成为监测和优化直播视频流的重要手段。为了填补公开赛数据集缺乏直播视频的空缺,自建了一个用户自拍和直播视频构成的小型数据集,并参照国际电联给出的主观视频质量评价方法和指标完成了主观评价实验,得到了该数据集视频的主观评价质量分数。当前主流的VQA算法在事先拍摄好的视频上表现良好,却缺乏在直播视频上的性能测试。因此,在原有评价方法的基础上改进了基于视频帧切片评价方法,称为Patch Video Quality Assessment,专门用于直播和用户生成视频的质量评价。该方法两个分支能够接收图片和视频的输入,能够较好地捕获时域空域信息。单数据集实验和跨数据集实验证明其具有相对稳定且较好的性能,在同类型的算法中,平均性能量化值排名第二。

关键词:UCG;VQA;视频帧切片

0引言

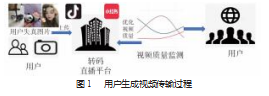

随着社交媒体应用的快速发展以及视频拍摄和处理技术的进步,越来越多的普通人愿意在社交媒体或流媒体平台(如Twitch、Tiktok、淘宝等)上讲述自己的故事,分享自己的经历,发出自己的声音。然而,由于缺乏摄影技巧和专业设备,用户生成内容(User Generated Content,UGC)视频的质量可能会因外部环境剧烈变化,比如设备摇晃,光线不足等而造成视频质量降低,拍摄出来的视频质量较差,影响观众感官体验[1]。更重要的是,在常见的直播平台中,直播视频为了提高传输速度,减少传输带宽,降低直播延时,在传输给用户之前都是经过压缩编码的,其中压缩算法对直播视频的视觉质量影响很大,容易造成压缩失真。图1为视频用户生成视频从拍摄完成到传送到用户终端的过程。视频质量评估(Video Quality Assessment,VQA)工具在视频质量监控中发挥着重要作用,可以及时发现视频质量问题从而进行优化使直播系统的最终用户接收到高质量的直播视频。

鉴于此,对直播视频进行实时的质量监测评估是保证直播效果的最有效手段之一,对用户生成视频进行质量评价是保证抖音,小红书等平台用户获得高质量视频的重要手段。国内外关于视频质量评价的数据集中,极度缺少关于直播视频的数据集,这对于研究直播视频质量评价非常不利,因此本实验室花费大量人力物力,创建了一个小型直播视频数据集。同时国内外对于直播视频的评价方法研究比较匮乏,目前性能表现最好的Dover算法也仅仅是针对提前拍摄好的视频。因此,本文提出一种有效的无参考视频质量方法,希望能对直播视频进行有效评价,且模型泛化程度高。本文的创新点主要体现在3个方面。一是提出了一种基于深度学习的用户生成视频质量评价方法;二是根据国际电联组织颁布的相关要求和规定自建了一个基于小型视频数据集;三是在自建数据集和公开数据集上训练模型,提出的方法模型都取得了不错的效果。本文将重点阐述该评价模型的原理,及实验结果,并在同样条件下和其余同类型算法模型做对比。

1评价数据集

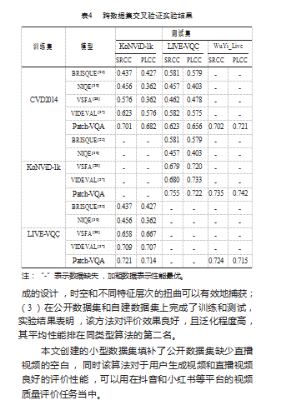

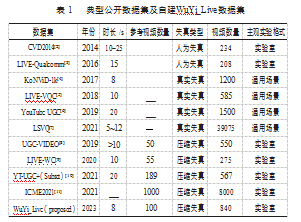

数据集[2,3]是用人工的方法添加了失真类型,主观评价实验在实验室完成,视频时长在10~25 s之间,目前而言该数据集视频数量较少,有一定的缺陷性。数据集[4-7]是真实失真的数据集,不是人工添加的失真类型,这类数据集用来研究一般野外自然失真对视频质量的影响。具有一定的压缩损失的VQA数据库[8-11]用来研究压缩伪影的影响,用来解决压缩失真的视频质量评估问题。然而,这些数据库要么规模较小,要么采用高质量的用户生成视频作为来源,并且上述数据库都缺乏直播场景中的视频,为了解决这个问题,本实验室团队构建出了一个名为WuYi_Live的小型数据集(表1),包含来抖音直播平台的360个源视频和相应的480个不同比特率的压缩视频。然后,并在一个控制良好的环境中进行一个主观实验,对该数据库中的视频进行了主观打分。

2评价方法模型

视觉骨干网络的发展极大地促进了各种下游任务[12-16]的发展。根据输入数据的形态,视觉网络可以分为两种类型,图像网络(即2D网络)和视频网络(即3D网络)。C3D[17]开创性地设计了一种带有3D-CNN的11层CNN,以适应视频输入。随后的P3D[18]、S3D[19]和R(2+1)D[20]观察到,与纯3D卷积相比,相互独立的空间和时间卷积在速度和精度上的权衡更为有利。最近,随着CNN到Transformer骨干架构的转变,特别是,Swin Transformer[21]重新引入了卷积的归纳偏置(即局部性、平移不变性和层次),这使其能够作为通用主干。基于图像的Transfomer的成功引发了基于视频的Transfomer网络的进一步研究。在Transfomer的所有特性中,对视频帧进行切片操作能够准确区分每个切片的边缘,因此使它们非常适合处理GMS(Grid Mini-patch Sampling(GMS)strategy)采样的输入。

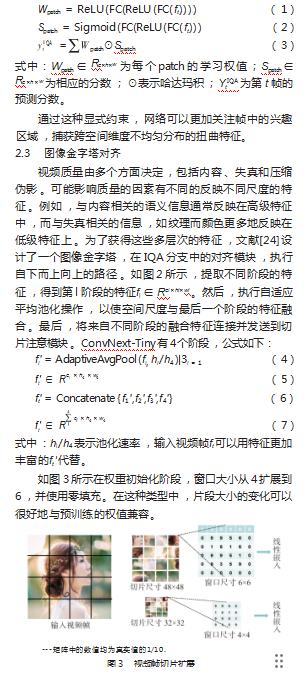

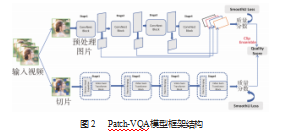

图2是本文提出来的基于GMS小网格切片采样策略的网络架构,称之为Patch-VQA。整个体系结构由两部分组成。其中一部分是基于图像输入获取全局信息的感知网络。另一部分是基于视频片段输入的感知网络,通过采样片段区域获取纹理信息。在训练过程中,两个部分分别使用不同的优化目标进行训练。在推理过程中使用集成将两部分的预测结果结合起来,以增强模型的泛化能力。

2.1总体框架

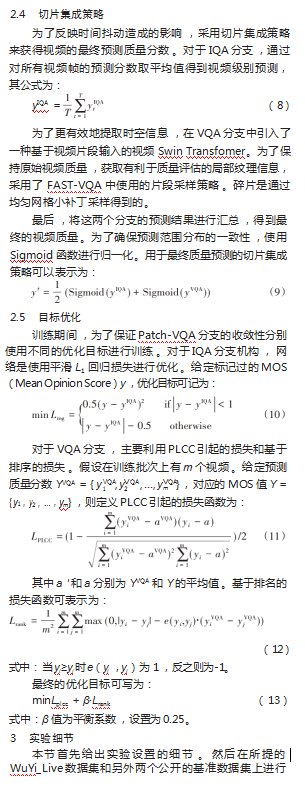

如图2所示,Patch-VQA的整体框架由两部分组成。给定一个输入视频V,其中一部分是基于图像输入的感知网络(称为IQA分支)xt,它表示从V中采样的第t帧,以ConvNext[22]为主干获取全局信息,逐帧分析视频,并输出结果的平均值作为最终的质量预测分数。另一部分是基于视频片段输入的感知网络(命名为VQA分支)G={gt,…,gT},以video Swin Transformer[14]为主干,通过对片段区域进行采样获取时空信息作为FAST-VQA[23],输出整体质量预测分数。通过集成策略得到质量分数y′的最终预测,增强了模型的泛化能力。

2.2切片注意模块

为了综合考虑不同区域在空间维度上的质量,在IQA分支的头部添加了一个基于patch的注意力模块。具体如图2所示,该模块接收提取的特征作为输入,并通过由轻量级网络组成的两个独立分支生成权重和分数。特征图中每个patch的质量分数可以自关注地将对应的分数和权重相乘得到。然后对所有的patch进行汇总,生成对整个图像的最终预测。考虑到输入特征ft∈Rc×h×w,特征提取公式如下: