基于YOLOv4改进算法的智能化冰柜商品数量检测方法论文

2024-06-01 11:55:26 来源: 作者:zhoudanni

摘要:随着无人超市中智能冰柜的需求量逐渐增大,智能冰柜商品识别技术得到迅猛发展,如无线射频识别、条形码识别、二维码识别及图像识别等。但由于信号干扰、条形码遮挡、二维码褶皱、识别网络模型过大等原因,以上识别技术存在辨识率不高,速度较慢的问题。针对以上问题,搭建激光散斑测距系统并提出一种基于YOLOv4改进算法的智能冰柜商品数量检测方法。该方法优化Backbone阶段CSP Darknet53中的卷积层和CSP模块,剔除Neck阶段8倍降采样,解决了YOLOv4算法模型体积较大、识别速度较慢的问题。通过IR相机获得

摘要:随着无人超市中智能冰柜的需求量逐渐增大,智能冰柜商品识别技术得到迅猛发展,如无线射频识别、条形码识别、二维码识别及图像识别等。但由于信号干扰、条形码遮挡、二维码褶皱、识别网络模型过大等原因,以上识别技术存在辨识率不高,速度较慢的问题。针对以上问题,搭建激光散斑测距系统并提出一种基于YOLOv4改进算法的智能冰柜商品数量检测方法。该方法优化Backbone阶段CSP Darknet53中的卷积层和CSP模块,剔除Neck阶段8倍降采样,解决了YOLOv4算法模型体积较大、识别速度较慢的问题。通过IR相机获得激光散斑下红外图像,并运算得到深度图,进而与彩色图像配准得到商品深度信息,最终计算出商品剩余数量。该改进算法与YOLOv4、YOLOv3算法进行实验比较,结果表明改进后的YOLOv4模型mAP可达97.02%,模型大小仅为13.8 MB,相较于YOLOv4原有算法检测速度提升了50%。该方法可为商品库存远程管理提供一种高效的技术手段。

关键词:YOLOv4,激光散斑,图像匹配

0引言

随着冰冻食品在人们日常消费中日益流行,无人超市中智能冰柜的需求量逐渐增大,智能冰柜的商品识别技术得到迅猛发展,如无线射频识别[1]、图像识别[2]、条形码识别[3]、二维码识别等。然而,这些技术仍存在一些问题,如商品识别率不高、商品质量监测受低温影响、个别图像识别算法速度较慢等[4-5]。这些问题严重影响了智能冰柜的商品管理效率和准确性,需要寻求更为高效和精准的解决方案。

为解决上述问题,本文旨在提出一种激光散斑测距系统和YOLOv4多目标检测算法相结合的技术方案。首先,通过冰柜正上方的RGB相机和IR相机获取冰柜内图像;然后,分析RGB相机获取的图像,获得冰柜内的商品类别信息和坐标信息;接着,通过配准不同相机的图像,并结合商品的坐标信息,得到对应商品到相机的距离;最后,根据商品厚度、相机到冰箱底部距离等已知参数,计算得出不同类别商品的数量[6-8]。

与其他类似课题研究相比,本文的方法不需要为每个物品贴上额外标签,避免了来自温度、无线信号等的影响,可以降低冰柜管理的复杂度和人工成本,减少人为因素的干扰,提高管理效率和准确性。同时,该方法可以避免商品被盗或损坏的情况,因为在商品被取走或损坏时,系统会自动检测并更新商品数量,商家可以及时发现问题并采取相应措施。此外,本文采用的YOLOv4改进算法,在不丢失识别精度的情况下提高了辨识速度。

本文研究结果将为智能冰柜的商品管理提供更为准确和高效的方法,提升管理效能,减少误差和损失。同时,该方法也可应用于其他场景中的物品数量检测,具有广泛的应用前景。

1 YOLOv4算法

YOLOv4是一种多目标检测算法,是继YOLOv3后官方承认的框架,该算法在YOLOv3的基础上优化了图像提取效率,使得速度与精度都得到了极大的性能提升。该算法主要由输入端、主干特征提取网络Backbone、特征加强模块Neck和检测头YOLO Head组成。

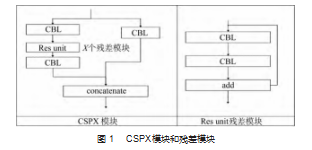

YOLOv4的Backbone阶段采用CSPDarknet53网络结构,该网络是在Darknet53的基础上结合CSPNet[9],在原网络中加入多个CSP子模块以解决网络中的梯度信息重复的问题。原先的Darknet53共有5个大残差模块,CSP-Darknet53则是在每个残差模块中加入CSP模块,结构如图1所示。

在Neck阶段中采用PAN结构替换了FPN结构,增加SPP结构,检测头则继承原先YOLOv3的检测头[10-13]。

1.1数据预处理

为提高模型的鲁棒性,在数据预处理阶段,YOLOv4中Mosaic数据增强参考了CutMix[14]数据增强方式。在训练集中随机选取若干个(本文选择4个)图像,经过随机缩放、裁减、排布的方式形成新的训练集元素,如图2所示。

1.2损失函数

在模型训练阶段,损失函数可计算模型预测值与真实值的差异,并返回结果以作为参数更新的标准。目标检测中的损失函数包括Bounding Box损失计算和置信分。

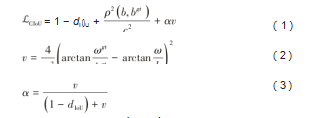

传统的Bounding Box损失计算方式是IoU,即预测框与真实框的交并比。IoU范围一般为(0,1),具有尺度不变性,可以用于衡量各种形状的匹配程度,但无法实现精准的重合度计算。而Complete-IoU(CIoU)考虑了目标与预测框之间的距离、重叠率以及长宽比等因素,使得目标框的回归更加稳定,更加符合Bounding Box回归机制[15]。故YOLOv4中选择CIoU作为损失计算方式。

式中:α为权重函数;ρ2(b,bgt)为预测框和真实框的中心点的欧氏距离;c为同时包括预测框与真实框最小闭包区间对角线的距离;v为度量长宽比的相似性。

1.3算法改进

本文检测目标面积较大、冰柜内背景单一,如采用YOLOv4原有卷积层结构,会使得特征过度提取,导致运算冗余。同时在多重降采样倍率工况下,低倍降采样倍率会造成码放商品边缘特征的误提取,最终影响商品数量的计算。针对上述问题,在保证检测精度情况下,提高检测速度,简化算法模型结构,如图3所示。

在Backbone阶段中只保留CSPDarknet53中的2个CBL模块和1个CSP模块,在CSP模块处理后再增加1个残差模块进行尺度融合,并采用最大池化层对特征图进行降维。在Neck阶段,去除SPP模块和多余的CBL模块,仅保留4个CBL模块和增加1个残差模块。为避免

网络在低倍降采样下过度提取小特征的信息,去掉了8倍降采样分支。Head阶段,仅保留了32倍和16倍降采样下的输出。简化后的网络结构由原来的162层缩减至36层,不仅大幅度简化了整个特征提取过程,提高了模型的泛化性能[16],而且减少了模型参数量,加快了模型推理速度。

2激光散斑技术

常见的相机测距技术有单目测距、双目测距、多目测距、结构光测距、TOF测距、激光散斑测距等。通过实验对比,在保证辨识精度的情况下,兼顾成本问题,本文选用已实现量产的激光散斑测距技术[17-18]。

激光散斑测距系统一般由1个能发射散斑的红外光源及1个IR摄像头组成。无规则散射体在红外光照射条件下产生激光散斑,而此类散斑图案会随着距离变化而改变,即可根据散斑图案判断其距离。对于空间中的任意物体,只需分析该物体上的散斑图案,便可得到此物体的位置信息[19]。激光散斑下的图像如图4所示。

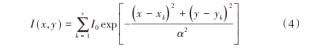

常用的散斑计算方法是将一定数目下随机分布的高斯光斑进行叠加,假设图像背景光是均匀的,s表示散斑的数目,α表示散斑的尺寸大小,I0表示图像背景光强(通常为1),(xk,yk)表示第k个散斑颗粒的中心位置,则图像灰度函数可表示为:

3图像配准

本文中使用的相机是乐视LeTMC-250深度摄像头,其自身带有RGB相机和IR相机。其中RGB相机获取的彩色图像用于分类与定位商品,结合IR相机的激光散斑图像,从而计算得到商品数量。由于2个相机的空间位置不同,要同时实现识别商品分类和深度计算,必须对2个相机进行配准[20]。

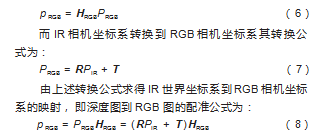

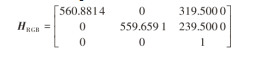

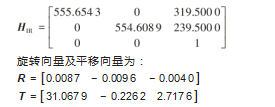

采用基于MATLAB的张正友标定法对相机进行标定,通过2个相机同时获取同一场景下不同位姿棋盘板的图像,将获取的图像输入到MATLAB的标定箱中进行计算,得到2个相机的内参矩阵(HIR,HRGB)、旋转矩阵R和平移向量T[21-23]。设空间任一点P在IR相机和RGB相机的相机坐标系下坐标分别为PIR和PRGB,那么RGB相机和IR相机坐标对应的世界坐标转换公式为:

4实验结果与分析

4.1目标检测算法实验设置及结果分析

实验采用自制速冻商品数据集,包含6个种类的商品,共有463张图片,其中训练集364张,测试集99张。训练软件配置为Windows10、Darknet,硬件配置为NVIDIA Ge-Force RTX 3060 Laptop GPU、I9-11980HK CPU。训练程序的参数设置如下:Batch大小为64;最大迭代次数为10 000;动量因子为0.949;权重衰减系数为0.000 5;初始学习率设置为0.001,之后根据训练的迭代次数动态更新。

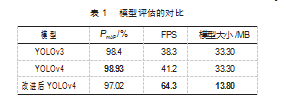

实验采用平均精度均值(mean Average Precision,mAP)、每秒帧率(Frames Per Second,FPS)和模型大小作为网络性能的评价指标[24]。通过用相同的数据集进行训练和测试,YOLOv3、YOLOv4和YOLOv4改进算法的最优模型评估指标如表1所示。由表可知,3个模型算法的拟合程度无明显差距,改进后的YOLOv4算法的精确率比YOLOv3低1.38%;在模型大小方面,改进后模型大小仅为13.80 MB;在速度上改进后模型更是达到了64.3 FPS,相较于YOLOv4原有算法检测速度提升了50%。

综上所述,改进后的YOLOv4与YOLOv4准确度相差不大,但其体积更小,运行速度更快,更符合智能冰柜应用场景需求。图5所示为改进后YOLOv4识别结果。

4.2深度图获取与配准实验与分析

首先本文为获得深度图到RGB图的配准参数,利用MATLAB中的标定工具箱分别对RGB相机和IR相机进行标定[25],得到内参矩阵与旋转向量和平移向量如下所示:

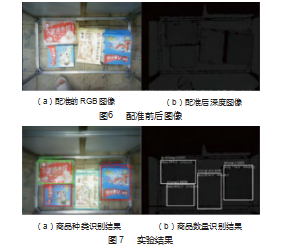

根据式(8)和上述参数即可得到彩色图像中坐标对应到深度图中的坐标,配准前后的效果如图6所示。然后,利用上述结论和商品厚度、相机到冰箱底部距离等已知参数,计算出商品数量,结果如图7所示。

4.3激光散斑测距实验与分析

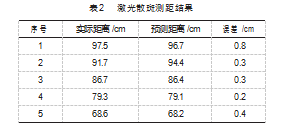

冰柜结构如图8所示。为评估所获深度图的误差大小,共收集样本232张,将每个样本中相机至商品实际距离、预测距离和误差进行对比,部分预测值与实际值对比结果如表2所示。由此可计算出,全部样本的均方误差为1.3%,在实际距离为60~80 cm时误差较小,在距离大于80 cm时误差增大,但误差仍保持在10 mm以内。

5结束语

本文通过搭建激光散斑测距系统并提出一种基于YOLOv4改进算法的智能冰柜商品数量检测方法。该方法优化Backbone阶段CSPDarknet53中的卷积层和CSP模块,剔除Neck阶段8倍降采样,解决了YOLOv4算法模型体积较大、识别速度较慢的问题。

通过IR相机获得激光散斑下红外图像,并运算得到深度图,进而与彩色图像配准得到商品深度信息,最终计算出商品剩余数量。将所提改进算法与YOLOv4、YO-LOv3算法进行实验比较,结果表明:改进后的YOLOv4模型mAP可达97.02%,模型大小仅为13.8 MB,相较于YOLOv4原有算法检测速度提升了50%。该方法可为商品库存远程管理提供一种高效的技术手段。

参考文献:

[1]张晏魁.基于无线射频识别技术的冷链物流智能分拣系统设计[J].现代电子技术,2020,43(20):53-56.

[2]汪勇.人工智能算法下图像识别技术的应用[J].电子技术与软件工程,2022(21):180-183.

[3]王颢.基于图像处理的条形码定位与识别技术研究[J].科技视界,2020(35):59-60.

[4]蔡合瑶,王进华,田明亮,等.基于视觉的无人售货冰柜的称重系统辅助方案[J].自动化技术与应用,2020,39(1):6-8.

[5]林付春,张荣芬,何倩倩,等.机器视觉中的智能无人零售系统设计[J].电子技术应用,2018,44(9):96-98.

[6]李存海,江浩侠,胡金磊,等.适应变电站进出监控需求的人脸快速识别方法[J].机电工程技术,2018,47(8):104-107.

[7]丁永新,李涛,郭志威,等.基于BP神经网络的机电产品清单数据智能补全算法研究[J].机电工程技术,2023,52(1):142-145.

[8]杜娟,杨钧植.基于迁移学习的小样本连接器缺陷检测方法[J].自动化与信息工程,2022,43(5):1-7.

[9]WANG C Y,MARK LIAO H Y,WU Y H,et al.CSPNet:a new backbone that can enhance learning capability of CNN[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recogni-tion Workshops.Seattle:IEEE,2020:1571-1580.

[10]MEI Y Q,FAN Y C,ZHANG Y L,et al.Pyramid attention net-work for image restoration[J].International Journal of Computer Vision,2023,131(12):3207-3225.

[11]ZHAO B J,ZHAO B Y,TANG L B,et al.Multi-scale object detection by top-down and bottom-up feature pyramid network[J].Journal of Systems Engineering and Electronics,2019,30(1):1-12.

[12]HE K M,ZHANG X Y,REN S Q,et al.Spatial pyramid pooling in deep convolutional networks for visual recognition[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9):1904-1916.

[13]BOCHKOVSKIY A,WANG C Y,LIAO H Y M.YOLOv4:opti-mal speed and accuracy of object detection[EB/OL].2020:arX-iv:2004.10934.http://arxiv.org/abs/2004.10934.

[14]苏佳,贾欣雨,侯卫民.基于YOLO-J的PCB缺陷检测算法[J/OL].计算机集成制造系统,2022:1-20.(2022-06-24).https://kns.cnki.net/kcms/detail/11.5946.tp.20220622.1623.005.html.

[15]宋中山,肖博文,艾勇,等.基于改进YOLOv4的轻量化目标检测算法[J].电子测量技术,2022,45(16):142-152.

[16]Yun Sangdoo.Cutmix:Regulari-zation strategy to train strong classifiers with localizable features[C]//Proceedings of the IEEE/CVF inter-national conference on computer vision,2019:6023-6032.

[17]郑艺欣.基于YOLOv4的目标检测方法研究[D].南京:南京邮电大学,2022.

[18]聂建林.基于激光散斑图像的物体识别技术研究[D].西安:西安工业大学,2022.

[19]闻铭.基于双目激光散斑的深度感知方法研究[D].沈阳:东北大学,2020.

[20]古家威.基于激光散斑的3D视觉传感器的地图构建算法研究[D].广州:华南理工大学,2020.

[21]宋立博,费燕琼.两类YOLOv4-tiny简化网络及其裂缝检测性能比较[J].同济大学学报(自然科学版),2022,50(1):129-137.

[22]欧阳宁,刘文波.浅谈基于深度相机的手势识别系统[J].大众科技,2013,15(4):10-12.

[23]李浩宇.一种彩色相机和深度相机的联合校准和失真矫正算法[J].信息通信,2015,28(10):54-55.

[24]娄联堂,姚松.基于局部轮廓曲线的图像配准方法[J].中南民族大学学报(自然科学版),2023,42(1):128-133.

[25]林冬梅,张爱华,王平,等.张氏标定法在双目视觉脉搏测量系统中的应用[J].兰州理工大学学报,2016,42(2):78-85.