基于Transformer改进的Faster RCNN在复杂环境下的车辆检测论文

2024-06-01 11:28:41 来源: 作者:zhoudanni

摘要:在监控视角中目标车辆较小、遮挡较为严重,导致检测精度低。通过探讨卷积神经网络和Transformer模型的互相借鉴和联系,并结合损失函数等常规改进,提出了新的Faster RCNN模型。通过借鉴Transformer模型的思想,对原有的特征提取网络进行了改进,将原block比例3∶4∶6∶3改为3∶3∶27∶3、卷积核由3×3改为7×7,增大其感受野,能够更好捕捉图像中的全局特征,使用DW卷积来减少参数量并略微提高性能,使用Channel shuffle解决通道间信息不交流的问题。将原先交并比IoU改为C

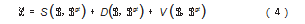

摘要:在监控视角中目标车辆较小、遮挡较为严重,导致检测精度低。通过探讨卷积神经网络和Transformer模型的互相借鉴和联系,并结合损失函数等常规改进,提出了新的Faster RCNN模型。通过借鉴Transformer模型的思想,对原有的特征提取网络进行了改进,将原block比例3∶4∶6∶3改为3∶3∶27∶3、卷积核由3×3改为7×7,增大其感受野,能够更好捕捉图像中的全局特征,使用DW卷积来减少参数量并略微提高性能,使用Channel shuffle解决通道间信息不交流的问题。将原先交并比IoU改为CIoU,与改进后的特征提取网络结合,进一步提高小目标和遮挡目标的检测效果。在UA-DETRAC数据集上,改进后的模型在mAP 0.5:0.95方面比原算法提高了20.20%,并在大、中、小目标下分别提高了15.8%、23%和45.8%,相较于其他模型,如YO-LOv7、YOLOv5和Cascade RCNN,mAP 0.5:0.95分别提高了3.3%、5%和6.69%。

关键词:Transformer;CIoU损失函数,卷积神经网络改进,改进的Faster RCNN

0引言

近年来,越来越多的研究表明,卷积神经网络(Convolutional Neural Networks,CNN)和Transformer[1]模型之间存在着相互借鉴和联系,相互促进彼此发展的趋势越来越明显。

2021年AlexNet[2]的提出促使人们进入了图像领域,开始了计算机视觉的新时代。自此,该领域迅速发展。VGG16[3]将AlexNet较大的卷积核进行替换,并在深度上进一步扩张,较后者性能有大幅提升。ResNet中[4]提出了残差结构,解决了在训练时可能出现的梯度消失问题,使更深的网络结构(ResNet101、ResNet152)成为了可能。ResNext中[5]又提出了组卷积(Group Convolution)使参数量和计算量减少,在准确率上还有进一步提升。MobileNet[6–8]、EfficientNet[9]等轻量网络的提出也进一步丰富了卷积神经网络的发展方向。

CNN可以更有效地捕获图像中的空间结构,由于计算是共享的,CNN本身也十分高效。再加上卷积神经网络中的池化层和归一层可以减少图像中的噪声和冗余信息,使网络具有鲁棒性。其使用反向传播算法能够快速进行训练和收敛。大概在同一时间,Transformer引入了自注意力机制(Self-Attention Mechanism),可以学习到输入序列中不同位置之间的关系,还可以进行高效的并行计算。

本来两者并不相交,但2020年Vision Transformer[10](ViT)的出现彻底打破了这一局面。ViT将图像分割成小块,然后经过Embedding层,将图像分割成小块与卷积神经网络中滑动窗口相似,Embedding层与卷积层相似,用来提取特征。Transformer本身也运用了ResNet模型中残差结构[11]。Swin Transformer[12]借鉴CNN架构,构建了4个Stage,每个Stage中都是类似的重复单元。因为两者有着藕断丝连的关系,目标检测迎来新的春天。DETR[13]展示了与成熟且高度优化的Faster RCNN[14]基线相当的准确性和运行时间,然后相继出现了Deformable DETR[15]、PnP-DETR[16]、Sparse DETR[17]、DINO[18]等。与本文最相似的是ConvNet[19],但是它只是一味地学习Transformer并没有做出其他的改进,而且并没有研究改进后对目标检测的影响和意义。所以本文在其基础上去掉了一些操作,并新增对1×1的卷积进行Channel Sparse Connection操作,进一步减少参数量。在提升其特征提取能力的同时,也修改了原来的loss函数,使其能更加精准地回归。

车辆识别是计算机视觉领域的重要研究方向之一,也是无人驾驶、智能交通等领域的核心技术之一。由于车辆种类众多、车型差异较大,同时在不同场景下存在着遮挡、光照变化、视角变化等问题,使得车辆识别任务面临着巨大的挑战。因此,改善车辆识别过程中的识别准确度和鲁棒性,特别是解决小尺寸、低分辨率、遮挡等问题已经成为该领域的研究热点。通过采用深度学习等技术手段,不断改进车辆识别算法和模型,可以提高车辆识别的准确度和效率,拓展车辆识别技术的应用领域,为实现智能交通和智慧城市的建设做出贡献。UA-DETRAC数据集遮挡和小目标情况都较为复杂,所以本文在此数据集上验证改进后模型的效果。

1 Faster R-CNN模型介绍

Faster R-CNN从提出到现在是非常经典的双阶段检测算法。该算法共分为4个阶段:(1)将处理好的数据导入backbone(VGG16)内提取图片特征;(2)将特征图输入RPN网络得到位置回归和分类得分并获得proposals;(3)将pro-posals与特征图经过ROI Pooling层融合后生成大小一致的特征图;(4)全连接层将第3个阶段中得到的特征图进行类别分类和位置回归,得到检测框的位置信息及得分。Convmc block如图1所示。

2模型改进

2.1 Convmc

(1)改变block的比例

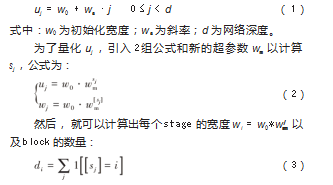

ResNet的stage最初是依靠经验设计的,并没有给出合理的解释。其中具有较大比例的“conv4_x”stage旨在兼容目标检测等下游任务。Swin-T遵循了同样的规律,只是block的比例有所不同(为1∶1∶9∶1)。于是按照这种规律把ResNet-50的block比例从3∶4∶6∶3改为3∶3∶27∶3,但是这样增加了FLOPs。这一方法可以用式(1)来表示:

(2)ResNeXt

本文采用与ResNeXt相同的想法,因为该想法在权衡FLOPs和Accuracy之间比ResNet更好。ResNeXt在瓶颈块的3×3卷积层中采用了分组卷积操作,明显减少了FLOPs,因此扩展了网络宽度,弥补了损失。

深度卷积和1×1卷积的组合导致空间和通道混合分离,这是Vision Transformers共享的属性,其中每个操作仅在空间或通道维度上混合信息,而不是两者都混合。使用深度卷积有效地减少了网络的FLOPs,同时也降低了精度。本文使用的DW卷积是分组卷积的一种特殊情况,其中组数等于通道数。DW卷积已经被成熟地运用在MobileNet[6]和Xception[20]。DW卷积类似self-attention的加权求和操作,在每个通道基础上操作,混合了空间纬度上的信息。DW卷积和1×1卷积的结合会使空间和通道维度分离,这是Transformers的一个属性,其操作只能混合其中一个维度的信息,不能同时混合两者。

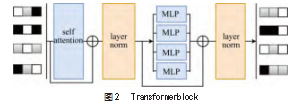

MLP是真正意义上的全局感知,因为按传统的操作MLP需要为所有的feature都建立权重来进行全局感知,而self-attention是对空间位置的feature进行全局感知。其优势是使用self-attention做全局感知比使用MLP做全局感知有更小的参数和计算量,但显然它们是不同的全局感知,MLP比self-attention更有全局性。

如图2所示,目前视觉Transformer模型中self-atten-tion后面都会接MLP,但这些都不是按传统思路来使用MLP,仅是对空间位置的feature进行全局感知,没有进行channel之间的交互。此时,self-attention的优势就表现出来了,虽然self-attention也是对空间位置的feature进行全局感知,但它能够将channel之间的信息利用起来。

(3)随机混合

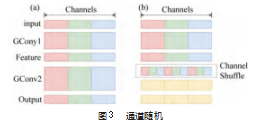

本文发现这些网络存在一个弊端,在所有通道上进行pointwise convolution,比如Resnext模型中1×1卷积基本上占据了93.4%的乘加运算,那么对1×1卷积也采用channel sparse connection,可以有效减少网络的FLOPs。但是分组卷积存在弊端,如图3(a)所示,GConv为分组数为3的分组卷积,可以发现不同组之间的特征图是不互通的,这明显会降低网络的特征提取能力,密集的1×1卷积可以保证分组卷积后不同组之间的信息交流。但是达到上述不同组之间的信息交流并不一定要采用密集的1×1卷积,如图3(b)所示,可以在组卷积后对通道进行均匀的重组。

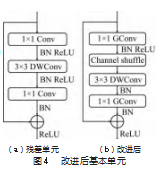

基于上面的设计理念,首先构造基本单元,如图4所示。基本单元是在一个残差单元的基础上改进而成的。图4(a)所示为一个包含3层的残差单元:首先是1×1卷积,然后是3×3的DWConv(Depthwise Convolution),这里的3×3卷积是瓶颈层(bottleneck),紧接着是1×1卷积,最后是一个短路连接,将输入直接加到输出上。

现在进行如图4(b)的改进:将密集的1×1卷积替换成1×1的Group Convolution,在第一个1×1卷积之后增加了一个Channel shuffle操作。对于残差单元,3×3卷积后不再增加Channel shuffle。在ResNet网络中,通常将ReLU激活函数和BN层添加到每个卷积层后。在Transformer的block中只有一个激活函数和少量的LN,所以可根据ResNet中的激活函数和BN层保留相同位置的激活函数与BN层,以减少计算量。

(4)更大的卷积核

在Vision Transformers中最为不同的就是非局部注意力,它的每一层都拥有全局感受野。在CNN中一般都是按照VGGNet的操作,堆叠3×3的卷积核,这在硬件上实现了GPU加速。当其步入CV领域中也在block中引入了滑动窗口,但是其大小最小为7×7。

对于上述ResNext,一般认为加入更多的groups比增加深度和宽度更加有效果,网络层数越深,网络表达能力越好,但是由于感受野的原因,较小的物体无法在特征图上体现,导致小目标检测效果不好。在Deep-Labv3+[21]中作者尝试改进了Xception,其主要就是采用Depthwise Separable Convolution,这使Xception计算量更小并且没有发生空洞卷积grid问题,猜测这样的原因是因为深度可分离卷积增加了特征图的密度和连续性,所以将直接使用较大的7×7卷积核。

2.2 LOSS函数

IoU常常在目标检测中用来是衡量预测框位置的准确性。但是IoU存在一些缺陷,当预测框与真实框没有交集的时候其IoU=0,无法进一步反映哪个预测框与真实框效果更好。当其重合面积一样时也无法准确反映哪个更加有效。CIoU(Complete IoU)损失函数的公式如下:

式中:S=1-IoU为预测框与真实框重叠区域的面积;D为预测框与真实框中心点之间归一化的距离损失;V用来度量长宽比的相似性。S、V和D都对回归保持尺度不变,并被归一化为0~1之间的值。

CIoU考虑了目标框之间的长宽比例、重叠面积和中心点距离等因素,这些因素可以帮助模型更好地区分相似的目标框,处理小目标和遮挡目标有着非常大的帮助,所以CIoU具有更好的鲁棒性。

3实验分析

3.1数据集的介绍与选取

UA-DETRAC数据集由Cannon EOS 550D摄像头在中国北京和天津24个不同地点拍摄的10 h的视频组成。一共有82 085张图片,分辨率为960×540像素,本文随机选取了13 667张图片,包含了4种天气,场景密集遮挡严重等情况,并按照7:3分为训练与验证集,如图5所示。

3.2实验环境

实验在Windows操作系统(64位)中运行,处理器(CPU)为AMD R5-5600,运行内存为32 GB,固态硬盘4 T;显卡(GPU)采用NVIDIA GTX3090TI,24 GB显存;编程语言使用Python3.7,深度学习框架为Py-torch,安装Anaconda3并配备CUDA11.3运算构架和cudnn深度学习加速库。

3.3实验结果分析

本文AP、AR均为IoU在[0.5,0.95]区间内,步长为0.05时10次的平均值。APs为像素面积小于322,APm为像素面积为322~962,APl为像素面积大于962。

如表1所示,在AP下本文方法比YOLOv7、YO-LOv5、Cascade RCNN、CoupleNet、R-FCN、Faster RCNN分别提高了3.3%、5%、6.69%、12.68%、16.63%、20.20%。本文方法对于小目标、中等目标及大目标检测的AP、AR值均是最高。所提出的方法对于小目标和中等目标比原Faster RCNN方法分别提升了45.8%和23%,大目标检测精度从73.9%提升至89.7%,提升了15.8%。本文方法对比目前较新YOLOv7,在小目标检测有着显著提升,提升了16.2%,在YOLOv7具有优势的中等目标和大目标检测中仅提升了4.8%、1%。由此可得出如下结论:由于小目标和中等目标存在的遮挡情况最为严重不宜被检测出来,所以本文方法针对小目标和中等目标提升较为明显,也证明了本文方法对小目标及遮挡目标检测问题有很大的改善。

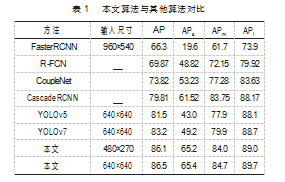

网络消融实验结果如表2所示,其中,A为Multi-ScaleRoIAlign。本文将原Faster RCNN对本数据集进行初步处理(使用k-means算法和MultiScaleRoIAlign)后,精度有较高提升,在此基础上将backbone替换成ResNet 50后发现各项性能都有提高,其中小目标的效果最为明显,可能是因为ResNet50具有更深的网络结构、更强的特征表达能力、更大的感受野,可以更好地处理复杂场景,以更好地捕捉小目标的特征信息。然后加入分组卷积,在参数量差不多的情况下AP有略微提升,主要是来自中等目标和大目标的提升,小目标反而下降了3.37%。然后使用7×7卷积核,并将其上调使其成为倒瓶颈结构,AP提升了0.72%,在APs只下降0.09的情况下进一步提高了APm和APl的准确率,并在召回率上全面提升。最后,引入CIoU小目标以更好地回归,使所有参数都达到最高。

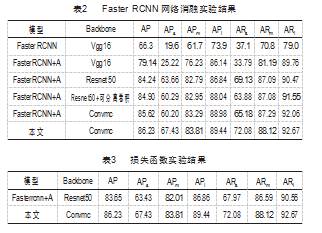

损失函数实验结果如表3所示。将改进的Backbone换回原来的ResNet50,发现除了APl、ARl其各方面反而略有下降。猜想直接用CIoU并不会提升准确率的原因是数据集信息较为复杂,而原本特征提取网络并没有很好地提取特征信息,所以即使使用CIoU减少损失,但准确率依然没有提升。这正好说明了本文的改动是有效的,新的特征提取网络可以更加有效地提取更多细节。

4结束语

针对车辆目标较小、遮挡较严重等问题,本文以Faster RCNN为基本框架,将其锚框调为较优状态后,使用参考Transformer模型改进后的Convmc作为骨架网络并结合CIoU损失函数,改进后的模型大幅且全面提高了精度,特别是小目标和中等目标分别提升45.8%和23%;在召回率方面,本文对小、中大目标分别提升了34.98%、17.32%和13.67%,说明改进后的网络结构可以有效解决目标较小和遮挡造成较小等问题,也说明了Transformer的成功经验同样适用于CNN网络,为以后更加深入研究卷积网络做出了铺垫和参考。但是本文仍然不足,为了彰显Transformer的有效性,有些地方并没有做出最优解也没有进行最优解验证。

参考文献:

[1]Vaswani A,Shazeer N,Parmar N,et al.Attention is All you Need[C]//Advances in Neural Information Processing Systems,2017.

[2]KRIZHEVSKY A,SUTSKEVER I,HINTON G E.ImageNet clas-sification with deep convolutional neural networks[J].Communi-cations of the ACM,2017,60(6):84-90.

[3]SIMONYAN K,ZISSERMAN A.Very deep convolutional net-works for large-scale image recognition[EB/OL].2014:arXiv:1409.1556.http://arxiv.org/abs/1409.1556.pdf.

[4]HE K M,ZHANG X Y,REN S Q,et al.Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vi-sion and Pattern Recognition.Las Vegas,IEEE:2016.

[5]Xie S,Girshick R,Dollar P,et al.Aggregated Residual Transforma-tions for Deep Neural Networks[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition.IEEE,2017:5987-5995.

[6]HOWARD A G,ZHU M L,CHEN B,et al.MobileNets:efficient con-volutional neural networks for mobile vision applications[EB/OL].2017:arXiv:1704.04861.http://arxiv.org/abs/1704.04861.pdf.

[7]SANDLER M,HOWARD A,ZHU M L,et al.MobileNetV2:invert-ed residuals and linear bottlenecks[C]//2018 IEEE/CVF Confer-ence on Computer Vision and Pattern Recognition.Salt Lake City,IEEE:2018:4510-4520.

[8]Howard A,Sandler M,Chen B,et al.Searching for MobileNetV3[C]//2019 IEEE/CVF International Conference on Computer Vi-sion.Korea(South):IEEE,2019:1314-1324.

[9]ZHANG X Y,ZHOU X Y,LIN M X,et al.ShuffleNet:an extremely efficient convolutional neural network for mobile devices[C]//

2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake,IEEE:2018.

[10]DOSOVITSKIY A,BEYER L,KOLESNIKOV A,et al.An image is worth 16x16 words:transformers for image recognition at scale[EB/OL].2020:arXiv:2010.11929.http://arxiv.org/abs/2010.11929.pdf.

[11]LIU Z,LIN Y T,CAO Y,et al.Swin Transformer:hierarchical Vi-sion Transformer using Shifted Windows[EB/OL].2021:arXiv:2103.14030.http://arxiv.org/abs/2103.14030.pdf.

[12]Liu Z,Lin Y,Cao Y,et al.Swin Transformer:Hierarchical Vision Transformer using Shifted Windows[EB/OL].2021:arxiv:2103.14030.http://arxiv.org/abs/2103.14030.

[13]Carion N,Massa F,Synnaeve G,et al.End-to-End Object Detec-tion with Transformers[C]//Vedaldi A,Bischof H,Brox T,et al.Computer Vision-ECCV 2020.Springer International Publish-ing,2020:213-229.

[14]Ren S,He K,Girshick R,et al.Faster R-CNN:Towards Real-Time Object Detection with Region Proposal Networks[EB/OL].2016:arxiv:1506.01497.http://arxiv.org/abs/1506.01497.

[15]ZHU X Z,SU W J,LU L W,et al.Deformable DETR:deformable transformers for end-to-end object detection[EB/OL].2020:arXiv:2010.04159.http://arxiv.org/abs/2010.04159.

[16]ROH B,SHIN J,SHIN W,et al.Sparse DETR:efficient end-to-end object detection with learnable sparsity[EB/OL].2021:arX-iv:2111.14330.http://arxiv.org/abs/2111.14330.

[18]Zhang H,Li F,Liu S,et al.DINO:DETR with Improved DeNois-ing Anchor Boxes for End-to-End Object Detection[EB/OL].2022:arxiv:2203.03605.http://arxiv.org/abs/2203.03605.

[19]Liu Z,Mao H,Wu CY,et al.A ConvNet for the 2020s[EB/OL].2022:arxiv:2201.03545.http://arxiv.org/abs/2201.03545.

[20]CHOLLET F.Xception:deep learning with depthwise separable convolutions[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Honolulu,HI,USA.IEEE,2017:1800-1807.

[21]CHEN L C,ZHU Y K,PAPANDREOU G,et al.Encoder-decod-er with atrousseparable convolution for semantic imagesegmen-tation[EB/OL].2018:arXiv:1802.02611.http://arxiv.org/abs/1802.02611.pdf.