面向消防需求的火焰快速检测方法论文

2024-05-29 11:34:08 来源: 作者:caixiaona

摘要:消防系统中的火焰检测设备在执行检测任务时存在精度低、实时性差等问题, 会导致误报率较高, 发现不及时, 从而错过 施救的最佳时机。为了解决上述问题, 以 YOLOv7-tiny 算法为基础, 对 ELAN-tiny 结构进行改进, 设计 ELAN-TP结构, 该结构大 量减少了原结构的冗余计算。为提高主干网络的特征提取能力, 在主干网络的末端引入 ConvNeXt 结构。使用SimAM 注意力机制对 颈部网络结构进行改进, 增加模型对目标的定位精度以及对不同尺寸特征的融合能力。结果表明: 改进模型的火焰检

摘要:消防系统中的火焰检测设备在执行检测任务时存在精度低、实时性差等问题,会导致误报率较高,发现不及时,从而错过施救的最佳时机。为了解决上述问题,以YOLOv7-tiny算法为基础,对ELAN-tiny结构进行改进,设计ELAN-TP结构,该结构大量减少了原结构的冗余计算。为提高主干网络的特征提取能力,在主干网络的末端引入ConvNeXt结构。使用SimAM注意力机制对颈部网络结构进行改进,增加模型对目标的定位精度以及对不同尺寸特征的融合能力。结果表明:改进模型的火焰检测精度mAP 50达到了57.7%,相较于原模型提升了4.8%,FPS(检测帧率)达到了97,提升了13。将改进后的模型在边缘计算设备Jet-son Nano上部署,FPS在20上下波动,满足了实时性的需求,能够较好地在各种场景下执行火焰检测任务,具有较高的实用价值。

关键词:火焰检测;消防设备;轻量化;注意力机制

0引言

火灾在日常生活中极为常见,在各种生活场景下均容易发生,蔓延迅速并且危害性较大,若不能及时发现,将严重威胁人们的生命和财产安全。因此,在火灾发生初期对其进行精确和快速的检测极为重要。基于传统传感器的火焰检测方式通常会受到环境的拘束,部署难度大,安装成本高,并且实时性较差。随着科技的发展,基于深度学习的方法在火灾检测领域得到了广泛应用。基于深度学习的目标检测算法通常分为双阶段和单阶段2种框架。具有代表性的双阶段目标检测算法有Fast R-CNN[1]、Faster R-CNN[2]和Mask R-CNN[3]等。单阶段的代表性目标检测算法有YOLO[4](You Only Look Once)等基于回归的目标检测框架,同时YOLO系列的算法也是现阶段主流的目标检测算法。为了使深度学习算法能够在边缘计算设备上执行,许多针对大网络的轻量化改进方案被提出。文献[5]在YOLOv4的基础上添加一个低维检测头,增强了模型对小尺寸火焰的检测能力。并在CSP模块中嵌入了DenseNet网络,加强了模型对不同火焰特征的复用,抑制过拟合,在牺牲了少量实时性的情况下,提高了检测精度。文献[6]在YOLOv5的C3模块中嵌入了CA注意力机制,提出了一种间隔注意力结构,提升了定位精度并且降低了漏检率。文献[7]中将Trans-former编码器嵌入到YOLOv5的CSP模块中,将原始的特征提取网络由单一的CNN架构变成CNN+Transformer架构,解决了原始网络中CNN结构全局特征提取能力不足的问题。文献[8]采用多重迁移学习的方法训练YOLOv5火灾探测模型,提高了模型对初期火灾的探测精度。文献[9]在YOLOv3主干网络中嵌入自注意力模块,提高了获取特征信息的差异的能力,使网络倾向于关键特征的提取。文献[10]以YOLOv5为基础,通过在颈部网络引入BIFPN加权双向特征金字塔特征融合,实现了简单快速的多尺度融合。

为在边缘设备上较好地实现火焰检测功能,本文以YOLOv7[11]的轻量化模型YOLOv7-tiny算法为基础,针对YOLOv7-tiny在执行火焰检测任务时存在的精度差、检测速度慢等问题进行了一系列改进,使得模型计算量和参数量大幅度减少的情况下,提升了检测精度和速度。

1 YOLOv7-tiny算法概述

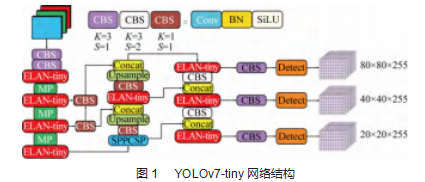

YOLOv7是Alexey Bochkovskiy团队提出的一种基于深度学习的目标检测算法。其网络结构由输入端、主干特征提取网络、颈部特征融合网络以及检测头4个部分组成。该算法在检测精度和速度上都超过了此前所有的目标检测模型。YOLOv7-tiny是将YOLOv7的网络进行精简而得到的轻量化模型,其模型及组件框架如图1所示。输入端沿用了Mosaic数据增强技术,YOLOv7-tiny的主干特征提取网络包含了CBS、ELAN-Tiny和MP结构。其中,CBS结构负责对输入到模型的图像进行初步的特征提取。ELAN-Tiny是一种高效的层聚合网络,通过设置梯度路径的最小值和最大值,可以使较深层的网络进行有效地学习和收敛。MP结构负责对提取到的特征进行池化,能够增大感受野,提高网络的学习效率。YO-LOv7-tiny的颈部特征融合网络采用了FPN和PAN相结合的方式,该结构可以将不同尺度的特征进行融合复用,提高模型对不同尺度目标的检测精度,其中SPPCSP结构使用了3个不同尺寸的池化核,将不同感受野的特征图进行融合,丰富了模型的表征能力。模型的检测头用于输出最终的检测结果。

2 YOLOv7-tiny火焰检测算法改进

2.1 ELAN-tiny结构

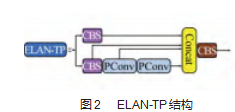

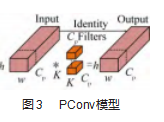

在此前的轻量化算法中,为了提高目标检测的实时性,通常是以降低FLOPs(每秒浮点计算量)来设计更加快速的神经网络。然而大量的实验数据表明,降低FLOPs并不一定会使模型在执行目标检测任务时的延迟减小到预期值。这是因为在进行浮点计算时会频繁地进行内存访问,导致FLOPS(每秒浮点操作数)较低。ELAN是YOLOv7算法中的高效层聚合结构,YOLOv7-ti-ny中裁剪该结构的2组CBS,本文将裁剪后的ELAN称为ELAN-tiny。该结构的参数量相比于ELAN有所下降,但是在特征传播过程中仍然会产生大量的冗余计算。为了进一步减少该结构的冗余计算,提高其学习特征的效率,实验中引入了Partial Covolution[12](PConv)对ELAN-tiny结构进行改进,将ELAN-tiny中大小为3×3,步长为1的卷积核替换为PConv,提出了ELAN-TP结构,其结构如图2所示,PConv的运算模式如图3所示,它只会对部分输入通道用常规的Conv运算进行特征提取,剩余的通道不参与卷积运算。在进行连续的内存访问时,PConv将第一个或最后一个连续的Cp通道作为整个特征的代表进行计算。PConv的每秒浮点计算量FLOPs为:

h×w×k2×C(1)

内存访问量为:

h×w×2Cp+k2×C≈h×w×2C(2)

2.2结合ConvNeXt的主干网络

主干网络的优化有利于提高检测效率和精度。CV领域有许多针对准确性、效率以及可拓展性等问题而设计的卷积神经网络,如VGGNet[13]、ResNet[14]、MobileNet[15]和Efficient[16]等。Vision Transformer[17]是一种基于自注意力机制的神经网络,在CV领域有着优秀的表现,具有精度高和拓展性好等优点。然而Transformer的计算量大,在目标检测等计算机视觉的下游任务中,Transformer需要通过大量的数据在长时间的训练情况下才能达到较好的效果。ConvNeXt[18]是最新的CNN架构之一,相比于其他经典的卷积神经网络有着更好的性能,该模型借鉴了Swin Trans-former[19]的优点,对RestNet结构进行了创新,ConvNeXt的整体结构与ResNet相似,但性能与其相比有较大的提升,且比基于Transformer的模型更容易训练,该结构以较低的计算成本实现了与Transformer相比拟的精度与可拓展性。在进行具有相当参数量的目标检测任务时,ConvNeXt的性能表现均优于Swin transformer。ConvNeXt按照参数量的大小分为T、S、B、L共4种版本,为保证模型的轻量化,本文采用ConvNeXt-T对主干进行改进,其参数设置为C=(96,192,384,768),B=(3,3,9,3),其中C表示ConvNeXt中4个阶段的输入通道数,B表示每个阶段堆叠ConvNext Block的次数。ConvNeXt-T结构如图4所示。

YOLOv7-tiny的网络深度相对于YOLOv7有比较大的缩减,导致主干对特征提取的能力有一定程度的减弱,在执行火焰检测任务时容易出现漏检、误检等问题。为了不破坏原网络主干的连续性,将ConvNeXt-T引入到主干网络的末端,以加深主干网络的深度,从而提升主干的特征提取能力。

2.3结合SimAM的颈部网络

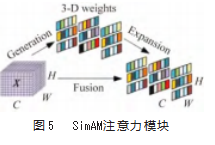

当前许多主流的注意力机制主要是作用在通道域或空间域,它们都是先分别生成特征图的一维或二维权重,然后再将这些生成的权重作用到通道域或空间域。这些方法都是把每个通道或者每个空间位置上的神经元进行同等级别的运算,会耗费较大的资源,不能高效地计算出特征的三维权重,并且会导致生成的注意力权重的不灵活性,限制了网络学习更多特征的能力,也不利于模型的轻量化。例如CBAM[20]注意力模块,它虽然综合了特征的通道域以及空间域的权重,但只是分别将计算出来的一维和二维权重进行了组合,并不是真正生成了三维权重,并且该结构的参数量较大,不利于构建轻量化网络。SimAM[21]定义了一个基于神经科学理论的能量函数,并且推导出了一个可以使模型快速收敛的解决方案,该机制同时考虑了特征图的空间域和通道域的权重,且该结构能够在完全不增加原网络参数的情况下计算出三维权重,其灵活性有助于在对网络进行改进时不必对网络的原始结构做过多的调整。因此在许多情况下,Si-mAM的性能都优于CA[22]、SE[23]、ECA[24]、GAM[25]等当前主流的注意力机制。为了在保持模型轻量化的同时,使颈部网络更加高效地对主干网络提取到的多尺度特征进行融合以及复用,提升模型的定位精度,改善模型在复杂背景下对火焰检测的能力,本文在颈部网络中引入了Si-mAM注意力机制,其结构如图5所示。

SimAM通过在目标火焰的相邻神经元上产生空间抑制来减少复杂背景对火焰检测的影响,并且突出火焰的关键特征,提高了模型对火焰特征的提取能力。计算过程如下:

=sigmoid(1/E)⊗X(3)(4)(5)(6)式中:X为输入的火焰特征,为增强的火焰特征;E为每个特征通道的能量函数,能量函数值越低,目标特征神经元与相邻神经元的分化程度越高,模块中采用了sigmoid函数来防止值过大对模型产生不利影响;⊗为点乘运算;μ为输入火焰特征图中各通道的均值;σ2为输入火焰特征图中各个通道的方差;λ为一个超参数;t为输入特征中的目标火焰的神经元,t是输入特征中的其他神经元。是该通道上的神经元的数量。

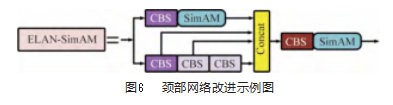

为了使模型达到最佳效果,本文将YOLOv7-tiny原始算法的颈部网络与SimAM进行了如图6所示的结合。

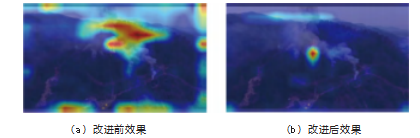

图7所示为该模块对特征提取效果进行可视化后的对比结果。由图可知,引入注意力SimAM注意力模块后,模型能够更加精确地定位到目标区域,提高了模型的学习效率。

3实验与结果分析

3.1数据集与实验环境

实验分别从Bow Fire Dataset(https://bitbucket.org/gb-di/bobowfi-dataset/downloads/),Kaggle数据集(https://www.kaggle.com/datasets/phylake1337/fire-dataset)以及互联网上共收集了4 540张不同场景下的火焰图像来验证改进算法的有效性,其中80%为训练集(3 632张),30%为测试集(908张)。输入图像尺寸大小为640 pixel×640 pixel,数据集示例如图8所示。

实验使用Windows10操作系统,环境配置为Py-thon3.8.10、Pytorch1.7.1,服务器配置为Intel i5-12490F,显卡为RTX2080Ti,11 GB显存,迭代次数设置为300,batch size设置为32。

本文将训练好的改进模型PCS-YOLO在验证集上测试其性能,所选用的评估指标分别为模型参数量(Params)、浮点计算量(GFLOPs)、平均检测精度(mAP 50)、检测帧率(FPS),其中mAP 50与精度(Precision)和召回率(Recall)相关,它的数值是评估模型检测性能的关键指标,推导过程如下:

PPrecision=×100%(7)

R Recall=×100%(8)

PAP=(9)

PmAP=×100%(10)

式中:PPrecision为精度;RRecall为召回率;XTP为被判定为火焰的火焰样本数;XFP为被判定为火焰的非火焰样本数;XFN为被判定为非火焰的火焰样本数;c为总类别数;PAP为单个目标类别的平均精度。mAP 50为IOU阈值为0.5时对所有类别的平均检测精度。

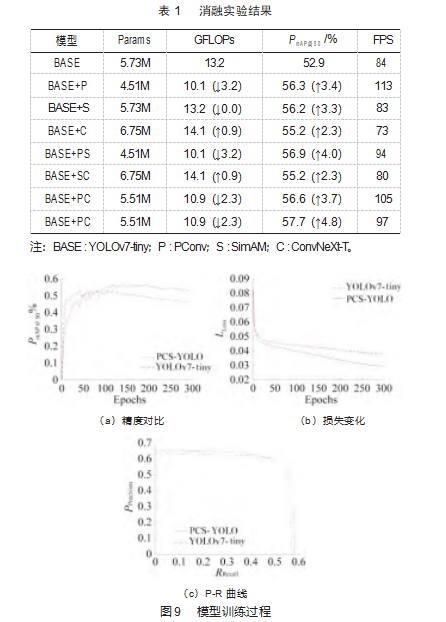

3.2消融实验

将提出的各项改进点按不同的组合进行消融实验,以验证各项改进对模型检测性能的影响。消融实验结果如表1所示。由表可知,在单独引入PConv时,模型的参数量与计算量较大幅度的下降,mAP 50提升了3.4%。单独引入SimAM时,在保持参数量和计算量不变的情况下,mAP 50提高了3.3%。在模型中单独引入ConvNext时,参数量和计算量有小幅增加,mAP 50提高了2.3%。在同时引入PConv和SimAM时,mAP 50提升了4.0%,在同时引入PConv和ConvNext时,mAP 50提升了3.7%。实验结果表明,将模块组合引入的效果均好于单独引入各模块的效果。将以上3种改进同时引入YOLOv7-tiny时,模块的总参数量相比于Base降低了0.22 M,计算量降低了2.3 GFLOPs,精度提高了4.8%,FPS达到了97。模型训练过程如图9所示,分别展示了经过300轮的迭代后算法的平均检测精度变化,训练损失值的变化以及P-R曲线。改进后模型的平均检测精度更高,最低损失值可以降低到0.03左右,具有更快的收敛速度,P-R曲线与坐标轴围成的面积更大,因此模型的综合表现更好。为了证实SimAM相比于其他主流的注意力机制更适用于本文所提出的火焰检测算法,将同时引入PConv与ConvNeXt的模型命名为模型M,分别将模型M与其他5种主流注意力机制在与SimAM相同的位置处引入后进行实验,结果如表2所示。由表可知,PCS-YOLO的检测精度以及速度均高于其他改进方案,验证了本文所提出的改进方案的合理性。

为对改进模型进行有效性验证,实验选取了不同场景以及视角下的火焰场景进行测试,检测结果如图10所示。

由图可知,改进模型在对目标火焰的定位准度和检测精度都有提升,展现了较好的检测性能,尤其是对小型火焰的检测能力有一定的提升,使消防系统能够及时捕捉到早期火焰。

3.3对比实验

为验证提出的改进模型CS-YOLO优于其他主流的YOLO轻量化模型,分别将其与YOLOv3-tiny、YOLOv4-tiny、YOLOv5n、YOLOx-nano进行对比实验,结果如表3所示。由表可知,PCS-YOLO有着最高的检测精度和较快的检测速度,进一步验证了本文提出的模型的合理性。

3.4实物验证

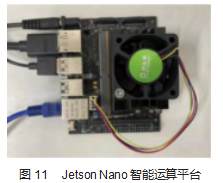

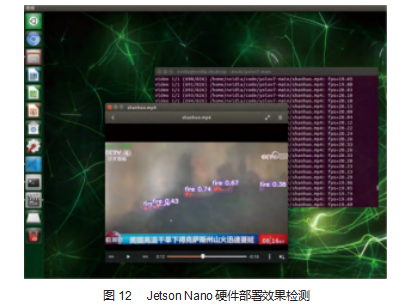

在嵌入式设备Jetson Nano上搭建了测试环境,通过该平台来验证PCS-YOLO在真实火焰场景下的实时性。

该设备的实物如图11所示,它是一款边缘AI计算设备,搭载了四核ARM Cortex-A57处理器,128核MAXWELLGPU以及4 GB LPD-DR内存。将已经训练好的模型转换成TensorRT格式后部署在该硬件平台上,选取一段由央视公布的航拍视角下的山火录像进行火焰检测,运行结果如图12所示。该模型在平台上执行检测任务时的FPS在20左右的区间波动,因此,改进后的模型能够在边缘设备上对火焰进行实时检测,具有较好的实用价值。

4结束语

为了满足消防系统中的智能设备对火情检测的实时性和准确性的需求,本文以YOLOv7-tiny算法为基础,结合PConv、ConvNeXt以及SimAM对其进行了改进,提出了PCS-YOLO模型。并且通过多组实验对模型的有效性进行了充分的验证。

实验结果表明,与YOLOv7-tiny相比,PCS-YOLO火焰检测算法的检测精度达到了57.7%,提升了4.8%。PFS达到了97,提升了13。验证集上的检测结果表明,改进后的模型对火焰进行检测的精度和准度均有较大的提高。

将改进后的模型部署到边缘计算设备Jetson Nano上进行了实物验证。结果表明,模在实际应用中具有较高的精度,并且FPS稳定在20左右,满足日常消防需求,具有较高的实用价值。

参考文献:

[1]GIRSHICK R,DONAHUE J,DARRELL T,et al.Rich feature hier-archies for accurate object detection and semantic segmentation[C]//Proceedings of the 2014 IEEE Conference on Computer Vi-sion and Pattern Recognition.IEEE,2014:580-587.

[2]REN S Q,HE K M,GIRSHICK R,et al.Faster R-CNN:towards real-time object detection with region proposal networks[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

[3]HE K M,GKIOXARI G,DOLLÁR P,et al.Mask R-CNN[C]//2017 IEEE International Conference on Computer Vision.Venice:IEEE,2017:2980-2988.

[4]REDMON J,DIVVALA S,GIRSHICK R,et al.You only look once:unified,real-time object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas:IEEE,2016:779-788.

[5]马庆禄,唐小垚.嵌入Dense Net的YOLOv4多尺度隧道火灾检测算法[J].计算机仿真,2023,40(4):120-127.

[6]张震,晋志华,陈可鑫.改进YOLOv5算法在停车场火灾检测中的应用[J].郑州大学学报(工学版),2023,44(4):16-21.

[7]LIN J,LIN H F,WANG F.A semi-supervised method for real-time forest fire detection algorithm based on adaptively spatialfeature fusion[J].Forests,2023,14(2):361.

[8]蒋文萍,蒋珍存.基于多重迁移学习的YOLO v5初期火灾探测研究[J].消防科学与技术,2021,40(1):109-112.

[9]冯庭有,蔡承伟,田际,等.基于YOLOv3的自注意力烟火检测算法[J].机电工程技术,2022,51(7):71-75.

[10]朱喆,黄勇,来春庆,等.改进YOLOv5的轻量化光伏热斑检测算法[J].机电工程技术,2023,52(8):16-21.

[11]WANG CY,BOCHKOVSKIYA,LIAO HY M.YOLOv7:trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]//2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Vancouver:IEEE,2023:7464-7475.

[12]CHEN J R,KAO S H,HE H,et al.Run,don't walk:chasing high-er FLOPS for faster neural networks[C]//2023 IEEE/CVF Con-ference on Computer Vision and Pattern Recognition.Vancou-ver:IEEE,2023:12021-12031.

[13]SIMONYAN K,ZISSERMAN A.Very deep convolutional net-works for large-scale image recognition[EB/OL].2014:arXiv:1409.1556.http://arxiv.org/abs/1409.1556.pdf.

[14]HE K M,ZHANG X Y,REN S Q,et al.Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vi-sion and Pattern Recognition.Las Vegas:IEEE,2016:770-778.

[15]HOWARD AG,ZHU ML,CHEN B,et al.MobileNets:efficient con-volutional neural networks for mobile vision applications[EB/OL].2017:arXiv:1704.04861.http://arxiv.org/abs/1704.04861.pdf.

[16]TAN M X,LE Q V.EfficientNet:rethinking model scaling for convolutional neural networks[EB/OL].2019:arXiv:1905.11946.http://arxiv.org/abs/1905.11946.pdf.

[17]DOSOVITSKIY A,BEYER L,KOLESNIKOV A,et al.An image is worth 16x16 words:transformers for image recognition at scale[EB/OL].2020:arXiv:2010.11929.http://arxiv.org/abs/2010.11929.

[18]LIU Z,MAO H Z,WU C Y,et al.A ConvNet for the 2020s[C]//2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition.New Orleans:IEEE,2022:11966-11976.

[19]LIU Z,LIN Y T,CAO Y,et al.Swin Transformer:hierarchical Vi-sion Transformer using Shifted Windows[C]//2021 IEEE/CVF International Conference on Computer Vision.Montreal:IEEE,2021:9992-10002.

[20]WOO S,PARK J,LEE J Y,et al.CBAM:convolutional block at-tention module[C]//European Conference on Computer Vision.Cham:Springer,2018:3-19.

[21]Yang L,Zhang RY,LiL,et al.Simam:A simple,parameter-free at-tention module for convolutional neural networks[C]//Internation-al conference on machine learning.PMLR,2021:11863-11874.

[22]HOU Q B,ZHOU D Q,FENG J S.Coordinate attention for effi-cient mobile network design[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Nashville:IEEE,2021:13708-13717.

[23]HU J,SHEN L,SUN G.Squeeze-and-excitation networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake:IEEE,2018:7132-7141.

[24]WANG Q L,WU B G,ZHU P F,et al.ECA-net:efficient channel attention for deep convolutional neural networks[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Seattle:IEEE,2020:11531-11539.

[25]LIU YC,SHAO ZR,HOFFMANN N.Global attention mechanism:retain information to enhance channel-spatial interactions[EB/OL].2021:arXiv:2112.05561.http://arxiv.org/abs/2112.05561.