基于触觉传感器阵列的机械手抓取分类方法研究论文

2023-10-19 14:19:50 来源: 作者:xieshijia

摘要:为了丰富机器人的感知能力,弥补触觉信息感知不足、解决触觉识别物体存在准确率不高的问题,基于磁性霍尔元件设计制作了可测量三轴正交接触力的触觉传感器,并将其集成为两种形状的触觉阵列安装在机械手上实现交互。搭建触觉识别系统对15种日常生活用品进行数据采集,采用卷积神经网络和注意力机制的触觉识别算法训练学习触觉数据,应用在识别日常生活物品分类场景中。实验结果表明,传感器的测量精度和最大重复性误差约为10-4 N和1.2%,具备良好的稳定性和灵敏度;设计的触觉识别算法的平均识别准确率最高可达94.49%,能够对抓取

摘要:为了丰富机器人的感知能力,弥补触觉信息感知不足、解决触觉识别物体存在准确率不高的问题,基于磁性霍尔元件设计制作了可测量三轴正交接触力的触觉传感器,并将其集成为两种形状的触觉阵列安装在机械手上实现交互。搭建触觉识别系统对15种日常生活用品进行数据采集,采用卷积神经网络和注意力机制的触觉识别算法训练学习触觉数据,应用在识别日常生活物品分类场景中。实验结果表明,传感器的测量精度和最大重复性误差约为10-4 N和1.2%,具备良好的稳定性和灵敏度;设计的触觉识别算法的平均识别准确率最高可达94.49%,能够对抓取到的物体进行准确分类,为机器人后续的探索交互任务奠定基础。

关键词:触觉传感器;注意力机制;机械手;分类识别

Research on Classification Method of Manipulator Grasp Based on Tactile Sensor Array

Zhou Cong 1,Liu Jiarui1,2,Sun Yaqiang1,2,Shu Lin1,2

(1.Guangdong Institute of Artificial Intelligence and Advanced Computing,Guangzhou 510530,China;

2.Institute of Automation,Chinese Academy of Sciences,Beijing 100049,China)

Abstract:In order to enrich the perceptual ability of the robot,make up for the lack of tactile information perception and solve the problem of

low accuracy of tactile object recognition,a tactile sensor is designed and fabricated based on the magnetic Hall element,which can measure

the three-axis orthogonal contact force.The tactile array is integrated into two shapes and mounted on the robot hand to realize the interaction.

The haptic recognition system is built to collect data of 15 kinds of daily articles.The haptic recognition algorithm of convolutional neural

network and attention mechanism is used to train and learn the haptic data,and the haptic data is applied to recognize the classification scene

of daily articles.The experimental results show that the measurement accuracy and maximum repeatability error of the sensor are about

10-4 N and 1.2%,and the sensor has good stability and sensitivity.The average recognition accuracy of the designed tactile recognition

algorithm is up to 94.49%,which can accurately classify the captured objects and lay a foundation for the subsequent exploration and interaction tasks of the robot.

Key words:tactile sensor;attention mechanism;manipulator;classification and recognition

0引言

机器人搭载的多种传感设备对于识别物体、拟人化感知和加强安全性操作等具有重要的意义。除了最常用的视觉能力外,触觉也是一种非常关键的感知能力,当视觉传感信息受到环境影响无法发挥作用时,触觉感知在对目标物的硬度和形状特征方面的信息描述具有极大优势,在机器人人机交互的外部环境探索、对目标物的分类识别、提高物体操作的安全性中都能发挥着非常重要的作用,应用场景十分广泛[1-3]。

国内外针对触觉传感器来感知识别物体的研究工作取得了很多进展[4-7]。触觉传感器通过拾取触觉传感器单元接触力信息组成的图阵列来描述相应的特性,因此研究者们常通过各种方式采集触点数据或增加触点特征信息来更精确地获取目标物体的形状属性。国内学者基于一种气压式触觉阵列传感器拾取触觉特征信息,结合随机森林方法进行分类[8]。也有文献基于电磁原理,建立触觉传感单元力测量模型,采用支持向量机算法进行分类识别[9]。但对于轻微力的响应还是不足,同时也存在算法识别准确率不高、适用范围过窄等问题。国外中,文献[10]使用一种平面传感器阵列板,该阵列板表面装有数千个触觉传感器,通过按压物体可以获取到所接触的触觉信息,然后以深度学习算法识别分类物体,但由于触觉平面阵列板体积太过庞大存在难以广泛使用以及无法处理各种几何形状物体等问题。针对在机械手上便携安装问题,有研究者[11]通过集成一款能感知材料的导热系数、接触压力、物体温度和环境温度的四重触觉传感器咱装在机械手上抓握识别7种类型垃圾。证明多维度信息融合的触觉传感器能提高识别准确率,不过该传感器成本过于昂贵。因此也有研究者[12]做了大量低成本的工作,制作了触觉手套抓握物体采集触觉数据,手套表面覆盖可获取单轴法向力的传感器548个,可动态测量30 mN~0.5 N量程大小法向力,融合多帧触觉数据作为输入,基于ResNet[13]卷积神经网络对物体分类,但从数据的获取以及算法的准确率还有可持续性提高的空间。

分类算法上,深度学习中的注意力机制[14]类似人类的选择性感知注意重要信息,核心目标是从众多信息中选择出对当前任务目标更为关键的信息,因其优秀的效果与即插即用的便利性,在深度学习分类任务中得到了越来越广泛的应用。

为此,本文研究一种三轴力触觉传感器阵列来获取特征信息更为丰富的法向、切向、径向三通道触觉信息,并贴附在机械手上对日常生活用品进行抓取实验,采用基于卷积神经网络和注意力机制的算法应用在触觉识别学习任务中,训练学习所采集的触觉数据集,分类识别选取的实验物品,优化分类模型的分类效果。

1方法描述

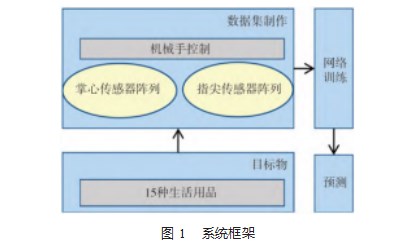

1.1分类系统框

为丰富机器人对外界的触觉感知能力,研究搭建基于三轴力触觉传感器阵列的一种机械手抓取识别分类系统。首先,基于磁性霍尔元件设计制作了可测量三轴正交接触力的触觉传感器,并将其集成为两种阵列安装在机械手上[15-16],对多种生活日常品进行抓握,通过抓握过程中手掌传感器阵列和指尖传感器阵列采集的触觉信息构建制作三通道触觉特征数据集;最后,根据组建的触觉数据集,并结合卷积神经网络和注意力机制的算法完成对目标物体的识别分类。具体如图1所示。

1.2硬件组成

1.2.1传感器阵列

在利用传感器拾取物体信息的过程中,触觉传感器反馈的三轴力信息的大小、不同位置传感器阵列的分布趋势都会影响着目标识别的准确率。因此需要传感器具备一定的感应灵敏度和重复性误差,便于后续的算法分类。本文研究的三轴触觉传感器阵列的核心模块是MLX90393,具有非常强大磁场感应能力,可轻松检测非常小的磁场变化和表面移动磁体的绝对位置,是用途广泛又微型的通用3D霍尔元件,可感测磁通密度3个正交分量法向、轴向、径向的变化,当接触压力作用在磁铁的触点时,磁铁的移动将引起霍尔元件处的磁场变化,输出磁通量变化数据,通过转换进而得到接触点负载的三轴力大小。

在制作过程中,采用真空挤压制作手法用硅胶对磁铁和感应芯片进行浇筑,此时可以通过按压包裹磁铁的硅胶能够有效的获取触觉的三轴压力数据,制作得到一种基于磁通变化的三轴触觉传感器阵列。基于此原理并结合手掌特点设计了两种形状的三轴触觉传感器阵列,并将其安装贴附在机械手上,具体如图2和图3所示,其中图2一种平面传感器阵列安装在手掌和手指指骨处,每个传感器阵列分布有4×4个触点单元,另一种安装在手指指尖,分布有3×5个触点单元,用于机械手抓取物体获取物体的触觉信息。设计的传感器阵列如2图所示。

1.2.2灵巧手

在本文触觉感知识别物体的分类实验中,灵巧手相对于二指、三指夹爪具有更明显的优势,拥有16个独立的扭矩控制接头,多种即用型抓取算法可以处理各种不同几何形状的物体对象,更能模拟人手的状态。同时,灵巧手是以逐渐贴合物体表面的方式来进行抓握物体表面的不同部位,能够避免刚性手抓握物体时的严重碰撞,也可以更好地获取物体形状信息。无须固定目标物具体位姿和复杂的抓取控制方案。

1.3分类算法

1.3.1注意力机制

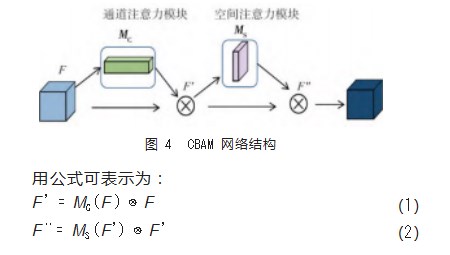

注意力机制类似人类大脑接收外界信号时的处理策略,跟人一样能够快速浏览整体信息并重点关注所需的目标区域,有选择性的处理重要信息。对于卷积网络中的三轴力触觉特征图数据而言,不但通道内部中不同传感器单元点间包含大量的注意力信息,而且三轴力三通道中也蕴含着丰富的通道注意力信息。本文引入混合双通道和空间的注意力机制模块[17](Convolutional Block At⁃tention Module Network,CBAM)来进一步提高物体识别分类的准确率。CBAM包含有2个子模块:通道注意力模块MC和空间注意力模块MS,如4图所示。

通道注意力机制作用于三轴触觉阵列信息特征图之间。依据卷积核生成的特征图对分类的权重效果不同,会通过通道注意力机制对每个通道的特征图加权处理。

通道注意力机制下,对输入的特征图F中各个通道首先经过两个不同的池化层,分别是全局最大池化和全局平均池化,在此之后连接1个两层的神经网络MLP,将结果通过激活函数Sigmoid输出,最后相乘加权到相应的特征通道上,更新各通道权重。用公式表示为:

MC(F)=σ(MLP(AvgPool(F)+MaxPool(F)))(3)

空间注意力机制作用于三轴触觉阵列信息每张特征图内,聚焦每个特征图内区域的特征,不关注各通道之间的差异。对各种形变数据在空间中进行转换并自动捕获重要区域特征。

在该空间注意力机制作用下,输入的特征图F将分别进行全局最大池化和全局平均池化,然后再按照通道拼接进行系列卷积操作,最后通过激活函数输出结果并与特征图F对应相乘,公式表示为:

MS(F)=σ(f7×7([AvgPool(F);MaxPool(F)]))(4)

1.3.2触觉识别网络

本文在卷积神经网络基础上进一步融合注意力机制,提出基于注意力机制的触觉识别深度卷积网络,如图5所示。结构主要包括有ResNet残差结构、批归一化(Bathch Normaliza⁃tion,BN)、CBAM注意力机制模块、Dropout层、池化层和全连接层。

其中,BN本质上解决的是反向传播过程中的梯度问题,防止梯度消失和爆炸。Dropout则是一种正则化技术,它随机剔除网络中的节点,以减少对训练数据的过拟合。池化层的主要目的是降低数据的维数。全连接层的主要作用就是将前层(卷积、池化等层)计算得到的特征空间映射样本标记空间。提高整个网络的鲁棒性。内部卷积层均采用ReLu非线性激活函数。

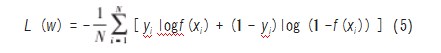

1.3.3网络训练

首先将触觉三通道信号输入到触觉识别网络中,模型中的触觉识别网络对三轴力触觉信息进行数据特征提取,最后经过全连接层得到对应的分类向量,通过使用随机梯度下降算法来优化网络权重的更新,所采用的损失函数为交叉熵损失函数,其计算公式为:

2实验验证与评估

2.1传感器性能测试

测试触觉传感器的性能,了解传感器感应灵敏情况和稳定情况,验证数据的有效性和差异性,如图6所示,搭建触觉传感器性能测试平台,该平台主要由液压装置、导轨、压力探针和支撑平台组成。

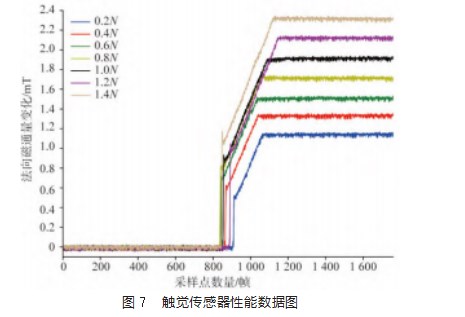

实验过程中,将三轴触觉传感器阵列固定在测试工作台上,设备通过丝杆控制进行移动,压力探针对准阵列中心位置的一个传感器单元,沿Z轴法向方向施加不同大小的载荷,进行加载和卸载的性能测试,每次卸载后重新负载,步长变化为0.2N,反复进行多次实验进行记录,选取其中一组法向磁通量数据在几种大小力下的变化情况,测试结果如图7所示。

探针先接触传感器,持续递增至预设负载的压力后保持不变,负载恒力保持一段时间,图示中为实验中连续采样的一段数据。通过计算,平面传感器阵列的灵敏度约为1.9 mT/N,即1 900μT/N,通过芯片参数得知传感器的分辨率为0.161μT,可以发现传感器具有良好的响应,测量精度能够达到10-4 N量级。此外,通过同样的操作实验10次,计算评测出最大的重复误差精度为1.2%,说明具有良好的稳定性,不会在重复使用的过程中发生严重偏差。

该实验结果表示,本文所制作的三轴力触觉传感器对于载荷具有良好的稳定性和灵敏度,能够满足分类实验的需求。

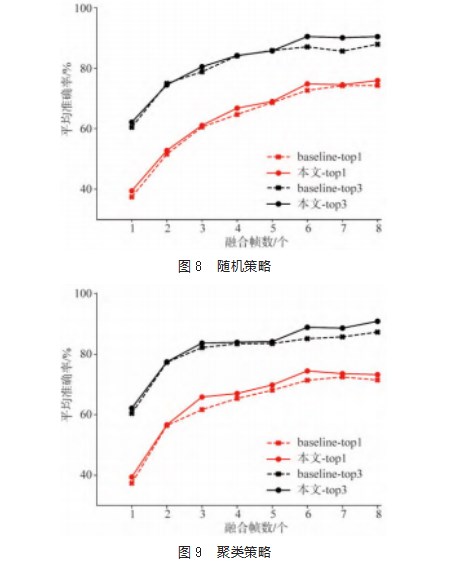

2.2网络模型评估

在文献[12]中的触觉classification_lite数据集上进行分类算法的比较。为了验证本文改进后的卷积网络模型的分类性能,对融合注意力机制的网络进行训练、验证,实验环境使用Ubuntu系统、GPU NVIDIA GeForce GTX 2080Ti显卡、Pytorch框架,超参数也同文献中的保持一致:应用0.001的初始学习率,每100个epoch减少10倍,训练200个epoch,每批32个样本,报告并对比5次训练运行的平均结果,分别使用两种数据训练策略:随机采样和聚类采样。选取1~8帧数据融合的情况,使用文献[6]和本文设计的两种网络、两种不同策略的识别准确率如图8和9所示。

图示中可以看出,在两种数据处理的策略下,相对于未融合通注意力机制CBAM的网络模型而言,融合注意力机制后的分类网络对物体识别的准确率效果更好。

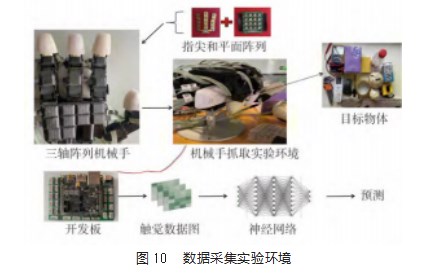

2.3分类实验

2.3.1数据集采集

使用机械手抓取15种日常生活用品,通过三轴传感器阵列获取触觉信息来制作数据集,实验环境搭建如10图所示。由数据采集开发板、机械手、两种形状的三轴力触觉传感器阵列、15种日常生活物体、计算机处理器和支撑物体平台组成。其中,这15种物体由不同的形状、硬度、材质组成,具体包含类别有:空物、纸巾包、瓶子、石头、球体、易拉罐、内六角组、木板、鼠标、遥控器、剪刀、万用表、卷尺、海绵、胶布。

实验中所使用的机械手是韩国Wonik公司所制造的型号为Allegro-hand的四指灵巧手,机械手具有4根手指,机械手的指尖关节、指骨和手掌掌心处都贴附有三轴传感器阵列,每个传感器阵列有16个触觉点单元。机械手通过法兰固定在桌子上,通过计算机控制机械手电机关节,驱动机械手的张开和闭合来抓取物体,采集触觉数据。

利用搭建的实验平台对数据采集实验时,首先会对目标进行预处理操作,确定一个初步的传感器抓取阈值,从而保证所有实验物体可以被稳定拾取,实验过程中,控制机械手匀速抓握,抓取过程中会适应并包裹住目标物体的形状形,当其中某部位三轴力触觉阵列达到设定的阈值时,完成稳定抓握,并采集此时的触觉数据信息。

通过抓取不同的物体,传感器三轴触觉阵列传感器压力分布区域和触觉压力值会有差异,可以作为物体分类识别的判断依据;采集过程中共采集15种类型物体,共计2.4万帧三轴力数据组成触觉数据集,按照3∶1划分为训练集和测试集。

2.3.2分类效果与分析

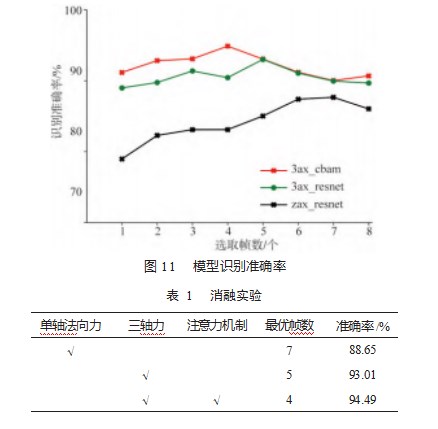

基于机械手和三轴传感阵列采集的数据集,选取文献[10]中的分类网络作为baseline与本文的分类网络进行对比,进行消融实验。验证三轴传感器数据信息、注意力机制对网络模型的影响。

实验结果如图11所示,经过三轴力三通道信息融合、添加注意力机制后,分类方法的平均识别准确率有明显的提升,其中,网络输入的三轴传感信号的特征信息影响最大,以本文算法为例,当取4帧时,模型的最大识别准确率可达94.49%。

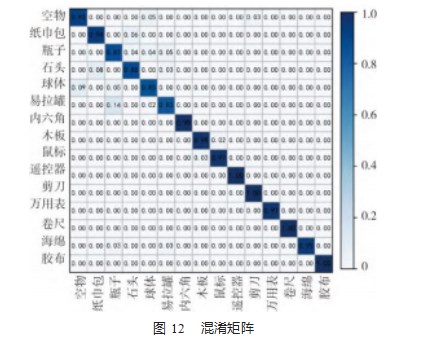

如图12所示,为了进一步可视化直观显示本文算法模型对15种日常生活用品的识别能力,依据分类结果制作了混淆矩阵。从图中可以看出:有多种物体的识别准确率可达100%,例如:遥控器、剪刀、卷尺和胶布,部分生活物品因为材质刚度等属性较为接近或者形状特征比较类似,导致实验过程中采集到的三轴力触觉信息特征相近,从而存在一些识别混淆,但从总体而言,模型的整体平均识别准确率比较高,保证了系统算法模型的分类识别效果。

3结束语

本研究制作了一种三轴力触觉传感器阵列采集抓取过程中的物体信息,并结合机械手完成15种物体样本的数据集的组建,采用神经网络和注意力机制算法完成了识别分类的任务,解决了机器人触觉感知不足的问题并且提高触觉识别准确率,进一步将算法应用在检测日常生活用品的场景中。实验结果表明:三轴力触觉传感器能够满足生活物品检测分类的性能需求,灵敏度高重复误差小,依靠机械手抓取物体可以组建有效的触觉数据集,同其它触觉分类方法对比,本文根据多通道触觉感知信息和深度学习注意力机制的算法对于日常生活用品的分类识别具有更好的效果,最高准确率可达94.49%。

参考文献:

[1]HUANG S,WU H.Texture recognition based on perception data from a bionic tactile sensor[J].Sensors,2021,21(15):5224.

[2]LIU Mengwei,ZHANG Yujia,WANG Jiachuang,et al.A star-nose-like tactile-olfactory bionic sensing array for robust object recognition in non-visual environments[J].Nature Communica⁃tions,2022,13(79):1-10.

[3]黄守麟,梁艳,欧启标.机器人实践教学的探讨和优势[J].广西物理,2011,32(02):56-57.

[4]LI W,LIN C,RASHEED A,et al.A force and temperature sen⁃sor array based on 3-D field-coupled thin-film transistors for tactile intelligence[J].IEEE Transactions on Electron Devices,2020,67(7):2890-2895.

[5]KAPPASSOV Z,CORRALES J A,PERDEREAU V.Tactile sens⁃ing in dexterous robot hands–Review[J].Robotics and Autono⁃mous Systems,2015,74:195-220.

[6]LIU H,WU Y,SUN F,et al.Recent progress on tactile object recognition[J].International Journal of Advanced Robotic Sys⁃tems,2017,14(4):1-12.

[7]刘杰,历飞雨.基于弹性关节的二自由度机械臂建模与控制研究[J].机电工程,2022,39(6):846-853.

[8]丛明,缪跃,李泳耀,等.基于气压式触觉的欠驱动手抓取分类方法[J].华中科技大学学报(自然科学版),2021,49(9):41-46.

[9]黄珊,王博文,赵智忠,等.应用于机械手的磁致伸缩触觉传感器阵列与物体识别[J].电工技术学报,2021,36(7):1416-1424.

[10]GANDARIAS J M,GARCIA-CEREZO A J.CNN-based meth⁃ods for object recognition with high-resolution tactile sensors[J].IEEE Sensors Journal,2019,19(16):6872-6882.

[11]LI G,LIU S,WANG L,et al.Skin-inspired quadruple tactile sensors integrated on a robot hand enable object recognition[J].Science Robotics,2020,5(49):eabc8134.

[12]SUNDARAM S,KELLNHOFER P,LI Y,et al.Learning the sig⁃natures of the human grasp using a scalable tactile glove[J].Na⁃ture,2019,569(7758):698-702.

[13]HE K,ZHANG X,REN S,et al.Deep residual learning for im⁃age recognition[C]//Proceedings of IEEE Conference on Com⁃puter Vision and Pattern Recognition,2016,10(1109):770-778.

[14]MNIH V,HEESS N,GRAVES A,et al.Recurrent models of vi⁃sual attention[J].Advances in Neural Information Processing Systems,2014:2204-2212

[15]黄广伟,陈浩华,赵天婵,等.绳索驱动型拟人机械手研制[J].机电工程技术,2020(12):76-77.

[16]萧伟,孙富春,刘华平.机器人灵巧手的触觉分析与建模[J].机器人,2013,35(4):394-401.

[17]WOO S,PARK J,LEE J Y,et al.CBAM:convolutional block at⁃tention module[C]//Proceedings of the European Conference on Computer Vision(ECCV),2018:3-19.