基于HoloLens的增强现实手术导航系统精准融合显示方法论文

2023-09-26 15:05:57 来源: 作者:yeyuankang

摘要:传统手术导航系统中医生需要频繁切换视野,存在手眼协同问题,且无法实时获取患者病灶区域的全局视野。近年来Holo⁃Lens被逐步应用于新兴的增强现实手术导航系统中,但是现有的HoloLens全息空间标定方法多数依赖于用户的主观感受,显示过程中也没有考虑用户行为和周围环境变化带来的误差。对此,提出了一种基于HoloLens的增强现实手术导航系统精准融合显示方法。使用双目相机和视觉标记物完成对现实空间中目标物体的实时追踪。基于手眼标定原理提出了一种稳定的HoloLens离线标定方法,通过多次采集HoloLens

摘要:传统手术导航系统中医生需要频繁切换视野,存在手眼协同问题,且无法实时获取患者病灶区域的全局视野。近年来Holo⁃Lens被逐步应用于新兴的增强现实手术导航系统中,但是现有的HoloLens全息空间标定方法多数依赖于用户的主观感受,显示过程中也没有考虑用户行为和周围环境变化带来的误差。对此,提出了一种基于HoloLens的增强现实手术导航系统精准融合显示方法。使用双目相机和视觉标记物完成对现实空间中目标物体的实时追踪。基于手眼标定原理提出了一种稳定的HoloLens离线标定方法,通过多次采集HoloLens全息空间和现实空间中的坐标系转换关系,可以准确求解全息空间与现实空间之间的映射关系。建立融合显示过程的位姿矩阵传递关系后,用户可以快速地进行在线校正,实现虚拟影像与患者病灶区域的精准融合显示。Holo⁃Lens离线标定过程的平均耗时为4 min,用户在线校正的平均耗时为6.0 s。多个志愿者穿戴HoloLens设备进行融合显示精度验证实验,实验结果表明,校正前HoloLens融合显示的平均角度误差和平均距离误差分别为1.01°和3.95 mm,校正后融合显示的平均距离误差为1.46 mm。所提出的增强现实手术导航系统精准融合显示方法可以准确地标定HoloLens全息空间,经过用户在线校正后可以将虚拟影像与患者病灶区域融合显示,为医生提供准确完整的手术指导信息。实验结果表明该融合显示方法基本满足手术导航系统的精度和时间要求,具有临床应用的潜力。

关键词:增强现实;HoloLens;离线标定;在线校正;手术导航系统

Abstract:In the traditional surgical navigation system,doctors need to switch the field of view frequently,there is a problem of hand-eyecoordination,and the global field of view of the patient’s lesion area cannot be obtained in real time.In recent years,HoloLens has beengradually applied to the emerging augmented reality surgical navigation system,but the existing HoloLens holographic space calibration methods mostly rely on the user’s subjective experience,and the overlay result does not consider the errors caused by user behavior andchanges in the surrounding environment.In this regard,an accurate fusion overlay method is proposed based on HoloLens for augmented reality surgical navigation system.Use binocular cameras and visual markers to complete real-time tracking of target objects in real space.Based on the principle of hand-eye calibration,a stable HoloLens offline calibration method is proposed.By collecting the coordinate system conversion relationship between HoloLens holographic space and real space for many times,the mapping relationship between holographic space and real space can be accurately solved.After establishing the posture matrix transfer relationship of the fusion overlay,users can quickly perform online corrections to achieve accurate fusion overlay of the virtual image and the patient’s lesion area.The average time of HoloLens offline calibration is 4 min,and the average time of user online calibration is 6.0 s.Multiple volunteers wore HoloLens devices to perform fusion overlay accuracy verification experiments.The experimental results show that the average angle error and average distance error of HoloLens fusion overlay before correction are 1.01°and 3.95 mm,respectively,and the average distance error of fusion overlay after correction is 1.46 mm.The accurate fusion overlay method of the augmented reality surgical navigation system proposed in this paper can accurately calibrate the HoloLens holographic space.After online correction by the user,the virtual image can be fused with the patient’s lesion area,providing doctors with accurate and complete surgical guidance information.The experimental results show that the fusion overlay method basically meets the accuracy and time requirements of the surgical navigation system,and has the potential for clinical application.

Key words:augmented reality;HoloLens;offline calibration;online correction;surgical navigation system

0引言

随着计算机辅助外科手术技术的发展,增强现实(Augmented Reality,AR)技术作为一种新兴的导航手段,逐渐被应用到普通外科[1]、神经外科[2]、脊柱外科[3]等临床手术导航系统中。利用AR技术可以将经过预处理的患者术前医学图像与其病灶区域叠加显示,医生可以更直观立体地观察病灶区域的特征信息,避免传统手术导航系统中频繁切换视野所造成的手眼协同问题[4]。

利用AR技术进行手术导航,可以避免引入X射线带来的辐射危害,提高手术的准确性和安全性,减少医疗事故的发生。

在应用AR技术的手术导航系统中[5],按照影像的显示方式可以分为视频融合、投影融合和透视融合3种形式。Kockro等[6]使用集成了微型摄像机的手持式探头,将患者术前影像与拍摄的视频流叠加显示,实现了术中图像引导,但是导航效果受到摄像机分辨率和光敏度的限制。Sugimoto等[7]利用患者的肚脐、乳头、腹股沟等位置作为生理标记完成配准,将患者脏器的三维影像直接投影到皮肤表面,为医生提供胆囊、肠胃等脏器的解剖信息,避免意外的器官损伤。但是基于人体软组织的配准方式误差较大,且直接投影存在遮挡问题,不适合直接用于临床手术。廖洪恩[8]等提出了一种基于立体摄像(Integral Videography,IV)的增强现实导航系统,将3D空间图像叠加到手术区域,并通过半透镜观察叠加影像,可行性研究表明该系统可以提高手术器械的定位精度并缩短手术时间,但是显示设备体积较大,观察角度固定,灵活度有限。

目前,光学透视头戴式显示器(Optical See-Through Head-Mounted,OST-HMD)被广泛应用于增强现实导航系统中,其中HoloLens设备是微软公司推出的一款头戴式增强现实设备,利用即时定位与地图构建(Simultaneous Localization and Mapping,SLAM)技术进行空间实时定位,并提供语音、手势等多种交互功能,使用者可以拥有优秀的沉浸感体验。早期,HoloLens在医疗领域的使用仅限于培训和教育目的[1]。Pratt等[9]在腿部穿支皮瓣手术中使用HoloLens叠加显示骨骼、血管,有效定位穿孔血管,通过初步的辅助病例论证了Holo⁃Lens在手术导航中的可行性。法国阿维森纳教学医院Gregory等[10]、北京大学口腔医学院唐祖南等[11]依据患者的术前CT影像进行三维重建,利用HoloLens设备内置的语音、手势等交互功能将虚拟影像叠加显示在病灶区,分别完成了1例反向肩关节置换术和8例口腔颌面部肿瘤手术。但是,他们都没有提出可靠的对齐方法保证虚拟影像和患者病灶区域的融合显示,而是通过人工手动调整虚拟影像的位姿完成对齐,不仅耗费时间长,且无法保证显示精度,难以有效应用到临床手术中。

精准融合显示的关键在于HoloLens全息空间与现实空间之间的准确对齐,该过程称为HoloLens全息空间标定,已经有许多研究者进行了相应的研究。吴明龙等[12]使用HoloLens和RGB传感器分别识别静置于真实模型旁的二维码,使用改进的迭代最近点算法计算出HoloLens与RGB传感器之间的坐标系转换关系,该标定方法的平均距离误差小于3 mm,但是由于HoloLens设备的特性,不同用户视野中显示的虚拟影像位置有所不同,显示偏差较大。郭娜等[13]提出了一种基于单点主动对准方法的在线标定方法,通过手动移动真实模型的方式对齐虚拟影像,在虚实空间中多个采样点对齐方块模型完成全息空间的标定,显示的平均距离误差为6.83 mm,该方法完全依赖用户主观视觉感受,标定结果不稳定。王力等[14]利用机器人手眼标定原理,通过求解一个最小二乘问题得到了有效的标定结果,虚拟影像显示平均距离误差为2.5 mm左右。但是该方法每次启动HoloLens应用程序时都需要进行重新标定,增加了手术准备时间。上海交通大学孙启昌等人(2020)[15]通过NDI设备跟踪红外探针,用户使用探针针尖“触摸”全息空间中的虚拟十字模型快速地完成标定过程。该方法的平均均方根误差为1.30±0.39 mm,但是由于HoloLens设备在使用过程中周围环境的变化导致全息空间存在漂移,导致初始标定结果逐渐失效,显示误差逐渐变大。因此,HoloLens全息空间标定一致是一个具有挑战性的难题。

在现有研究工作中,AR技术在手术导航系统中的应用无法满足临床精度要求,而现有的HoloLens全息空间标定方法多数依赖于用户的主观感受,标定结果无法重复使用,且显示过程中没有考虑使用过程中用户行为和周围环境变化带来的误差。针对上述问题,本文中提出了一种基于HoloLens的增强现实手术导航系统精准融合显示方法,主要贡献包括:(1)提出了一种稳定准确的HoloLens离线标定方法,可以不依赖于用户主观感受,尽可能避免用户行为和环境变化带来的标定误差。(2)提供了一个将虚拟影像和患者病灶区融合显示参考流程,建立融合显示过程的位姿矩阵传递关系后,用户可以快速校正HoloLens设备,有效补偿了用户行为和环境变化带来的误差,最终融合显示具有较高的精度。

1方法

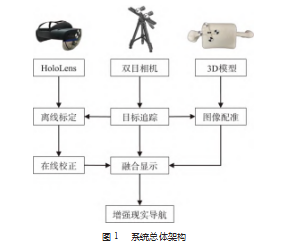

基于HoloLens的增强现实手术导航系统精准融合显示方法的总体架构如图1所示,包括现实空间目标追踪、全息空间离线标定、融合显示和在线校正4个部分。

1.1现实空间目标追踪

为了实现现实空间中的目标追踪,需要选择合适的特征点组成Marker,一般采用辨识度高、易于制作且抗干扰能力强的X角点作为特征点。利用文献[16]中提出的机器学习方法,使用双目相机在三维空间中实时检测和定位X角点,可以实现亚像素级定位,完成X角点的位置提取。但是,单个X角点无法表征现实空间的姿态信息,需要采用3个及以上不共线的X角点组成1个Mark⁃er,建立1个三维空间坐标系,进而表征现实空间中目标物体的位姿信息。

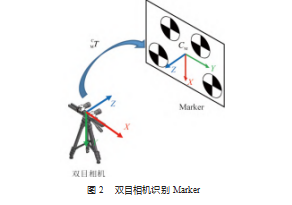

为了防止Marker处于不同位姿时,各X角点在双目相机图像中的相对位置发生改变而带来Marker坐标系描述不一致的问题,需要采用适当的方法保证所建立坐标系的稳定性,即Marker坐标系的定义应当具有缩放及旋转不变性。利用Marker中的X角点数量及相对位置始终固定的特点,初始定义其坐标系时将各角点在此坐标系下的坐标保存下来,注册为Marker模板。后续识别时,可以通过匹配已注册的Marker模板,进而按照初始的定义描述Marker坐标系。将Marker与目标物体固连,可以实时追踪目标物体的位置和姿态。双目相机识别4个X角点组成的Marker如图2所示,其中记双目相机坐标系为CC,Marker坐标系为CM,Marker坐标系相对于双目相机坐标系的转换关系记为T。

1.2全息空间离线标定

为了将HoloLens全息空间中的虚拟模型准确地显示在现实空间中的目标物体上,需要获取HoloLens全息空间中的坐标系与现实空间中的坐标系之间的转换关系,从而将全息空间与现实空间准确地联系起来,为在现实空间中准确显示全息三维影像奠定基础。

HoloLens设备启动全息应用程序时,全息空间中会建立一个虚拟世界坐标系(Stationary Frame of Refer⁃ence),记为CHG,在全息应用程序的整个运行生命周期中,该虚拟世界坐标系在现实空间中有相对固定的参考点;同时全息空间中还会建立一个表征设备自身位姿的局部坐标系(Attached frame of reference),记为CHL,在现实空间中的参考位置位于设备的主摄像头附近,并通过多个空间摄像头、陀螺仪等传感器感知设备的移动,进而实时更新该坐标系位姿。

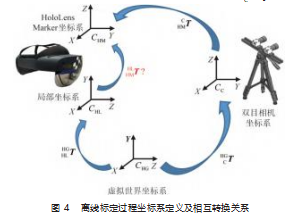

由于每次启动HoloLens应用程序时所建立的虚拟世界坐标系在现实空间中的参考位置不一致,如果标定该坐标系,则每次启动HoloLens应用程序时都需要进行重新标定,而HoloLens局部坐标系相对设备自身是固定不动的,因此本研究将由4个X角点组成的Marker固定在HoloLens设备上,其坐标系记为CHM,采用双目相机和Marker辅助标定HoloLens全息空间中局部坐标系与其Marker坐标系之间的转换关系。HoloLens坐标系定义及其转换关系如图3所示,其中,标定过程需要解算的Ho⁃loLens Marker坐标系相对于HoloLens局部坐标系的位姿记为T。

离线标定过程包含数据采集和数据处理两个步骤。

(1)数据采集。双目相机连接至个人计算机,Holo⁃Lens设备置于双目相机视野下,保持设备稳定不动,双目相机识别HoloLens Marker坐标系相对于双目相机坐标系的位姿,记为HT。同时计算机通过无线网络与Holo⁃Lens通信,利用HoloLens应用程序接口获取全息空间中局部坐标系相对于虚拟世界坐标系的位姿,记为T。改变HoloLens在双目相机视野下的位置和方向,重复以上步骤,可以获取多组位姿数据。离线标定过程中坐标系定义及相关转换关系如图4所示,其中,双目相机坐标系相对于全息空间虚拟世界坐标系的位姿记为G T。

(2)数据处理。对于任意一组位姿数据i∈(1,N),均满足式(1)。多组等式联立后,对于任意两组数据i,j∈(1,N)且i≠j,满足式(2)。利用该式将问题转化为一个经典的机器人手眼标定问题,利用文献[17]提出的一种非线性最优手眼标定算法可以求解得到T,完成虚实空间的位姿关系映射。

G T=TT M Ti(1)

TTT=T HTTj(2)

该标定过程可以在实际使用之前完成,因此称为一种离线标定方法。标定过程中不依赖于用户主观感受,可以尽可能避免不同用户和周围环境变化带来的标定误差。另外,离线标定的结果可以在多个场景中重复使用,每次启动HoloLens应用程序时不需要重新进行标定,缩短了手术准备时间。

1.3融合显示

本研究中需要将虚拟模型融合显示在患者病灶区域,为医生提供手术引导。患者病灶区域CT扫描数据坐标系记为CCT,运用图像分割方法将其中的组织器官分割出来进行三维重建,三维重建模型与原始CT数据具有相同的坐标系。融合显示的关键在于求解全息空间中虚拟模型相对虚拟世界坐标系的位姿信息。

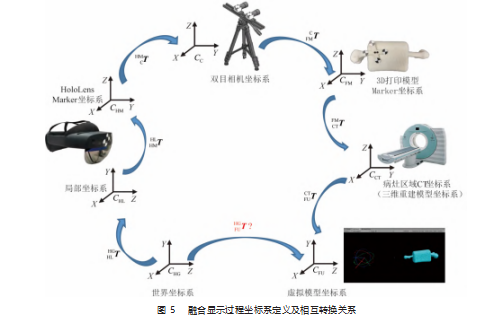

虚拟模型融合显示过程中坐标系定义及相互转换关系如图5所示。其中,将由三维重建数据3D打印的股骨模型作为手术对象,并在模型上固定Marker用于追踪其位姿,该Marker坐标系记为CFM,三维重建数据导入全息空间中后股骨虚拟模型坐标系记为CFU。需要注意的是,CHG、CHL和CFU为左手坐标系,其余为右手坐标系,计算过程中需要进行左右手转换统一坐标系定义。

建立虚拟模型显示过程的位姿矩阵传递关系后,通过式(3)完成虚拟模型相对于虚拟世界坐标系的位姿T的计算,将该位姿数据通过无线网络通信发送给HoloLens应用程序,即可在全息空间中融合显示虚拟股骨模型,与现实空间中的3D打印股骨模型重合。

T=T T HT T T T

其中,通过HoloLens系统接口可获取全息空间中局部坐标系相对于虚拟世界坐标系的位姿T,第1.2节中通过离线标定可以得到HoloLens Marker坐标系相对局部坐标系的位姿T、HT和FT可以利用双目相机实时识别HoloLens和股骨模型上的Marker得到。利用经典的点配准方法或者ICP点云配准算法[18]可以得到模型CT坐标系相对于股骨模型Marker坐标系的位姿T。三位重建模型导入全息空间时会自动将X轴反向以适应左手坐标系环境,因此T等于左右手坐标系转换矩阵T,T的值由式(4)给出。

1.4在线校正

离线标定过程中,由于无线网络信号延迟或Holo⁃Lens设备繁忙等因素会导致标定数据采集不同步,导致标定结果存在一定的误差。但是HoloLens的离线标定误差无法直接测量,因为只有佩戴HoloLens的用户可以观察到虚实叠加的影像,具有个人主观性。另一方面,融合显示过程中,由于用户行为及周围环境因素(如光线变化、动态物体等)的影响,HoloLens对于周围环境的感知可能会发生变化,导致全息空间中虚拟世界坐标系产生漂移。以上因素都会影响融合显示的效果,因此需要对HoloLens设备进行校正,提高融合显示的准确度。

HoloLens融合显示的误差主要来自标定误差、配准误差以及HoloLens设备漂移误差,当配准误差极小时,融合显示的误差可用于校正HoloLens设备。本研究中通过更新式(3)中的标定矩阵T体现HoloLens设备的校正结果。

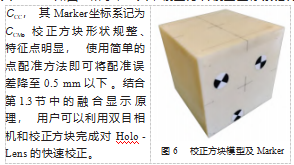

为了使配准误差降到最低,同时为了便于用户观察虚拟模型与真实模型重合程度,本研究中利用校正方块(150 mm×150 mm×150 mm)辅助校正。校正方块模型及其Marker如图6所示,其中校正方块模型坐标系记为

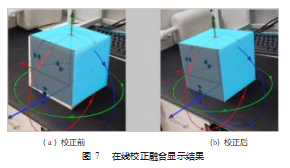

在线校正过程中,首先利用式(5),使用初始的离线标定结果T1计算校正方块虚拟模型相对于虚拟世界坐标系的位姿T1。由于离线标定结果误差和设备漂移误差,HoloLens全息空间中显示的虚拟模型和真实模型并没有完全重合,如图7(a)所示。

T1=T T1 HT T T T

式中:CT为校正方块Marker坐标系相对于双目相机坐标系的位姿;T为校正方块模型坐标系相对于Marker坐标系的位姿,使用点配准方法得到;T为校正方块虚拟模型相对真实模型坐标系的位姿,其值为左右手坐标系转换矩阵T。

用户根据视野中的影像,微调虚拟模型的位置和姿态,可以将虚拟模型调至与真实模型完全重合,如图7(b)所示,此时虚拟模型相对于虚拟世界坐标系的位姿为T2。根据融合显示原理,该位姿也可以根据式(6)计算。校正过程中HoloLens设备可以处于任意位置,为了便于计算,可以假设HoloLens设备微调前后的位置和姿态相同,因此式(6)中除了标定矩阵T2外,其他项与式(5)相同。

T2=T T2 HT T T T(6)

结合微调前后的虚拟模型位姿,根据式(7)可以计算得到校正后的标定矩阵T2。

T2=T TTT T1(7)

值得说明的是,HoloLens在使用过程中会根据用户的眼睛特征有着不同的显示修正,因此对于不同的用户,在线校正后的标定矩阵可能是有微小差异的,即校正后的标定矩阵中也包含了不同用户的视觉补偿。对于同一个用户,校正后的标定结果可以重复用于融合显示,具有较好的鲁棒性。

2实验和结果

实验中使用的硬件设备包括微软HoloLens、个人计算机和双目相机系统。其中微软HoloLens为2019年发布的第二代产品,个人计算机配置了Windows 10专业版系统、Intel(R)Core(TM)i7-9750H CPU和Nvidia GTX2060 GPU,双目相机由2个FLIR系统生产的单目相机(GS3-U3-41C6M-C)组成。使用C++语言、Open CV、PCL、QT开发了个人计算机应用程序,基于Uni⁃ty2019.3.15f和微软MRTK2.4.0开发HoloLens UWP应用程序。实验场景如图8所示。

2.1校正前融合显示精度实验结合第1.4节中在线校正的原理,将校正后的显示结果作为最佳显示结果,可以对HoloLens校正前的融合显示角度误差和距离误差进行评估,同时记录用户在线校正过程消耗的时间。HoloLens校正前融合显示精度实验步骤如下。

(1)将校正方块置于双目相机视野中,双目相机识别校正方块和HoloLens的Marker后,个人计算机计算出虚拟校正方块模型相对虚拟世界坐标系的位姿T=( ),其中R和t分别为旋转矩阵和平移矩阵。将该位姿信息通过无线通信发送给HoloLens,HoloLens在相应位置显示虚拟校正方块模型。

(2)保持现实空间中校正方块位置不动,用户调整虚拟模型位置和姿态,使其与真实模型完全重合,再次记录虚拟校正方块模型相对虚拟世界坐标系的位姿

T′=(′′)。

(3)改变现实空间中校正方块的位置和姿态,重复以上步骤,直至采集n=10组数据。

HoloLens校正前融合显示误差可以通过计算微调虚拟模型前后,虚拟模型相对虚拟世界坐标系的位姿差异变化得出。平均角度误差和平均距离误差可分别由式(8)~(9)计算‖matrix2axisangle(•)‖为与旋转矩阵等价的旋转向量的模,即两个位姿之间的等效转角。

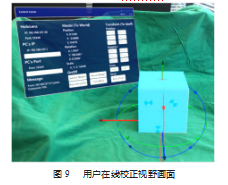

本文选取3位志愿者参照上述步骤进行了精度实验,用户在线校正时视野中的画面如图9所示,通过点击按钮微调虚拟校正方块模型位姿,将虚拟校正方块模型与平台上的校正方块重合。实验结果如表1、图10所示,校正过程平均耗时为6.0 s,HoloLens校正前融合显示的角度误差范围为0.68°~1.49°,平均角度误差为1.01°,距离误差范围为2.87~5.66 mm,平均距离误差为3.95 mm。

2.2校正后融合显示精度实验

经过用户快速在线校正后,理论上融合显示的误差极小,但是在实际应用中,HoloLens显示的虚拟影像形状没有标定方块规整,另外HoloLens虚拟世界坐标系也会随着时间慢慢漂移,因此融合显示依然存在一定的误差。

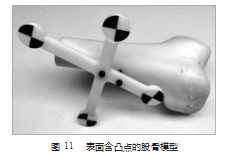

为了评估HoloLens在线校正后融合显示的精度,本文中使用表面含凸点的股骨模型作为手术对象,并在模型上固定Marker以追踪其位姿,如图11所示。选取其中15个凸点作为特征点,通过计算视野中虚拟模型凸点与真实模型对应凸点之间的距离,对校正后虚拟模型融合显示的准确性进行了评估。校正后融合显示精度实验步骤如下。

(1)将股骨模型固定于双目相机视野中,按照1.3小节中提出的显示原理,双目相机识别股骨模型和Holo⁃Lens的Marker后,利用在线校正后的标定结果,计算机可以计算出虚拟股骨模型相对虚拟世界坐标系的位姿,将该位姿信息通过无线通信发送给HoloLens,HoloLens视野中虚拟股骨模型将融合显示到真实股骨模型上。

(2)用户根据HoloLens视野中显示的虚拟模型,使用视觉探针依次点击视野中虚拟模型凸点的中心位置。每次选取凸点时,双目相机连续采集探针针尖位置,通过式(10)计算可以得到视觉探针针尖相对于股骨模型CT坐标系的位置q′。

式中:T为股骨模型Marker坐标系相对于股骨模型CT坐标系的位置;FT和PT分别为股骨模型Marker坐标系和视觉探针Marker坐标系相对于双目相机坐标系的位姿;p为视觉探针针尖相对于视觉探针Marker坐标系的位置。

已知股骨模型上的凸点相对股骨模型坐标系的位置q,通过式(11)可以计算对应点之间的平均距离,即校正后融合显示的平均距离误差。

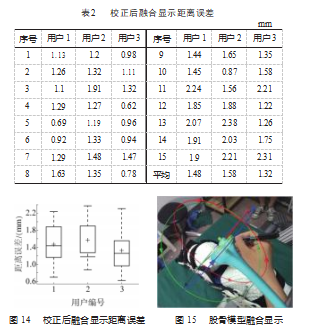

本文选取3位志愿者参照上述步骤进行了精度实验,用户使用探针选点如图12所示,用户视野中融合显示效果如图13所示。实验结果如表2和图14所示。经过在线校正后,虚拟模型融合显示的距离误差范围在0.62~2.38 mm之间,平均距离误差为1.46 mm,实验结果表明在线校正过程有效降低了融合显示误差,本文提出的融合显示方法具有较高的融合显示精度,可以应用于手术导航系统中。

2.3全膝关节置换手术增强现实手术导航实验

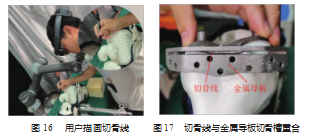

本文以全膝关节置换手术为背景,应用基于Holo⁃Lens的增强现实手术导航系统精准融合显示方法提供手术指导。用户利用校正方块完成在线校正后,HoloLens在手术台上股骨模型的位置融合显示虚拟股骨模型及切骨导板模型,用户视野中融合显示效果如图15所示。

用户根据视野中的虚拟导板位置,使用记号笔在股骨模型上描画出切骨线,如图16所示。用户描画完成后,在股骨模型上放置金属导板,可以观察到用户所画的切骨线全部位于金属导板切骨槽内,如图17所示。由于股骨模型表面凹凸不平,描画时存在微小误差,切骨线与金属导板切骨槽中心线偏差在0.8 mm以内,结果表明虚拟模型与真实模型融合显示具有很高的重合度,可以在全膝关节置换手术中提供手术指导。

实际应用中,可以利用HoloLens显示切骨平面,即可指导完成切骨,从而可以避免设计和制作复杂的金属导板,节省材料费用。本文提出的融合显示方法可以根据手术实际需要融合显示可提供手术指导的虚拟模型,具有很强的可扩展性,因此可以有效应用于骨科、整形、牙科等外科手术中。

3误差分析与讨论

本文提出的HoloLens离线标定方法流程简单,没有用户的主观因素介入,其原理也可以扩展用于其他光学透视头戴式显示器设备的标定。离线标定过程平均耗时4 min,校正前融合显示的平均角度误差和平均距离误差分别为1.01°、3.95 mm,误差较大,无法直接应用于手术导航系统中。经过用户快速在线校正后,融合显示的平均距离误差为1.46 mm,符合增强现实手术导航系统的精度要求。

融合显示出现误差的主要原因包括离线标定误差和HoloLens设备漂移误差。离线标定过程中为了标定数据采集尽可能同步,采集数据时应尽可能保证HoloLens设备静止。融合显示过程中HoloLens全息空间虚拟世界坐标系存在漂移,这主要与周围环境以及用户行为有关。为了尽可能减少环境对HoloLens的影响,开始显示前,应使HoloLens充分扫描周围环境,使用过程中,不能近距离遮挡HoloLens相机和传感器,移动设备时应轻缓,视野中尽可能不要出现动态物体。后续工作中,可以深入研究不同因素对HoloLens离线标定结果的影响,提高方法的鲁棒性。

对于离线标定误差、HoloLens设备漂移误差、个人视觉误差,用户的在线校正可以达到一定的补偿效果。在线校正过程中,用户需要手动将虚拟模型与真实模型尽可能完全对齐,但是实际上用户很难在短时间内完全对齐虚实模型。校正过程中应尽可能从各个角度观察模型,但由此会增加在线校正的耗时,需要在显示误差和校正耗时之间进行一定的权衡。

实际上,整个融合显示过程中还存在一些影响显示效果的因素,比如配准误差、双目相机识别Marker的误差等。后续工作中,可以采用滤波器降低双目相机系统的图像噪声,提高追踪精度。另外,在实际的手术过程中,由于手术视野需要尽可能小,如何在手术部位固定Marker以及完成配准也是亟待解决的问题之一。

4结束语

本文提出了一种基于HoloLens的增强现实手术导航系统精准融合显示方法。结合双目相机和Marker实现了对目标物体的实时位姿追踪,基于手眼标定原理提出了一种稳定的HoloLens离线标定方法,可以不依赖于用户主观感受,尽可能避免用户行为和周围环境变化带来的标定误差,准确建立了全息空间与现实空间的映射关系。建立融合显示过程的位姿矩阵传递关系后,可以实现虚拟影像与患者病灶区域的精准融合显示。精度实验结果表明,在线校正前融合显示的平均角度误差和平均距离误差分别为1.01°和3.95 mm。用户快速在线校正后,有效补偿了离线校正误差、配准误差和HoloLens设备漂移误差,校正后融合显示的平均距离误差为1.46 mm。所提方法基本满足手术导航系统的精度和实时性要求,可以为医生提供准确的手术指导信息,具有临床应用的潜力。

参考文献:

[1]INCEKARA F,SMITS M,DIRVEN C,et al.Clinical feasibility of a wearable mixed-reality device in neurosurgery[J].WorldNeurosurgery,2018,118:e422-e427.

[2]INCEKARA F,SMITS M,DIRVEN C,et al.Clinical feasibility of a wearable mixed-reality device in neurosurgery[J].WorldNeurosurgery,2018,118:e422-e427.

[3]LIEBMANN F,RONER S,VON ATZIGEN M,et al.Pedicle screw navigation using surface digitization on the Microsoft Holo⁃Lens[J].International Journal of Computer Assisted Radiology and Surgery,2019,14(7):1127-1165.

[4]MEULSTEE J W,NIJSINK J,SCHREURS R,et al.Toward holo⁃graphic-guided surgery[J].Surgical Innovation,2018,26(1):86-94.

[5]NTOURAKIS D,MEMEO R,SOLER L,et al.Augmented reality guidance for the resection of missing colorectal liver metastases:an initial experience[J].World Journal of Surgery,2016,40(2):419-426.

[6]KOCKRO R A,TSAI Y T,NG I,et al,Dex-ray:augmented reali⁃ty neurosurgical navigation with a handheld video probe[J].Neu⁃rosurgery,2009,65(4):795-808.

[7]SUGIMOTO M,YASUDA K,KODA K,et al.Image overlay navi⁃gation by markerless surface registration in gastrointestinal,hep⁃atobiliary and pancreatic surgery[J].Journal of Hepato-Biliary-Pancreatic Sciences,2010,17(5):629-636.

[8]LIAO H E,INOMATA T,SAKUMA I,et al.3-D Augmented re⁃ality for MRI-Guided surgery using integral videography autoste⁃reoscopic image overlay[J].IEEE Transactions on Biomedical En⁃gineering,2010,57(6):1476-1486.

[9]PRATT P,IVES M,LAWTON G,et al.Through the HoloLens™looking glass:augmented reality for extremity reconstruction sur⁃gery using 3D vascular models with perforating vessels[J].Euro⁃pean Radiology Experimental,2018,2(1):1-7.

[10]GREGORY T M,GREGORY J,SLEDGE J,et al.Surgery guid⁃ed by mixed reality:presentation of a proof of concept[J].Acta Orthopaedica,2018,89(5):480-483.

[11]唐祖南,苏惠裕,胡耒豪,等.混合现实技术在口腔颌面部肿瘤手术中的应用[J].北京大学学报(医学版),2020,52(6):1124-1129.

[12]WU M L,CHIEN J C,WU C T,et al.An augmented reality sys⁃tem using improved-iterative closest point algorithm for on-pa⁃tient medical image visualization[J].Sensors,2018,18(8):2505.

[13]GUO N,WANG T M,YANG B,et al.An online calibration method for Microsoft HoloLens[J].IEEE Access,2019,7:101795-101803.

[14]WANG L,SUN Z W,ZHANG X H,et al.A HoloLens based augmented reality navigation system for minimally invasive totalknee arthroplasty[C]//Proceedings of the Intelligent Robotics and Applications,Shenyang:Springer,Cham,2019:519-530.

[15]SUN Q C,MAI Y F,YANG R,et al.Fast and accurate online calibration of optical see-through head-mounted display for AR-based surgical navigation using Microsoft HoloLens[J].In⁃ternational Journal of Computer Assisted Radiology and Sur⁃gery,2020,15(11):1907-1919.

[16]WANG J C,JI X Q,ZHANG X H,et al.Real-time robust indi⁃vidual X point localization for stereoscopic tracking[J].Pattern Recognition Letters,2018,112:138-144.

[17]王君臣,王田苗,杨艳,等.非线性最优机器人手眼标定[J].西安交通大学学报,2011,45(9):15-20.

[18]BESL P J,MCKAY N D.Method for registration of 3-D shapes[C]//Proceedings of the Sensor fusion IV:control paradigms and data structures,Boston:SPIE,1992:586-606.