基于 Docker 分层镜像的 AI 实训室轻量化部署系统设计论文

2026-02-03 17:28:38 来源: 作者:xuling

摘要:本文分析了GPU资源隔离、数据集版本管理与模型迭代依赖三类部署需求,研究了面向多阶段构建的Docker■le镜像分层优化与基于Git的增量镜像更新机制,提出了由基础设施层、数据管理层、服务编排层与交互层组成的四级架构,旨在构建具备分层复用能力、支持环境溯源与调度自治的AI实训室轻量化部署系统。

摘要:AI实训室部署需满足高并发异构计算资源调度与环境隔离的容器化运行要求。本文分析了GPU资源隔离、数据集版本管理与模型迭代依赖三类部署需求,研究了面向多阶段构建的Docker■le镜像分层优化与基于Git的增量镜像更新机制,提出了由基础设施层、数据管理层、服务编排层与交互层组成的四级架构,旨在构建具备分层复用能力、支持环境溯源与调度自治的AI实训室轻量化部署系统。

关键词:Docker分层镜像;AI实训室;轻量化部署

0引言

AI实训室部署场景中,存在GPU资源调度冲突、数据集快照不可追溯与模型迭代环境依赖耦合等复杂问题[1]。本文提出了基于Docker分层镜像的轻量化部署系统设计思路,构建包含基础设施层、数据管理层、服务编排层与交互层的多维体系结构。利用多阶段Docker■le编排与Git驱动的增量式镜像生成机制,以期达成模块复用性增强与部署流程自动化目标。

1 AI实训室轻量化部署需求分析

1.1 GPU资源隔离需求

在多用户并发训练环境中,AI实训室需面向GPU计算资源实施容器级别的Namespace划分与CGroup资源配额控制,以规避CUDA上下文冲突与显存越界异常[2]。传统裸机部署模式难以实现基于device-plugin插件的NVIDIA GPU Driver透明挂载与GPU Core Binding的粒度调度。需在不重启物理节点的条件下完成GPU Tensor Core级别的动态分配与强隔离部署需求映射。

1.2数据集版本管理需求

AI实训场景中多任务数据源高度异构,数据集在预处理策略、样本扩增规则及特征工程流程中存在高频变更需求,传统静态挂载方式无法支撑基于哈希索引的快照追踪与差异化存储。需引入基于内容寻址的分层数据版本控制机制,结合Layer Digest校验与元数据追踪模型,实现对多模态数据集在容器镜像中的结构化映射。

1.3模型迭代依赖需求

模型迭代过程依赖深度学习框架、算子库版本、推理引擎接口及底层驱动兼容性的稳定耦合关系,AI实训环境需支持多版本依赖的并行挂载与环境切换[3]。传统虚拟机架构在处理PIP包冲突、CUDA与cuDNN绑定不一致。系统需实现对模型依赖栈的最小可重构单元管理,达成在迭代训练中的依赖复用与环境非侵入式隔离部署。

2 AI实训室轻量化部署系统设计

2.1系统架构设计

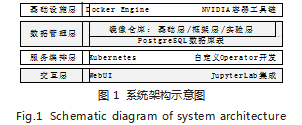

为满足以上需求,本文设计的系统架构分为基础设施层、数据管理层、服务编排层与交互层,如图1所示。并依据容器运行依赖解耦、资源调度自治与交互逻辑隔离原则构建,整体构型遵循职责边界清晰与资源域互不侵扰设计范式[4]。

2.1.1基础设施层

基础设施层设计依托Docker引擎构建容器生命周期管理机制,结合NVIDIA容器工具链实现驱动透明挂载与计算资源透传绑定,以构建支持多容器并发调度与异构GPU资源映射的运行环境。本文由NVIDIA容器运行时(用于与Docker集成实现GPU资源透传)集成CUDA运行时、cuDNN加速库与Tensor Core指令集,依赖libcontainer实现namespace隔离与cgroup限额调度。

2.1.2数据管理层

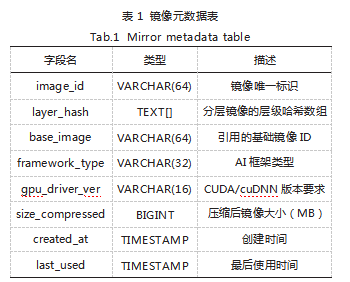

数据管理层设计采用分层镜像仓库结构与关系型数据库联合建模方式,镜像仓库划分为基础层、框架层与实验层,分别承载操作系统基础环境、深度学习运行框架及个性化实验任务的分离式构建语义。PostgreSQL数据库中的定义镜像元数据表如表1所示。

2.1.3服务编排层

为实现容器实例的动态调度、资源状态感知与生命周期控制,本文设计的服务编排层基于Kubernetes容器编排系统构建了分布式容器管理框架,结合自定义Operator运维控制器开发实现镜像版本追踪、GPU亲和性绑定与训练任务容器编排。通过CRD定义镜像构建状态与资源调度策略,配合Pod模板控制器进行副本集生成与重调度逻辑注入,利用标签选择器、污点与容忍度机制实现节点拓扑感知。事件驱动架构下,Operator监听镜像仓库及任务提交事件,自动更新部署控制器配置,保障训练任务在镜像变更后的调度一致性与节点绑定精度。

2.1.4交互层

为实现多用户环境下的容器会话隔离与训练任务可视化操作,本文交互层设计选择了WebUI与JupyterLab集成的前后端解耦架构。WebUI由Token验证机制实现用户身份映射与资源访问控制,结合Nginx反向代理完成前端路由转发与Session绑定;JupyterLab则由容器化部署嵌入Notebook运行环境,挂载特定分层镜像并接入GPU调度通道,实现环境与任务的动态绑定。

2.2核心功能实现

2.2.1多阶段Docker■le优化设计

多阶段Docker■le构建流程采用Alpine最小化基础镜像并结合编译层与运行层物理隔离策略,将依赖构建与执行环境解耦。编译阶段基于gcc、cmake与pip构建环境拉取依赖、编译源码,构建产物由COPY--from指令传递至最终运行阶段,仅保留可执行文件与必要动态链接库,避免构建工具链与中间包冗余堆积。各阶段按操作系统依赖、深度学习框架、实验环境逻辑拆分,配合多层缓存机制降低构建路径重编译概率,提升缓存命中率并控制指令触发范围。

2.2.2 Git增量式镜像更新机制设计

为实现分层镜像在版本演化过程中的差异追踪与增量构建控制,本文引入基于Git的增量式镜像更新机制,运用Hook脚本绑定Git提交事件与Docker构建触发流程,利用commit哈希与路径差异信息提取Docker■le及上下文变更区域,再结合缓存层校验策略判定是否重构指定镜像层。每次提交自动生成镜像元数据索引,包含base_ image映射、layer_hash变更组、framework_type绑定及gpu_driver_ver依赖配置,写入PostgreSQL镜像元表形成版本快照,均支撑镜像构建路径的回溯解析与依赖回滚[5]。构建流水线中集成Git分支与Tag映射策略,按feature/experiment等命名规范自动派生临时镜像标签,再运用di■比对方式判定是否命中已构建缓存层,避免镜像冗余堆积。

3测试与分析

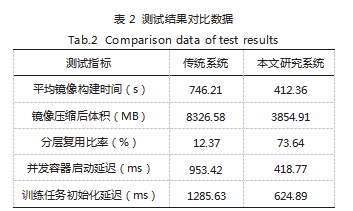

测试平台部署于某高校AI实训室,硬件配置为12台Intel Xeon Silver 4310(2.10GHz)、128GB内存、NVIDIA RTX A6000(48GB显存),系统环境为Ubuntu 22.04,Docker 24.0.5,Kubernetes 1.28.3。对比系统采用VMware vSphere虚拟化平台,基于传统静态镜像部署方式,无分层缓存机制。测试任务选取ResNet50、YOLOv7、BERT-base、GPT-2、UNet五类模型构建训练流程。

第一,镜像构建阶段以多阶段Docker■le分别生成基础层、框架层与实验层,统计构建耗时;第二,镜像压缩与上传阶段记录生成体积并上传至镜像仓库;第三,镜像拉取与容器创建阶段测定初次与复用拉取差异性,标注分层缓存命中率;第四,GPU训练任务提交后测量调度至GPU节点的响应延迟,并统计Pod容器初始化所需时间;第五,任务执行完成后容器资源回收并监测系统调度反应。所有实验在统一调度窗口内完成。

测试结果对比数据如表2所示,结果显示,本文系统在构建时长、镜像体积、资源调度响应等方面均优于传统系统,体现出分层缓存与增量机制在镜像复用、结构优化和并发调度中的实效性,具备较高的教学部署适配性与系统轻量化能力。

4结语

本文构建了面向AI教学场景的Docker分层镜像部署系统,系统架构清晰、功能模块解耦,形成了结构可复用、版本可追踪与资源可编排的容器运行体系。在基础设施层实现了GPU算力虚拟映射,在数据管理层构建了分层镜像元数据结构,在服务编排层完成了镜像调度控制逻辑设计,在交互层实现了Jupyter容器化入口融合机制。本文为面向高校AI实训平台的自动化部署提供了可复制、可拓展的标准模型。

参考文献

[1]陈笑红.实训室开放与共享背景下AI技术在高校资产管理中的应用研究[J].中国管理信息化,2024,27(24):104-106.

[2]张红坚,姜斌远.基于AI技术下供应链实训课程沉浸式教学探索[J].中国设备工程,2024(14):254-256.

[3]王艳.基于Docker容器技术的镜像制作原理分析与实践[J].信息与电脑(理论版),2024,36(6):1-4.

[4]周玮,辛政华,杨小莹,等.基于Docker的人工智能实验教学平台研究与设计[J].鄂州大学学报,2022,29(3):101-103.

[5]洪梓榕,任聪.AI实训云平台在机器人实践课程中的应用研究[J].信息与电脑(理论版),2022,34(8):239-241.