基于 OPC 协议的工业服务器多客户端数据传输线程优化与并发性能研究论文

2026-02-03 15:16:01 来源: 作者:xuling

摘要:OPC(OLE for Process Control)协议作为工业数据传输的核心标准,承担着多客户端与服务器间实时数据交互的关键任务。

摘要:OPC(OLE for Process Control)协议作为工业数据传输的核心标准,承担着多客户端与服务器间实时数据交互的关键任务。针对传统OPC服务器在多客户端并发场景下存在的问题,本文提出了一种融合动态线程池调度、LRU数据缓存与读写锁优化的综合解决方案。实验结果表明,优化方案在500台客户端并发时,数据传输平均延迟降至65ms,较传统方案降低69.0%,有效解决了高并发场景下的性能瓶颈,为工业服务器多客户端数据传输的高效稳定运行提供了技术支撑。

关键词:OPC协议;工业服务器;多客户端;数据传输线程优化;并发性能

0引言

随着智能制造技术的普及,工业控制系统中分布式客户端的数量呈指数级增长,多客户端与服务器间的实时数据交互需求日益强烈。OPC协议凭借其跨平台兼容性、数据一致性与标准化特性被广泛应用于电力监控、智能制造、石油化工等领域。本文基于OPC服务器多客户端数据传输的线程调度机制与并发性能优化,构建动态线程管理模型,优化数据传输策略,结合实验验证优化方案的有效性,为工业级高并发数据传输提供了参考。

1相关理论与技术

1.1 OPC协议架构与数据传输原理

OPC协议是基于微软COM/DCOM技术或TCP/IP协议的工业数据交换标准,其核心功能是实现数据源与客户端的解耦通信。目前主流应用的OPC UA(Unified Architecture)协议采用面向服务的架构,支持二进制编码与XML编码,传输层基于TCP/UDP协议,具备更强的安全性与跨平台能力。

OPC服务器与客户端的数据传输流程分为三个阶段。

(1)客户端连接建立阶段。客户端通过OPC协议栈向服务器发送连接请求,服务器验证身份后创建会话。(2)数据订阅与请求阶段。客户端通过Read/Write服务或订阅—发布机制获取目标数据,服务器接收请求后访问数据源,通过Modbus协议读取PLC寄存器。(3)数据响应阶段。服务器将处理后的数据封装为OPC标准格式,通过网络传输至客户端。在多客户端场景下,服务器需同时处理大量并发请求,线程调度效率直接决定传输性能。

1.2多线程并发与线程调度机制

多线程并发是提升服务器并发处理能力的技术,其本质是通过CPU时间片轮转实现多个线程的并行执行。传统OPC服务器的线程管理模式主要分为两类。

(1)固定线程池模式。预先创建固定数量的工作线程,客户端请求进入任务队列,线程从队列中获取任务执行。该模式在客户端数量较少时开销较低,但当请求数超过线程数时,任务排队导致延迟剧增。

(2)无界线程池模式。每接收一个客户端请求,创建一个新线程,任务完成后销毁线程。该模式在高并发下会导致线程数量暴增,上下文切换开销占比超过40%,CPU与内存资源耗尽。

线程上下文切换的时间开销可表示为Tctx=Tsave+Tload,其中Tsave为保存当前线程寄存器、程序计数器等状态的时间(约1~5μs),Tload为加载新线程状态的时间(约2~8μs)。

1.3工业场景多客户端并发特性

工业场景中多客户端并发访问具有以下特性。(1)客户端类型异构。包含监控终端、控制设备、数据采集器等,请求频率差异大(1~100Hz)。(2)数据传输周期性。80%的客户端为周期性请求,每100ms读取一次温度数据,20%为突发性请求。(3)数据相关性强。多个客户端可能请求同一数据源,重复读取占比达65%[1]。

某汽车零部件生产线的OPC服务器运行数据显示,在生产高峰期,客户端并发数从120台增至380台,传统服务器的传输延迟从45ms升至198ms,吞吐量从2800条/秒降至950条/秒,导致监控终端数据刷新滞后,影响生产调度决策。

2传统OPC服务器多客户端传输的性能难点分析

2.1线程调度机制不合理

传统OPC服务器采用固定线程池调度时,线程数Npool通常设置为CPU核心数的2~4倍,未考虑工业场景中IO等待时间占比高的特点。假设服务器CPU核心数为Ncpu,单个线程的CPU计算时间为Tcpu,IO等待时间(包括读取PLC数据、网络传输)为Tio,则线程池的最优线程数需满足Nopt=Ncpu×(1+Tio/Tcpu)。工业场景中Tio通常为Tcpu的5~10倍,若Ncpu=14,则Nopt应为84~154,但传统方案常设置为28,导致线程利用率不足,任务排队延迟增加。

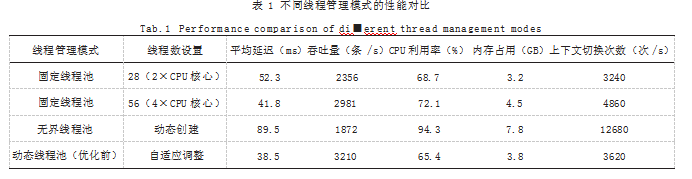

不同线程管理模式在14核服务器上的性能对比如表1所示,并发客户端数100台,单条数据1024字节,网络RTT=1ms。

由表1可知,无界线程池在高并发下因线程数量失控,100客户端时线程数达180个,上下文切换次数是固定线程池的3~4倍,CPU利用率接近饱和,性能最差。固定线程池线程数设置为4×CPU核心时,性能优于2×CPU核心,但仍存在线程不足导致的排队延迟。

2.2数据传输模式效率低

传统OPC服务器采用请求—响应的同步传输模式,每个客户端请求对应一次独立的数据源访问与网络传输。由于工业场景中65%的请求为重复数据读取,重复访问数据源导致IO开销占比达55%。同时,单条数据传输的网络开销占比超过30%,带宽利用率不足40%。以某化工园区OPC服务器为例,当并发客户端数为300台时,传统方案的数据源访问次数达280次/秒,其中重复访问次数182次/秒,重复访问率65%;单条数据传输的有效数据占比仅为60%,带宽浪费严重。

3基于OPC协议的多客户端传输线程优化方案设计

3.1动态线程池调度策略设计

3.1.1最优线程数计算模型

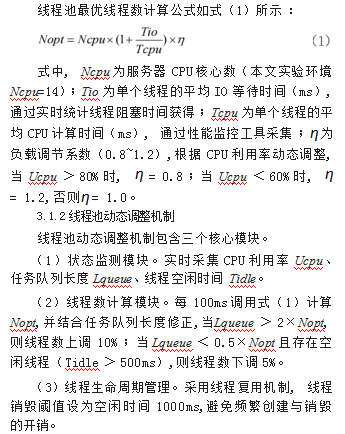

针对传统线程池线程数固定的问题,提出基于CPU利用率与任务队列长度的动态线程池调度策略,核心是通过数学模型实时计算最优线程数。

3.2数据缓存与批量传输优化

3.2.1 LRU缓存机制设计

为了减少重复数据源访问,设计基于LRU(Least Recently Used)的数据缓存机制,缓存容量设为Ccache=1000条,覆盖工业场景95%的热点数据。缓存结构采用哈希表和双向链表实现,哈希表用于快速查找,双向链表用于维护数据访问顺序。新访问数据插入表头,缓存满时淘汰表尾数据[2]。

缓存更新策略如下。(1)周期性更新。每隔500ms同步数据源数据至缓存。(2)触发式更新。当数据源数据变化量超过阈值时,主动更新缓存。

3.2.2批量传输阈值计算

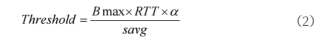

为降低网络开销,设计基于带宽与RTT的批量传输机制,当缓存中待发送数据量达到阈值或超时时间(50ms)到,触发批量传输。

批量传输阈值公式如式(2)所示:

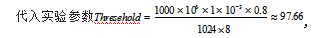

式中,Bmax为网络带宽上限(本文实验环境Bmax=1000Mbps);RTT为网络往返时间(ms),实时测量获得;ɑ为带宽利用率系数(0.7~0.9),避免带宽占满导致的延迟;savg为单条数据平均大小(字节),本文savg=1024Byte。

取整为98条,即当缓存中待发送数据达98条时触发批量传输。

取整为98条,即当缓存中待发送数据达98条时触发批量传输。

3.3读写锁优化与临界资源管理

针对临界资源竞争问题,采用读写锁替代传统互斥锁,核心机制如下。

(1)读锁共享。多个读线程可同时获取读锁,并发执行读操作。

(2)写锁独占。写线程获取写锁时,所有读线程与写线程需等待,确保数据一致性。

为进一步降低锁竞争,采用分段锁机制,将数据缓冲区按数据源类型分为10个分段,每个分段独立配置读写锁,读请求仅需获取对应分段的读锁,写请求仅需获取对应分段的写锁,锁竞争范围缩小至1/10。

4实验验证与性能分析

4.1实验环境搭建

(1)硬件环境。服务器:Intel Xeon E5-2680v4 CPU(14核28线程),32GB DDR4内存,1TB SSD硬盘,千兆以太网网卡。

客户端:500台工业计算机(Intel Core i5-8400 CPU,8GB内存),通过千兆交换机与服务器组网。

数据源:10台S7-1200 PLC,通过Pro■net协议与服务器连接,输出数据包括温度、压力、流量等(共100个数据点)。

(2)软件环境。操作系统:服务器CentOS 7.9,客户端Windows 10 Professional。

OPC服务器框架:Open62541(v1.3.6),支持OPC UA协议。

客户端开发:Python 3.8+opcua-client库。

性能测试工具:Wireshark(网络抓包)、htop(CPU监控)、vmstat(内存监控)、自定义性能统计工具(记录延迟、吞吐量)。

4.2实验设计

实验采用对比测试方案,设置两组实验。

对照组(传统方案):固定线程池(线程数56和同步传输以及互斥锁)。

实验组(优化方案):动态线程池和LRU缓存、批量传输、读写锁、分段锁。

实验变量为并发客户端数(50台、100台、200台、300台、400台、500台),每个变量下连续运行30分钟,采集平均传输延迟、吞吐量、CPU利用率、内存占用、缓存命中率指标。

4.3实验结果与分析

4.3.1平均传输延迟对比

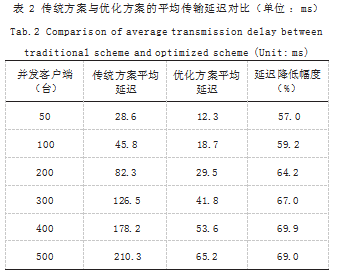

传统方案与优化方案在不同并发客户端数下的平均传输延迟对比如表2所示。

由表2可知,随着并发客户端数增加,两组方案的平均延迟均呈上升趋势,但优化方案的延迟增长速率显著低于传统方案。当并发客户端为500台时,优化方案的平均延迟仅为65.2ms,较传统方案降低69.0%,主要原因是动态线程池减少了任务排队延迟,LRU缓存降低了IO等待时间,批量传输减少了网络开销,读写锁降低了锁等待时间。

4.3.2吞吐量对比

吞吐量随并发客户端数的变化趋势如下:传统方案在50台客户端时吞吐量为2860条/秒,随着客户端数增加,吞吐量增长缓慢,500台时降至1200条/秒;优化方案在50台客户端时吞吐量为3240条/秒,随着客户端数增加,吞吐量稳步增长,500台时达到4800条/秒,较传统方案提升300%。

优化方案吞吐量提升的原因:(1)批量传输使网络带宽利用率从40%提升至85%;(2)LRU缓存命中率稳定在85%以上,减少了65%的数据源访问开销;(3)动态线程池使线程利用率从65%提升至90%,任务处理效率提高[3]。

4.3.3资源占用对比

(1)利用率方面。传统方案在300台客户端时CPU利用率达89%,500台时达98%,接近饱和;优化方案在500台客户端时CPU利用率仅为74%,较传统方案降低24.5%。主要原因是动态线程池减少了上下文切换开销,从12680次/秒降至3860次/秒,分段锁降低了锁竞争导致的CPU空转。

(2)内存占用方面。传统方案在500台客户端时内存占用达8.0GB,优化方案仅为4.5GB,降低了43.7%。原因是动态线程池避免了无界线程创建导致的内存浪费,LRU缓存的固定容量设计防止了缓存膨胀。

5结语

综上所述,本文针对传统OPC服务器在多客户端并发场景下的性能瓶颈,提出了融合动态线程池调度、LRU数据缓存、批量传输与读写锁优化的综合解决方案。未来需要研究5G与工业以太网混合组网场景下的批量传输阈值动态调整策略,以适应网络带宽与RTT的动态变化。

参考文献

[1]张曦阳,林旭升,周瑞,等.数控系统数字孪生体系结构及应用研究[J].系统仿真学报,2025,37(1):183-198.

[2]温雪媛,张路,蒋玉明,等.基于OPC UA协议的PLC数据采集系统改造方案[J].自动化应用,2025,66(1):209-212.

[3]张星炜,王海楠,孟悦,等.基于数字孪生的输变电线路三维数字化仿真系统[J].自动化技术与应用,2025,44(2):94-99.