基于深度学习的云计算人工智能数据筛选算法研究论文

2026-01-05 10:30:31 来源: 作者:xuling

摘要:随着新一代信息技术的飞速发展,数字化与智能化成为各领域转型发展的主要趋势,同时,海量数据信息的产生使得传统的数据算法难以适应当前数据筛选的需要。

摘要:随着新一代信息技术的飞速发展,数字化与智能化成为各领域转型发展的主要趋势,同时,海量数据信息的产生使得传统的数据算法难以适应当前数据筛选的需要。为提高人工智能数据筛选的效率,本文基于深度学习,针对云计算人工智能数据筛选算法展开了研究,阐述了深度学习的内涵与应用原理,在此基础上设计了基于深度学习的云计算人工智能数据筛选新型算法。仿真实验结果显示,该算法在数据筛选实践中具有显著的效果,有效提高了数据处理的质量与效率。

关键词:深度学习;云计算;人工智能;数据筛选算法

0引言

互联网的普及使得现代信息数据的数量呈指数级增长,为传统数据筛选算法带来了极大的挑战。目前大部分云计算人工智能数据筛选多采用边缘调度模式,其应用原理主要是根据现阶段我国网络通信中的数据信息及资源现状,以一定的云中间件为载体对其进行建模,以便于确定数据筛选的调度函数,从而实现数据的高效筛选。而深度学习作为一种能够有效解决传统数据筛选资源处理效率不高、用户满足度低以及数据收敛效率不佳等问题的技术,其主要通过模拟人脑思维对数据进行处理,在各领域得到了广泛应用[1]。因此,本文主要围绕深度学习在云计算人工智能数据筛选算法化中的应用原理与实践进行全面的探讨。

1深度学习概述

近年来,深度学习在多个领域得到了广泛应用,常见的深度学习技术包括卷积神经网络(CNN)、循环神经网络(RNN)和深度信念网络(DBN)三种核心技术[2]。在应用实践中,深度学习技术通过模拟人类思维对数据进行处理,进而实现从大量数据中自动识别与学习特征与模式,其中卷积神经网络(CNN)的网络拓扑结构处理性能较为突出,因此常用于图像与视频分析。在具体应用中,首先,通过卷积层对网络数据进行采集以及特征提取;其次,在池化层将提取出的数据特征进行降维处理;最后,将处理结果经过全连接层输出。循环神经网络(RNN)则因其具有较高的处理序列数据的能力,在自然语言文本与语言信号分析处理中能够有效对节点间的循环连接产生的时间动态信息进行准确捕捉,进而表现出了极高的处理效能。深度信念网络(DBN)则是由有限个受限玻尔兹曼机层级堆叠而成的一种基于概率生成模型的深度学习架构。在实践中,深度识别模型能够实现复杂特征数据的自动提取、数据之间深层联系的识别,在特征学习与分类任务中被广泛应用。

2基于深度学习的云计算人工智能数据筛选算法优化思路

在数据筛选中,目前最为常见的云计算人工智能数据筛选算法通常采用“网-边缘”的调度模式。但在实际调度过程中,受调度参数、资源分配等因素的影响,传统数据筛选算法易出现筛选效果不佳、筛选效率较低等问题。对此,基于深度学习对云计算人工智能数据筛选算法进行优化是必要的。当前云计算人工智能数据筛选算法的调度函数主要以中间件、带宽与筛选进程等作为决定参数,属于经济调度模式。因此,在调度实践中,想要将用户任务成本在可能范围内降到最低水平,就必须大量占用云中心资源,这对用户数据质量的要求较高。对此,本文基于深度学习,引入了自适应学习率优化算法。自适应学习率优化算法的核心逻辑是根据学习模型中的历史参数与梯度等动态信息,不断调整训练过程中每个参数的学习率,从而有效解决传统云计算人工智能数据筛选算法存在的收敛速度慢、筛选效果不佳等问题[1]。该算法能够自动调整学习率,并通过累积历史梯度的平方来调整每个参数的学习率,促使算法模型在训练过程中快速收敛,降低频繁更新的参数的学习率,从而提升数据筛选模型云调度中心在多参数场景下的稳定性,实现数据的高效与有效筛选,找到全局最优解,完成算法数据的优化与有效筛选。其核心公式如式(1)所示:

3基于深度学习的云计算人工智能数据筛选算法优化设计

过拟合与欠拟合处理作为基于深度学习的云计算人工智能数据筛选算法模型的训练中提升云计算人工智能算法筛选模型泛化能力的重要手段,对数据筛选算法的性能、筛选的效率与质量具有决定性的影响[2]。本文对云计算人工智能数据筛选算法进行优化设计,从自适应学习率算法中处理过拟合与欠拟合两个方面进行。

对于过拟合问题的优化主要通过引入正则化项进行。其目的主要在于将一个能够限制数据筛选模型中各参数权重的惩罚项添加至模型的损失函数中,有效降低模型数据筛选的复杂程度,提高筛选效率。基于此,假设自适应学习率算法模型中具有两个正则化项L1与L2,其中L1的正则化旨在建立有助于特征选择的稀疏权重矩阵,在实践中,主要通过在算法模型的损失函数中加入权值向量的绝对值之和来实现;而L2正则化则是通过在损失函数中加入权值向量的平方和,尽可能地实现模型参数权重的减小,从而避免权重过大导致模型过拟合[3]。

针对欠拟合问题,在实践中,通过增加网络的层数或神经元的数量,促进数据筛选算法模型复杂度的提高,从而显著提升模型的拟合能力。但就实际状况来说,在拟合过程中,只是简单地增加算法模型的复杂度,可能会导致模型出现过拟合的问题。因此,想要有效维持云计算人工智能数据筛选模型的泛化能力,需在增加模型复杂的同时,引入正则化技术。

此外,在基于自适应学习率算法筛选模型的构建中,对于过拟合与欠拟合的处理,其关键在于学习率的设置,需注意避免学习率过高导致数据模型无法有效收敛,或因学习率过低造成数据筛选模型陷入过拟合陷阱等现象的发生。

4仿真试验

4.1试验设计

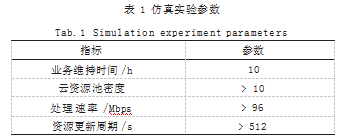

为验证上述提出的基于深度学习的云计算人工智能数据筛选算法的实践应用效果,将其与TSC-SF算法以及UEG算法进行了对比试验,旨在通过比较不同数据筛选算法下数据处理的带宽与数据筛选业务量,分析基于深度学习的自适应学习率算法在云计算人工智能数据筛选的优化效果[4]。在研究实践中,主要采用MATLAB工具对仿真环境进行创设,仿真参数如表1所示。

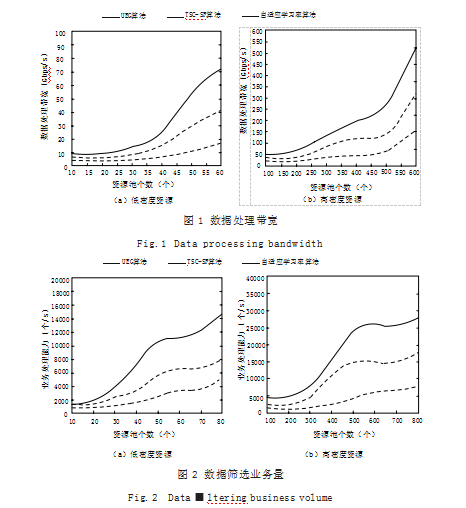

分析图1可知,在不同资源密度下,与TSC-SF算法以及UEG算法相比,自适应学习率算法的数据处理带宽始终处于高水平,并且波动幅度较小,说明该算法在处理数据时的稳定性和高效性较为突出,能够较好地应对不同资源密度下的数据处理需求[5]。

数据筛选业务量的试验结果如图2所示。

分析图2可知,在数据筛选中,自适应学习率算法表现出了明显的优势,不管是在低密度还是高密度的云资源池环境下,与TSC-SF算法以及UEG算法相比,自适应学习率算法的数据筛选的业务量和增加幅度都更大,一定程度上说明该算法在处理数据筛选任务时,具有更高的处理效率和更强的处理能力。特别是在高密度云资源池环境下,自适应学习率算法的数据筛选业务量增长更为显著,这进一步验证了该算法在复杂环境下的优越性能[6]。

5结语

综上所述,本文深入探讨了基于深度学习的云计算人工智能数据筛选算法,仿真试验表明,基于深度学习的自适应学习率算法在数据处理带宽和数据筛选业务量方面均表现出显著优势,尤其在应对不同资源密度下的数据处理需求时,其稳定性和高效性更为突出,全面揭示了该算法在数据筛选中的高效性和稳定性,为云计算人工智能数据筛选提供了新的思路和方法。

参考文献

[1]LIU S,WANG Y,DING F,et al.Joint Iterative State and Parameter Estimation for Bilinear Systems with Autoregressive Noises Via the Data Filtering[J].ISA Tran sactions,2024,147337-349.

[2]郭佳楠,阮氏福来.生成式人工智能虚假信息治理的策略探究[J].科技智囊,2025(4):67-75.

[3]胡珊.基于聚合度热点收敛映射机制的云计算人工智能数据筛选算法研究[J].科技与创新,2023(4):76-78.

[4]柴巧叶.大数据在计算机信息处理中的应用探讨[J].软件,2021,42(12):44-46.

[5]董传民,侯仰博,樊祜卿,等.基于SVM的智能情报分析数据风险特征筛选算法[J].吉林大学学报(信息科学版),2025,43(3):632-638.

[6]许睿博.基于机器学习算法的物联网大数据信息筛选与提取系统设计[J].电脑知识与技术,2024,20(16):37-39.