基于深度强化学习的数据中心资源调度算法研究论文

2025-12-29 17:50:12 来源: 作者:xuling

摘要:本研究旨在解决传统调度方法在高维状态、连续动作空间及任务异质性环境下性能不足的局限,提出了一种融合深度强化学习与任务优先级机制的智能调度算法。

摘要:本研究旨在解决传统调度方法在高维状态、连续动作空间及任务异质性环境下性能不足的局限,提出了一种融合深度强化学习与任务优先级机制的智能调度算法。该方法基于DDPG框架,结合注意力机制实现关键状态特征提取,通过优先级建模模块动态感知任务紧迫度与资源敏感性,引导策略网络做出高效调度决策。在仿真平台上构建多场景负载环境,实验结果表明,该算法在复杂调度场景下具备显著性能优势与稳定性,能够有效提升系统资源调度效率与服务质量。

关键词:深度强化学习;数据中心;资源调度

0引言

数据中心作为现代信息基础设施的核心,其资源调度效率直接影响整体服务性能与能耗水平。随着云计算、大数据与人工智能等应用的快速发展,数据中心面临着任务类型复杂、资源异构性强、调度需求多样等挑战。传统的资源调度方法难以同时兼顾系统性能、能源消耗与服务质量保障,存在鲁棒性差、适应性弱的问题。强化学习作为一种具有自适应和在线决策能力的优化方法,为解决复杂环境下的资源调度问题提供了新的思路。随着多租户云服务、边缘计算及服务器虚拟化技术的发展,数据中心资源调度正从静态分配走向更加动态、自适应的智能管理阶段。现实调度过程不仅涉及计算资源(如CPU、内存、GPU)的分配,还需综合考虑带宽、能耗、安全性与冷却成本等多维因素,形成高维状态空间与复杂的约束耦合关系。此外,任务负载呈现强烈的时序波动性与高度不确定性,如批量作业与实时请求的并发到达,进一步加剧了调度策略在效率与公平性之间的权衡难度[1]。因此,仅依靠固定规则或静态启发式方法已难以应对动态多变的调度需求。近年来,深度强化学习(Deep Reinforcement Learning,DRL)在高维连续控制问题中的表现引起广泛关注,其具备自动从数据中学习策略、适应环境变化的能力,天然契合资源调度的在线优化特性。

1数据中心资源调度与强化学习技术概述

当前常见的调度策略可大致分为启发式方法、规则驱动方法、模型预测方法与智能学习方法。启发式方法如最短作业优先(SJF)、最早截止时间优先(EDF)、轮询(Round-Robin)与资源最小使用优先(Best-Fit)等具有计算效率高、实现简单的优点,但无法全局优化资源配置。

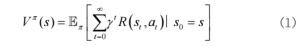

强化学习是一种基于试错机制的决策优化方法,核心思想在于智能体通过与环境交互学习策略来最大化累积奖励。在强化学习框架中,调度问题可建模为马尔可夫决策过程(Markov Decision Process,MDP)。MDP由五元组构成:(S,A,P,R,γ)。其中S表示状态空间,包含任务队列、资源负载、时间戳等系统状态;A表示动作空间,如分配节点、迁移任务、推迟执行等;P(s'|s,a)表示状态转移概率;R(s,a)表示即时奖励函数;γ∈[0,1]为折扣因子,反映长期奖励的衰减程度。强化学习的目标是学习一个策略函数π(a|s),使得在状态s下采取动作a能获得最大预期回报。强化学习方法主要通过值函数与策略函数的学习实现策略优化。状态值函数定义为状态s下的期望累计奖励,如式(1)所示:

2基于深度强化学习的调度算法设计

2.1算法架构总体设计

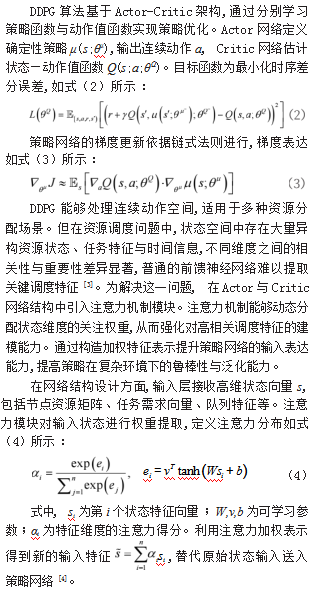

在数据中心资源调度问题中,状态空间维度高、动作空间连续、反馈延迟长等特征对调度策略的泛化能力与收敛效率提出了更高要求。传统的强化学习方法在此类场景下普遍面临策略不稳定、训练缓慢、样本效率低下等问题。基于此问题背景,设计一种具备连续动作建模能力、自适应特征提取能力、训练稳定性强的深度强化学习算法成为必要路径。本研究选择深度确定性策略梯度算法(Deep Deterministic Policy Gradient,DDPG)作为基础框架,并在此基础上引入注意力机制,以提升模型对动态调度状态的特征建模能力。该设计具备良好的可扩展性与实际适配性,适用于高维状态输入与多目标调度任务[2]。

2.2多任务调度与优先级支持机制

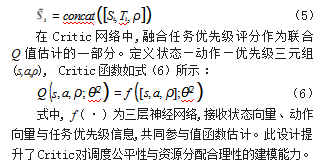

在数据中心资源调度环境中,任务类型呈现多样化,调度系统需同时面对批处理任务、在线请求、延迟敏感任务与资源密集任务等多种任务类型。多任务调度系统的关键在于能准确区分任务属性、动态调整调度策略、保障关键任务的优先响应与资源保障能力。深度强化学习方法需具备区分不同任务类别、动态评估任务紧迫度、在资源约束下完成优先级调度的能力。为实现此目标,构建具备多任务调度与优先级支持能力的智能调度架构,在原有DDPG+Attention机制的基础上引入任务优先级建模模块、多目标权重融合模块与任务指引调度策略网络[5]。

任务优先级表示模块基于任务紧急程度、资源敏感程度与时间等待程度构造任务综合优先评分函数。为实现多任务感知的策略决策结构,原有Actor网络结构引入多通道输入编码模块,分别处理不同任务类型的状态子集。设状态输入矩阵St∈Rn×d,其中n表示待调度任务数,d表示状态维度。引入任务类型标签矩阵Tt∈Rn×k,k表示任务类别总数,使用one-hot编码表示任务所属类型。构建任务加权状态表示,如式(5)所示:

3实验设计与性能评估

本实验基于模拟平台构建异构资源环境,复现数据中心任务调度过程。实验环境选用自建仿真调度器框架,参考Kubernetes调度逻辑与资源管理方式,模拟包含50个节点的计算集群,支持CPU、内存、GPU等多种资源类型。

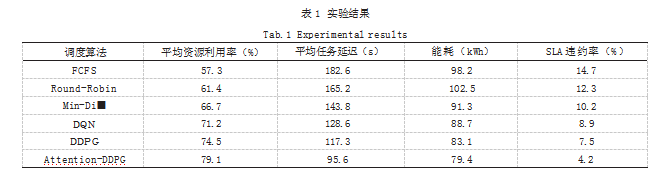

实验对比三种传统调度策略与两种强化学习基线算法。传统策略包括先来先服务(FCFS)、轮询调度(Round-Robin)与最小资源差启发式调度(Min-Di■Heuristic)。强化学习基线选取标准DDPG与DQN算法,提出的Attention-DDPG作为对比主算法。实验指标包括资源利用率、平均任务延迟、能耗水平与SLA违约率。资源利用率为任务所占用资源与总可用资源的比值,平均延迟为任务完成时间与提交时间之差,能耗依据CPU与GPU利用率映射热功耗模型计算,SLA违约率为未在截止时间内完成的任务比例。实验统计结果如表1所示。

Attention-DDPG在各项指标中表现最优,资源利用率提高至79.1%,比FCFS提升了21.8个百分点。平均任务延迟控制在95.6s,显著低于基线算法。能耗降至79.4kWh,体现出调度策略在节点资源分配上的高效性。SLA违约率为4.2%,较FCFS减少了10个百分点,证明任务完成质量显著提升。算法收敛性在10万步以内达到稳定表现,策略函数波动收敛性较DQN明显更优。参数敏感性测试发现注意力机制的引入系数对策略表现影响显著,过高权重会导致低优先级任务长时间滞留,过低权重则削弱了对关键任务响应能力。消融实验去除优先级引导项后,SLA违约率升高至9.1%,任务延迟平均增加14s,验证了优先级机制在策略中的核心作用。模型在高峰期与低谷期表现差距不超过8%,说明策略具备良好的鲁棒性与负载自适应能力。

4结语

本文围绕数据中心多任务资源调度问题,构建了基于深度强化学习的智能调度算法架构,结合DDPG算法与注意力机制实现状态建模与策略优化的有效融合。引入任务优先级支持机制,增强了调度器对多任务环境的识别与响应能力,在状态构造、动作建模、奖励函数设计与策略网络训练方面完成了系统化设计。在高仿真环境下进行了多轮对比实验与性能评估,实验结果显示所提算法在资源利用率、任务延迟、能耗控制与SLA保障等方面均优于传统调度方法,具备良好的收敛性、鲁棒性与推广性,可为数据中心复杂调度任务提供有效的智能化决策支撑。

参考文献

[1]吴亮亮.基于均衡原则的云数据中心微服务部署与弹性资源调度研究[D].武汉:华中科技大学,2024.

[2]张婉婷.数据中心能源系统能量管理与资源调度优化研究[D].上海:东华大学,2024.

[3]刘帅帅.面向云能耗优化的资源调度方法研究[D].哈尔滨:哈尔滨师范大学,2023.

[4]辛瑜.基于Kubernetes的民航信息系统资源调度与灾备恢复研究[D].德阳:中国民用航空飞行学院,2023.

[5]李世强,詹鑫毅.基于粒子群优化的工业互联云平台数据中心资源调度[J].自动化技术与应用,2022,41(7):28-31.