面向人工智能大模型安全的密码防护体系研究论文

2025-12-24 17:25:57 来源: 作者:xuling

摘要:随着人工智能技术的快速发展,人工智能大语言模型(AI)面临的安全威胁日益凸显,包括对抗样本攻击、模型反演攻击和模型窃取攻击等。

摘要:随着人工智能技术的快速发展,人工智能大语言模型(AI)面临的安全威胁日益凸显,包括对抗样本攻击、模型反演攻击和模型窃取攻击等。本文针对人工智能大语言模型的安全问题,提出了一种基于密码学方法的体系化安全防护方案,旨在重点提升模型的机密性、鲁棒性和可追溯性。通过分析密码学技术(如同态加密、安全多方计算和差分隐私)与人工智能大模型安全防御方法的融合路径,构建了涵盖数据层、模型层和应用层的三层防护体系,有效抵御安全威胁。展望了未来研究方向,包括量子安全密码学、效率优化和标准化建设等,为构建安全可信的人工智能大语言模型生态系统提供了理论支持和技术参考。

关键词:人工智能;大语言模型;安全防护;密码技术

1概述

近年来,以深度学习为代表的AI技术取得了突破性进展,在计算机视觉、自然语言处理、语音识别等多个领域展现出卓越性能。随着AI模型参数规模从百万级跃升至万亿级,Deepseek、GPT-4、通义千问等大模型已广泛应用于医疗、金融、能源等关键基础设施领域[1]。然而,随着人工智能大模型技术的广泛应用,其安全风险也日益凸显。AI模型本质上是一种数据驱动的算法,其训练数据、模型参数和推理过程均可能成为攻击者的目标,从而威胁到AI模型系统的机密性、完整性和可用性[2]。当前AI模型面临的安全威胁主要可分为三类。

(1)对抗样本攻击[3]。其通过向输入数据添加精心设计的扰动,使AI模型产生错误输出。基于生成对抗网络的对抗样本生成方法进一步提升了攻击成功率,甚至能绕过传统防御机制;在计算机视觉方面,单像素攻击等低资源需求的攻击方法也对模型鲁棒性构成挑战。

(2)模型反演攻击[4]。攻击者通过模型的输出信息反推训练数据或模型参数。最新的研究表明模型反演攻击成功率已显著提升,对训练数据隐私构成严重威胁。

(3)模型窃取攻击。攻击者通过黑盒查询方式提取目标模型的结构和参数,创建功能相同的替代模型。攻击者可对BERT等大模型进行有效窃取,通过精心设计的提示词和查询回答数据集训练小型本地模型,进而创建恶意模型。

本文面向AI模型安全的密码防护问题开展深入研究,提出了一种体系化解决方案,通过密码学方法提升AI模型的机密性、鲁棒性和溯源性,并探索其在实际应用中的效果与优化路径。具体目标包括分析AI模型面临的安全威胁及其密码学攻击路径;研究密码学技术在AI模型安全中的应用价值;提出基于密码学的AI模型安全需求;构建整合密码学技术和AI模型安全防御方法的防护体系;评估防护体系效果并提出未来研究建议。

2需求分析

2.1 AI模型参数和训练数据的安全防护需求

模型参数恢复攻击是模型机密性面临的主要威胁,攻击者可通过梯度信息、模型输出或成员推理等方式恢复模型参数。例如,模型反演攻击可从面部识别模型的输出中推断出训练对象的面部图像。针对这一威胁,需要采用密码学方法实现以下目标。

(1)在模型被部署或共享的情况下,保护模型参数不被窃取或恢复;

(2)支持多方协作训练模型,同时确保各方训练样本数据不被泄露;

(3)在黑盒环境下,保持模型机密性,防御模型窃取攻击。

2.2 AI模型鲁棒运行的需求

AI模型的鲁棒性需求主要针对对抗样本攻击。对抗样本攻击利用AI模型的输入敏感性,通过添加微小扰动导致模型误判。基于生成对抗网络的对抗样本生成技术进一步提升了攻击成功率,甚至能绕过传统防御机制。针对这一威胁,需要采用密码学方法实现以下目标。

(1)在存在噪声的情况下,提升模型对对抗样本的防御能力,保持预测准确性;

(2)在模型训练过程中引入隐私保护机制,防止训练数据被逆向推断;

(3)支持模型动态更新,适应不断变化的攻击手段。

2.3 AI模型知识产权保护和攻击溯源的需求

模型水印技术是解决这一问题的关键,但传统水印技术面临易被移除、抗攻击性差等挑战。目前,已有成熟算法在加密模型中高效嵌入水印,达到较高成功率。然而,一些开源工具已能去除大多数可检测水印,这对水印技术提出了新挑战。针对这一需求,需要采用密码学方法实现以下目标。

(1)提供可证明安全的水印机制,确保水印在模型传输、部署和推理过程中不可移除;

(2)支持多模态模型溯源,包括图像、视频和文本等多种数据类型的水印检测;

(3)实现攻击行为的可追溯性,为模型安全事件提供证据链。

3 AI模型安全的密码防护体系设计

3.1总体架构

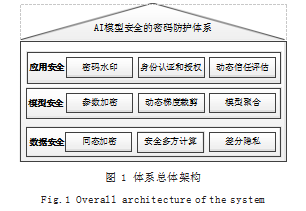

基于上述需求,提出一种三层防护体系,整合密码学技术和AI安全防御方法,总体架构如图1所示。

数据安全防护。采用同态加密[5](Homomorphic Encryption,HE)、安全多方计算[6](Secure Multi-Party Computation,SMC)和差分隐私[7](Differential Privacy,DP)等技术保护训练数据和推理数据的隐私。HE允许在不解密的情况下进行数据处理;SMC支持多方数据协作而不泄露原始数据;DP通过添加噪声保护数据个体隐私。

模型安全防护。结合密码学技术与AI防御方法,保护模型参数和训练过程的安全。通过HE加密模型参数防止窃取;利用DP动态梯度裁剪防御对抗攻击;采用SMC实现安全的模型聚合和梯度更新。

应用安全防护。在模型部署和应用阶段,采用密码学水印、访问控制和动态评估等技术,确保模型的合法使用和安全运行。通过可证明安全水印实现模型溯源;利用国密算法进行身份认证和授权;建立动态信任评估机制检测权限冲突。

3.2数据安全防护

数据安全防护主要解决模型训练和推理过程中的数据隐私问题。

(1)同态加密。在模型训练阶段,采用轻量化同态加密技术对原始数据进行加密,确保数据在传输和处理过程中不被泄露。在模型推理阶段,使用全同态加密(Fully Homomorphic Encryption,FHE)技术对输入数据进行加密,使模型只能处理加密数据,无法获取明文信息。

(2)安全多方计算。在联邦学习框架中,结合SMC技术实现多方数据协作。该技术允许不同数据拥有方在不共享原始数据的情况下共同训练AI模型,并通过秘密共享机制,将数据划分为n份,由n个参与方保管,只有t个参与者合作才能恢复原始数据,有效防止数据泄露。

(3)差分隐私。在数据收集和模型训练过程中,通过添加精心设计的噪声保护数据个体隐私。动态梯度阈值裁剪技术优化了差分隐私生成对抗网络的生成质量,平衡隐私保护与数据可用性。在联邦学习中,可通过本地差分隐私和中心差分隐私的混合加噪方式进一步提升隐私保护效果。

3.3模型安全防护

模型安全防护主要解决模型参数和训练过程的安全问题。

(1)同态加密参数保护。采用HE技术对模型参数进行加密,防止模型窃取。该技术通过对其权重参数的同态加密保证了数据的隐私性,并显著减少了训练过程中的加解密计算量。

(2)差分隐私训练。在模型训练过程中,通过DP技术限制模型对单个训练样本的敏感性。算法通过对聚合参数添加中心化差分高斯噪声隐藏参与训练的成员贡献,保护参与方隐私信息。

(3)安全多方计算训练。在联邦学习中,结合SMC与HE技术实现安全的模型聚合和梯度更新。模型通过同态加密对模型训练的中间结果进行加密,确保梯度数据在传输过程中的安全性。

3.4应用安全防护

应用安全防护主要解决模型部署和使用阶段的安全问题。

(1)可证明安全水印。采用新型水印技术,通过低FPR下的高TPR和多模态兼容性实现模型溯源。水印信息可嵌入在模型参数中,并通过密码学签名确保不可篡改性。

(2)身份认证和授权。在模型访问和使用过程中,采用SM2/SM3/SM4等密码算法进行身份认证和授权。动态信任评估支持不少于3种鉴权因素,权限冲突可检测与消解。该机制确保只有授权用户才能访问和使用模型,防止未授权访问。

(3)威胁情报与主动防御。构建威胁情报共享机制,获取和使用人工智能安全威胁情报,赋能人工智能安全系统、设备和人员。通过持续安全监测、安全事件分析、安全防御响应和安全威胁预测,实现动态、自适应、自生长的安全能力。

4结语

本文创新性地构建了一个融合同态加密、安全多方计算与差分隐私的三层密码防护体系,为解决人工智能大语言模型的机密性、鲁棒性与可追溯性问题提供了系统性方案。

未来研究应聚焦于量子安全密码学、效率优化和标准化建设,推动密码学与AI技术的深度融合,构建既智能又安全的新一代AI系统。通过密码学方法提升AI模型的机密性、鲁棒性和溯源性,不仅能够解决当前的安全威胁,还能为AI技术的健康发展提供保障,为人类社会的智能化转型保驾护航。

参考文献

[1]马傲,葛小玲.人工智能大模型在医疗健康领域应用的研究[J].中国现代医生,2024(11):89-95.

[2]崔晗,薛彤,王琦,等.针对电力系统人工智能算法的数据投毒后门攻击方法与检测方案[J].电网技术,2024,48(12):5024-5033.

[3]陈岳峰,毛潇锋,李裕宏,等.AI安全—对抗样本技术综述与应用[J].信息安全研究,2019,5(11):1000-1007.

[4]秦臻,庄添铭,朱国淞,等.面向人工智能模型的安全攻击和防御策略综述[J].计算机研究与发展,2024,61(10):2627-2648.

[5]戴怡然,张江,向斌武,等.全同态加密技术的研究现状及发展路线综述[J].电子与信息学报,2024,46(5):1774-1789.

[6]郭娟娟,王琼霄,许新,等.安全多方计算及其在机器学习中的应用[J].计算机研究与发展,2021,58(10):2163-2186.

[7]胡韵,刘嘉驹,李春国.一种基于差分隐私的可追踪深度学习分类器[J].信息安全研究,2022,8(3):277-291.