基于双向多尺度加权融合与三维注意力 (BiMSWTrack) 的无人机视频多目标跟踪论文

2025-12-24 15:25:11 来源: 作者:xuling

摘要:近年来,多目标跟踪(Multi-Object Tracking,MOT)技术在智能监控、自动驾驶和无人机巡航等领域得到了广泛关注。

摘要:近年来,多目标跟踪(Multi-Object Tracking,MOT)技术在智能监控、自动驾驶和无人机巡航等领域得到了广泛关注。针对无人机航拍场景中小目标尺度变化大、易被遮挡、背景复杂导致检测与关联性能下降的问题,本文提出了一种双向多尺度加权融合跟踪模型(BiMSWTrack)。实验证明,BiMSWTrack在VisDrone2019-MOT测试集上实现了55.9%的MOTA,且IDF1达到69.8%,在保证实时性的同时,大幅减少了漏检、误检与ID切换,为复杂环境下的多目标跟踪任务提供了高效、鲁棒的解决方案。未来,BiMSWTrack支持端—边—云全链路:在Jetson上以Isaac ROS实时跟踪;在QGroundContro中叠加回放与协同监控;在Kubernetes+TensorFlow Serving平台做云端优化与指令下发。

关键词:多目标跟踪;特征融合;无人机航拍

0引言

随着深度学习和计算机视觉技术的飞速发展,多目标跟踪(MOT)成为视频分析领域的核心研究方向之一,被广泛应用于智慧城市、人群监控、自动驾驶、无人机视觉等场景[1]。MOT的目标是实时检测并连续保持视频序列中多个目标的身份一致性,但在光照变化、运动模糊、小目标密集及遮挡等复杂条件下,常规方法易出现漏检、误检和ID切换等问题。

当前,主流的MOT方法多采用“检测—关联”(tracking-by-detection)框架:首先利用高性能检测器(如YOLO系列)对每帧进行目标定位,然后基于外观、运动等特征完成跨帧关联[2]。YOLOX-s作为最新一代深度学习。

轻量级单阶段检测器,通过Anchor-Free策略与解耦检测头在速度与精度之间取得了良好平衡,被广泛用于实时跟踪系统中。然而,当应用于无人机视角拍摄的图像时,小目标数量占比较高、尺度变化剧烈以及复杂背景干扰使YOLOX-s的检测性能受到明显制约,进而影响整个跟踪流程的稳定性。

在关联阶段,ByteTrack[3]提出了一种名为BYTE的高效数据关联策略,不仅关联高置信度框,还对低置信度框与现有轨迹进行匹配,可以有效恢复被遮挡目标并抑制背景误检,显著降低漏检和轨迹碎片化现象[4]。尽管ByteTrack在MOT17等基准上达到了领先水平,但在目标完全遮挡或极端小尺寸情况下,仍难以保证连续的身份一致性,ID切换和漏检问题依旧存在。

1 BiMSWTrack模型及关键模块设计

本文提出了一种基于检测的双向多尺度加权融合跟踪模型(BiMSWTrack),旨在解决无人机航拍场景下多目标跟踪中的小目标检测困难、遮挡严重、背景复杂等挑战。该算法结合了YOLOX-s检测器和ByteTrack跟踪器,并在此基础上引入了双向特征金字塔网络(BiFPN)和三维注意力模块(3DAM),以增强多尺度特征融合和目标特征提取能力,从而提高跟踪的准确性和鲁棒性。

1.1双向多尺度特征融合模块

在无人机航拍场景中,由于飞行高度与视角的动态变化,图像中的目标往往呈现出尺度极小且形变多样的特点,同时复杂的背景纹理常常干扰网络对微弱目标特征的提取,致使小目标易被淹没于噪声之中,降低检测与跟踪的精度和鲁棒性。为了解决上述问题,本文引入了BiFPN作为对YOLOX-s颈部的结构化改进,以实现高效且精细的多尺度特征融合,从而强化小目标的多层级响应能力。

BiFPN在传统FPN基础上同时构建自顶向下与自底向上的双向跨层通路,使高层语义与低层细节得以多轮交互并互补增强。与PANet单向融合不同,BiFPN删除了只含单一路径输入的节点以简化网络结构,同时在同一层级的输入与输出节点间新增跨节点边,在不显著增加计算量的前提下融合同尺度特征,提升局部表达效率。其核心的加权特征融合机制采用快速归一化融合,即对每路输入特征学习可训练的非负权重,并在加权相加前进行归一化,使模型能够动态识别不同分辨率特征的重要性,替代了传统的简单求和或拼接方式,显著提高了融合精度与训练稳定性。此外,BiFPN支持将每条双向路径视为独立的融合层并可重复堆叠多次,通过调节堆叠深度,在不同算力条件下实现精度与效率的灵活平衡,从而在视觉尺度剧烈变化的无人机航拍任务中,保持优异的小目标检测与跟踪性能。

1.2三维注意力模块

为了进一步增强特征表示能力,BiMSWTrack引入了三维注意力模块(3DAM),该模块基于神经科学中能量最小化的思想,对特征图中每个神经元与其邻域像素关系构建能量函数,并通过闭式解一次性推导出三维注意力权重,在通道与空间两个维度实现精细加权,而无需任何可训练参数。

与SE模块仅做通道建模、CBAM分离通道/空间注意力不同,3DAM直接在三维空间上生成注意力图,能够更有效地抑制背景噪声并突出细粒度目标特征。具体而言,3DAM在每个特征图上计算其通道维度和空间维度的注意力权重,通过对特征图进行加权操作,增强了目标区域的特征响应,抑制了背景区域的干扰,从而提高了目标检测与跟踪的准确性。

此外,3DAM的无参数设计使其在不增加模型复杂度的情况下,提升了特征表示能力,适用于资源受限的边缘设备部署,满足实时性要求。

2实验与讨论

2.1实验数据集

本研究选取了无人机视觉跟踪领域广受关注的VisDrone2019-MOT[5]数据集,该数据集由天津大学AISKYEYE团队发布,基于不同型号无人机在我国14座城市的多种场景(城市街道、乡村道路、广场、立交桥等)下拍摄的视频序列构建,共包含79段视频序列,累计33366帧高分辨率图像。数据集中标注了10类常见目标(行人、轿车、自行车、三轮车等),但在MOT评测中只选取了行人(pedestrian)、轿车(car)、面包车(van)、公交车(bus)和卡车(truck)5个主流类别进行性能评价。为保证算法评估的严谨性与可比性,将数据进行划分:训练集56段(24198帧)、验证集7段(2846帧)及测试集17段(约6635帧),所有视频均提供完整的目标边界框与身份ID标注,并附带目标可见性、遮挡程度等属性标签。由于无人机在飞行中的视角与高度不断变化,镜头运动轨迹不规则,且拍摄角度常伴随俯视与侧视切换,导致目标尺度剧烈变化并易出现运动模糊与遮挡,这使得VisDrone-MOT成为一个极具挑战性的多类别跟踪基准。该数据集的高小目标密度和复杂背景干扰进一步考验跟踪算法在精度与鲁棒性上的兼顾,为无人机航拍场景下多目标跟踪的研究与应用提供了高标准的评测平台。

2.2实验软件设置及参数配置

实验在Linux系统上进行,系统配置为NVIDIA GeForce RTX 3090,深度学习框架采用PyTorch。训练过程中,检测分支和ReID分支均使用SGD优化器,初始学习率设为1×10-3,学习率按照余弦退火策略进行动态调整以保证训练稳定收敛。输入图像大小固定为1600×896,考虑显存限制,模型整体训练40个epoch。

2.3不同模型对比

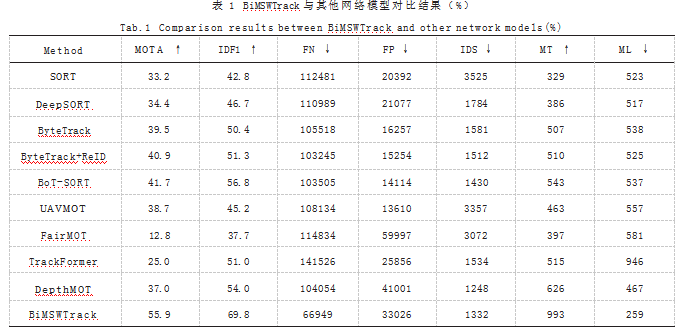

为全面验证BiMSWTrack的有效性,本文将其与多种先进MOT算法在VisDrone2019-MOT测试集上进行了对比。采用多目标跟踪精度(MOTA)和识别F1(IDF1)值等性能指标,其中,MOTA侧重于检测水平预测值与真实值的匹配,但不考虑关联性,IDF1值侧重于目标与ID之间的关联性,两者的结合能更好地反映模型的多目标跟踪性能。各方法在该基准上的性能对比如表1所示。结果表明,BiMSWTrack在多目标跟踪任务中表现出色,尤其在处理复杂背景和小目标等挑战性场景下,展现了其优越的性能。其在多个关键指标上的领先表现证明了其在无人机航拍图像目标跟踪中的实用性和有效性。

3结语

本文提出的BiMSWTrack算法在VisDrone2019-MOT数据集上进行了全面评估,实验结果表明,该算法在多目标跟踪任务中表现优异,尤其在处理小目标、复杂背景和遮挡等挑战性场景下,展现了其卓越的性能。具体而言,BiMSWTrack在MOTA和IDF1等关键指标上均优于现有的先进方法,验证了其在无人机航拍图像目标跟踪中的实用性和有效性。未来,BiMSWTrack可部署于NVIDIA Jetson系列机载边缘设备,并借助Isaac ROS将检测与关联流程封装为ROS节点,实现飞行中基于视觉的实时多目标跟踪NVIDIA Developer;地面端通过QGroundControl的Video Streaming与Subtitle Overlay功能,将跟踪结果与航迹信息叠加展示,支持视频回放与多用户协同监控;云—边协同方面,采用Kubernetes+TensorFlow Serving容器化架构,将边缘推理结果上传云端进行轨迹优化与批量分析,实现低时延指令下发与大规模数据同步。

参考文献

[1]刘丽媛,曾倩,周省邦,等.无人机视频中的目标跟踪研究综述[J].传感技术学报,2025,38(1):21-30.

[2]王文胜,何君尧,黄民,等.融合梯度改进YOLO和KCF模型的无人机目标识别跟踪算法[J].仪器仪表学报,2025,46(2):221-233.

[3]ZHANG Y,SUN P,JIANG Y,et al.Bytetrack:Multi-object Tracking by Associating Every Detection Box[C]//European Conference on Computer Vision.Cham:Springer Nature Switzerland,2022:1-21.

[4]周翰祺,方东旭,张宁波,等.基于深度学习的多无人机多目标跟踪[J].计算机工程,2025,51(4):57-65.

[5]DU D,ZHU P,WEN L,et al.VisDrone-DET2019:The Vision Meets Drone Object Detection in Image Challenge Results[C]//Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision Workshop(ICCVW).IEEE Computer Society,2019:213-226.