基于 LLM 的智能代码补全系统设计与性能评估论文

2025-12-16 17:20:53 来源: 作者:xuling

摘要:基于大语言模型(Large Language Models,LLM)的代码补全技术为软件开发带来了新机遇。文章构建了一种基于LLM的智能代码补全系统,设计涵盖系统架构、上下文建模、提示构造、多语言支持等关键模块。

摘要:基于大语言模型(Large Language Models,LLM)的代码补全技术为软件开发带来了新机遇。文章构建了一种基于LLM的智能代码补全系统,设计涵盖系统架构、上下文建模、提示构造、多语言支持等关键模块,采用静态与动态上下文融合策略,结合自定义Prompt模板,实现代码语义的精准建模与提示优化目标。在模型适配方面,引入迁移学习机制,增强跨语言泛化能力。性能评估实验结果表明,该系统在多种语言环境下均表现出了较高的补全准确率与响应效率,具备良好的实用价值与扩展潜力。

关键词:大语言模型;代码补全;上下文建模;性能评估

0引言

随着人工智能技术的发展,特别是自然语言处理领域中大语言模型的突破,智能编程工具正以前所未有的速度革新软件工程实践。开发者面临的代码复杂性与多语言支持需求不断提高,推动了更智能、更语义化的代码辅助工具的出现。在这种背景下,探索利用LLM提升代码补全能力成为业界与学术界关注的热点问题。

1基于LLM的智能代码补全系统总体架构设计

基于LLM的智能代码补全系统整体架构采用“模态编码器—连接模块—大语言模型—生成器”四层串联结构,利用下层嵌套模块完成输入向量转换与多模态信息融合。支持图像、音频与视频等多模态输入,通过Modality Encoder统一嵌入向量空间,经由Connector模块进行语义对齐,再输入至LLM主干网络处理[1]。在底层结构中,MLP用于初步投影,Q-Former模块以Learnable Queries为核心,实现Key-Value语义提取与重构。多头注意力机制(MH-Attn)进一步完成编码融合,最终通过Generator输出文本或其他格式。

2智能补全引擎的设计与实现

2.1代码上下文建模策略

2.1.1静态分析与抽象语法树

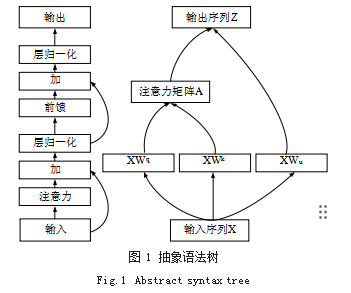

静态分析作为构建代码上下文语义模型的第一步,依托抽象语法树(Abstract Syntax Tree,AST)对源代码结构进行语法级解析。AST结构如图1所示,展示了代码从输入到输出的高阶变换路径,主要包含输入、注意力机制、前馈网络与层归一化等模块的逐层处理。系统采用语言特定的Parser(如Python中的ast库、JavaScript中的Acorn)将源代码解析为层级化的AST节点,节点类型包括函数定义(FunctionDef)、变量声明(VarDecl)、调用表达式(CallExpr)等共计42种类型,平均每100行代码可生成超过270个AST节点。通过对AST路径的深度遍历与特征提取,系统提炼出关键代码元素的语义依赖路径,并通过结构编码器(如TreeLSTM)对其进行向量化处理,实现语义结构的静态建模。AST结构中的节点位置、作用域边界与调用关系可进一步为LLM生成高质量Prompt提供结构性先验,有效提升代码补全的准确性与上下文关联性。

2.1.2动态上下文获取与缓冲机制

为应对实际编码场景中用户频繁编辑与多段代码跳转问题,系统设计了动态上下文感知机制。该机制以最近活跃窗口为核心参考点,提取最近N段函数、变量定义与调用语境,其中N默认设为10,最长Token窗口为2048 tokens[2]。缓存区基于LRU(Least Recently Used)策略实现优先级淘汰,并按语言特性动态加权,保证核心上下文不被覆盖。为增强动态上下文感知能力,系统设计了上下文重要度加权策略,定义如式(1)所示:

式中,Sm表示第m个代码块对当前补全任务的上下文重要度;εm为该块与当前编辑位置之间的语义相似度得分(归一化后取值区间为[0,1]);θm表示该块在最近历史交互中的激活频次;超参数设定为δ=0.6、ζ=0.4,满足δ+ζ=1;u为候选上下文块总数。该函数融合了语义相关性与编辑活跃度两种信息,为上下文调度机制提供权重依据,有效提升了多段代码连续补全的一致性与准确率。

2.2提示构造与模型交互

2.2.1 Prompt模板设计

为提升LLM在代码补全任务中的响应准确率与生成稳定性,系统基于任务导向构建多类型Prompt模板,涵盖函数续写、变量命名、代码注释、库导入建议等典型场景。在设计过程中,充分考虑上下文窗口限制与语义连贯性,模板结构由三部分组成:问题指令、上下文片段和目标位置标记。以函数补全任务为例,模板平均长度控制在512~768 tokens之间,其中上下文占比约为72%,目标区域占比不超过15%,其余部分为系统引导语与格式提示。

2.2.2连续提示与代码块管理策略

在交互式补全任务中,系统引入连续提示机制并结合代码块管理策略,该机制以分块管理器(Chunk Manager)为核心,将连续的代码历史按逻辑结构切分为函数块、类块、注释块等语义单元,每块最大长度不超过512 tokens,平均块间重叠窗口设为96 tokens,以保证连续Prompt间信息完整性[3]。在此基础上,系统引入了一个复杂的提示质量评估函数,用于衡量每一提示块对最终预测质量的贡献,该函数定义如式(2)所示:

2.3多语言支持与语义泛化

2.3.1跨语言抽象建模

为实现统一的多语言支持,系统采用跨语言抽象建模策略,将不同语言中的语法结构、语义表达与调用逻辑进行统一中间表示转换。该过程借助代码中间表示(Intermediate Representation,IR)将多语言代码归约至统一的抽象语义树(Universal AST,UAST),进而提取跨语言通用元素如控制流(if/while)、数据操作(array/map)、函数语义(call/return)等。构建的UAST支持13种主流编程语言(含Python、C++、Go等),每段代码经抽象转换后可压缩至原始Token数的58.2%,大幅降低了输入冗余。为进一步度量语言间语义迁移的距离,系统引入跨语言结构相似度函数,定义如式(3)所示:

式中,R为跨语言代码块相似度;Bj与Dj分别表示不同语言中第j类语义块的频度;κ为总语义块类型数。

2.3.2模型适配与迁移学习策略

考虑到不同语言具有不同的语法细节与表达习惯,首先,通过Adapter结构对模型中间层进行语言注入,实现轻量级参数调整,每种语言平均仅需新增1.3M参数,即可保持与全模型微调相当的表现[4]。其次,系统设计了多阶段迁移学习流程,先在语言无关的大规模语义表示数据集(80GB)上进行预训练,再在目标语言小规模高质量数据(≤5GB)上进行微调优化。为评估迁移效果,系统定义了跨语言适配性能函数,如式(4)所示:

3性能评估与实验设计

3.1实验环境与测试数据集

为了全面验证所提出的基于LLM的智能代码补全系统的有效性,实验设计覆盖多个关键变量,包括上下文长度、语言类型、提示结构、模型大小与推理延迟。系统部署于包含4×NVIDIA A100(80GB)GPU的分布式集群上,操作系统为Ubuntu 22.04,深度学习框架为PyTorch 2.1,语言模型使用CodeLLaMA-13B并集成高效推理组件FlashAttention v2。每组实验任务包含1000条不同复杂度的补全指令,涵盖Python、JavaScript、Go、C++等8种语言,并控制Prompt长度在512~2048 tokens范围内波动,以测试模型在长上下文条件下的响应能力[5]。系统在提示构造阶段应用结构化Slot Filling技术,并辅以AST信息增强建模上下文的语义深度,保障补全准确性与语义完整性。

3.2评估指标与结果分析

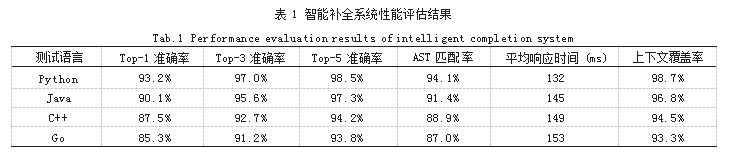

为了评估系统性能,从多个维度对模型补全质量与执行效率进行了定量分析。指标包括Top-k(k=1,3,5)补全准确率、AST匹配精度、平均响应时间、语言泛化率与上下文覆盖率等。为体现实验对比效果,统计结果如表1所示。

由表1数据可知,系统在高资源语言如Python和Java中表现最优,Top-1准确率分别达到93.2%与90.1%;而在语法结构复杂的C++和Go语言中,准确率虽略有下降,但仍维持在85%以上。AST结构一致性平均为90.35%,表明补全代码在语义结构上与目标函数保持高度一致。整体响应时间控制在132~153ms区间,表明系统具备良好的实时交互性与语言适应能力,验证了上下文建模与提示结构设计的有效性。

4结语

通过对基于大语言模型的智能代码补全系统进行系统化设计与实验评估,本文揭示了语义上下文建模、Prompt工程与多语言迁移策略在提升补全准确性和系统响应效率中的关键作用。结合静态语法分析与动态上下文缓存机制,可以有效提升模型对代码意图的理解能力;跨语言抽象建模与轻量化迁移学习策略显著增强了系统的泛化性,验证了大语言模型在多语言代码补全场景中的普遍适用性。未来研究应深入探索更具通用性的语义对齐机制与长期依赖编码结构,进一步提升对多语言异构代码环境的适配能力,推动智能编程技术向更高层次发展。

参考文献

[1]李溪子.基于机器学习算法的智能代码补全工具开发与实现[J].软件,2025,46(2):98-100.

[2]周露.基于RNN的JAVA代码补全模型设计与应用[D].重庆:西南大学,2024.

[3]张钦.基于抽象语法树的代码补全[D].镇江:江苏科技大学,2024.

[4]姜人楷.智能合约漏洞代码自动化生成技术研究[D].成都:电子科技大学,2024.

[5]张钦,郑尚,邹海涛,等.一种融合注意力机制的形变LSTM智能代码补全方法[J].小型微型计算机系统,2024,45(2):498-504