DDYOLO: 面向水下图像领域的目标检测论文

2025-12-16 10:53:22 来源: 作者:xuling

摘要:随着海洋资源开发与生态监测需求的日益增长,针对水下生物的识别检测成为海洋探测技术的核心环节。然而,水下环境存在色差色偏等问题,导致传统目标检测模型在水下场景中性能衰减显著。

摘要:随着海洋资源开发与生态监测需求的日益增长,针对水下生物的识别检测成为海洋探测技术的核心环节。然而,水下环境存在色差色偏等问题,导致传统目标检测模型在水下场景中性能衰减显著。针对这一情况,本文提出基于YOLOv11的改进模型,在骨干网络(backbone)的C3k2模块中,将标准卷积替换为光照自适应深度可分离卷积(IDWC),通过全局光照感知与动态权重调制,自适应校正水下图像的色偏与光照衰减。在检测头(head)部分引入动态采样模块(Dysample),动态调整采样位置与权重,提升模型对多尺度水下生物的识别精度。实验结果表明,改进模型在URPC2020(Underwater Robot Picking Challenge 2020 Dataset)数据集上的平均均度精值为72.3%;在RUOD(Rich Underwater Object Detection Dataset)数据集上的平均均度精值为84.1%,参数量为9.5M。

关键词:水下图像;目标检测;图像识别。

0引言

海洋探测在海洋资源开发、生态环境保护等领域具有不可替代的价值,而水下图像识别技术的性能决定了水下机器人、自主潜水器等装备的作业效率。针对水下海底世界的探测工作是一项充满挑战性的工作,会涉及多个领域的知识。图像识别是海洋探测领域的关键技术,但由于水下环境复杂,光学退化,会造成色彩失真(如普遍出现蓝色、绿色的色偏色差),还会使目标与图片的背景分布重叠。图像常受到光线衰减、色彩失真、悬浮颗粒干扰等影响,复杂的水下场景给目标探测和识别带来了巨大挑战。目标生物存在的形态多样性与尺度方面的差异都进一步加剧了检测的难度,目标的运动模糊会进一步破坏识别局部纹理特征,使基于深度学习的特征映射出现偏移。现有的目标检测模型(如Faster R-CNN、YOLO系列)在日常生活场景中表现优异[1],但当应用在水下环境时,复杂的光学退化效应和目标生物的尺度差异(如细长的水母、半透明的浮游生物)会导致模型的性能受到限制。而水下图像的低对比度、模糊和噪声干扰也进一步增加了目标检测的难度。

Wang等人[2]针对YOLOv9做出改进,检测城市道路中的小目标,但所有数据都基于单一数据集,无法证明模型的普适性。Li等人[3]优化YOLO结构,针对野火形态多变的特征,引入多尺度特征融合和动态阈值机制,但没有明确地量化模型对小尺度野火目标的精度损失,限制了模型在较高需求场景下的应用。Li等人[4]改进了YOLOv3,引入多尺度特征增强和自适应锚框调整策略,解决了水下目标模糊、形变等问题,但引入复杂模块会导致模型的推理速度下降,在实际部署过程中需要调整,否则可能会影响水下设备的实时检测。Guo等人[5]提出改进的多尺度视网膜增强算法,提升水下图像的清晰度和对比度,但这种算法可能会增加计算负担,影响实时性。Xiao等人[6]改进了多尺度特征融合机制,增强不同层次特征的交互和融合,但并没有充分覆盖极端的水下场景。YOLOv5s在水下目标检测中可能会受噪声和目标尺度变化的影响,Hua等人[7]提出了一种新型的水下目标检测器,通过特征增强的门控模块和动态融合机制,提升了针对小目标的检测能力。Cai等人[8]提出了一种基于弱监督学习的水下检测方法,利用两个YOLOv5检测器互相训练,实现了精度与速度的平衡。杨谢柳等人[9]研究了14种水下图像增强方法和3种深度学习方面的目标检测模型,这些方法在进行跨数据集检测时有较为明显的优势,但是单独使用各个方法对提升整体的检测精度没有很大的作用。

综上所述,基于深度学习的目标检测方法已经广泛应用于水下图像的检测识别中,然而水下图像仍然存在色彩失真、不均匀光照等问题,因此本文提出了一个基于YOLOv11网络结构的水下图像识别改进方法。本文改进方法如下:首先,将光照自适应深度可分离卷积(Illumination-Adaptive Depthwise separable Convolution,IDWC)模块引入backbone的C3k2结构中;其次,将上采样结构替换为动态采样模块(Dynamic Sampling Module,Dysample)。实验表明,该方法在URPC2020(Underwater Robot Picking Challenge 2020 Dataset)和RUOD(Rich Underwater Object Detection Dataset)标准数据集上实现了更好更优的检测精度与泛化性能[10],为针对水下场景的应用提供了一种新的模型方法。

1相关工作

水下环境复杂多变,采集到的水下图像数据集存在色差、色偏和漂浮物干扰等问题。考虑到大多数网络模型对水下生物的识别精度较低,本文在原本的YOLOv11模型中引入IDWC卷积模块,通过光照感知和特征自适应增强提升识别性能。在采样过程中,对原本的Upsample上采样作出改进,引入并替换为Dysample模块,动态调整卷积核的采样策略。模型的整体网络结构如图1所示[11]。

1.1光照自适应深度可分离卷积(IDWC)

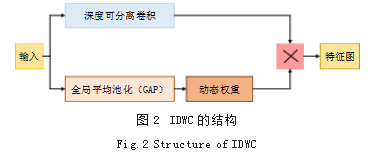

光照自适应深度可分离卷积(IDWC)是一种基于深度可分离卷积做出进一步改进的轻量化卷积,减少了模型的计算量和参数量。其基本结构如图2所示。

光照感知模块从输入特征图中提取信息,对每个通道单独执行全局平均池化(GAP),捕获图像的全局光照分布,将空间维度压缩为1×1,每个通道的均值都反映了当前通道的整体亮度。将池化后的统计量通过两层全连接层,第一层将通道维度压缩到C/r,减少计算量,第二层恢复为C维度。最后的向量中每个元素都量化了第i个通道对光照变化的敏感度,元素的值越大,说明当前的通道受到光照的干扰越明显,需要受到调制。生成通道注意力权重,动态调整深度可分离卷积的输出,使网络增强有用的特征。深度可分离卷积先逐通道进行空间卷积,对每个输入通道分别应用一个独立的卷积核,得到初步的空间特征。将每个通道的卷积结果和光照感知模块的输出元素相乘,在光照敏感的通道中,通过加权来增强有效特征、削弱无效的信息;对稳定的通道保持卷积结果不变,避免因为过度的调整导致特征丢失。在不改变通道数的情况下,在空间维度上进行特征提取,使用1×1的卷积对输出进行跨通道融合,同时调整输出的维度,减少参数量,分离空间和光照特征的耦合性,生成最终的特征图。结合深度可分离卷积的轻量化特性,IDWC在保持计算效率的同时,将光照感知机制引入了深度可分离卷积,实现轻量和鲁棒性的统一,提升了模型在复杂光照条件下的特征提取能力,适用于水下图像的复杂情况。

1.2动态采样模块(Dysample)

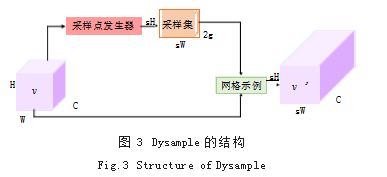

将YOLOv11结构中的上采样(Upsampling)模块改为动态采样(Dysample)模块,Dysample的基本结构如图3所示。

根据输入数据的特征动态调整采样策略,通过对图像中不同区域的特征信息进行分析,自适应地决定采样的位置、步长等参数。先对输入的图像进行特征提取分析。将“最近初始化”改为“双线性初始化”,使初始的采样位置分布均匀,从而不忽略相邻点之间的位置关系;通过静态范围因子限制偏移量的移动范围,减少采样点的重合,通过sigmoid函数生成点级别的动态范围,增强偏移的灵活性;初始的采样在双线性插值的基础上生成,可以确保均匀分布,偏移量通过像素重排转换为坐标场,和初始的叠加得到动态采样的位置。将特征图沿通道维度分成多个组,每个组共享采样设置等内容,提升特征多样性和采样效率。通过“线性投影生成偏移量→调整偏移范围→分组采样→网络采样执行上采样”的流程,输出具有高分辨率的特征图。Dysample通过局部约束偏移范围,将每个采样点的偏移限制在初始位置的区域内,防止了跨区域的干扰;将特征图划分为多组,每组独立生成偏移量,进一步减少计算量;将上采样转化为针对特征图的动态重采样,避免了传统的局限性。

2实验

本文采用URPC2020(Underwater Robot Picking Challenge 2020 Dataset)和RUOD(Rich Underwater Object Detection Dataset)水下数据集,数据集包含常见的水生类别,包括海星、珊瑚、海参、水母等,两个数据集合计20743张高分辨率图像。

网络模型部署在云端服务器,采用torch框架,训练使用的显卡为RTX 3090(24GB),输入图像大小为640*640,初始学习率设置为0.01,训练总轮次为100轮。

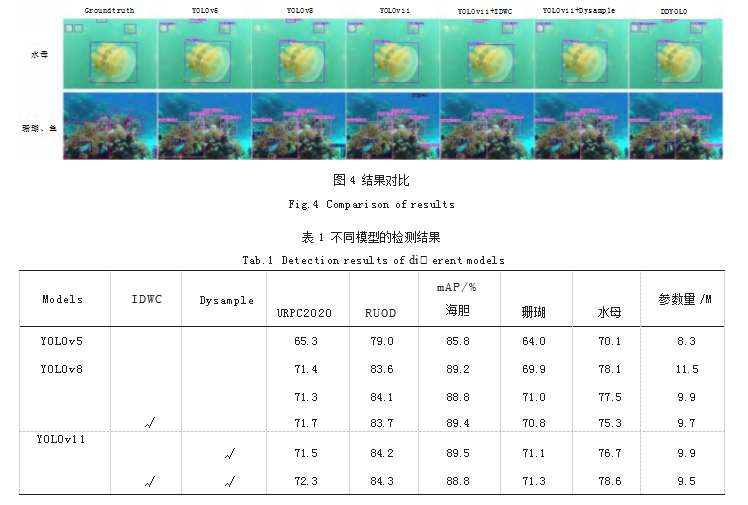

评估数据集选取RUOD数据集中的随机4200张图片,评估指标采用平均均值精度(mean Average Precision,mAP)和模型参数量,其中,mAP越大代表模型性能越好,参数量越小代表模型占用的内存越小。不同方法在RUOD数据集中对水母、珊瑚和鱼三种生物种类的检测结果如图4所示。

从RUOD数据集中随机选取两张图片进行检测。在针对水母的检测中,本文的方法可以更多、更准确地检测到模糊处的水母生物。在针对珊瑚的检测中,其他方法无法检测或识别错误图片右下角的珊瑚生物,本文方法可以较为准确地检测到右下角的珊瑚生物。在针对鱼的检测中,其他方法无法识别出图片中心的正对设备游行的鱼,但本文方法可以做到。

通过图4的效果对比可知,DD-YOLO对水下图像的目标具有较好的检测效果,证明了本文方法的优异性。为进一步体现模型的准确性,对各项具体评价指标进行对比,检测结果如表1所示。

从表中可以看出,对URPC2020数据集整体的检测中,YOLOv11结合IDWC模块的精度为71.7%,结合Dysample模块检测精度为71.5%,本文方法检测精度为72.3%;对RUOD数据集整体的检测中,YOLOv11结合IDWC模块的精度为83.7%,结合Dysample模块检测精度为84.2%,本文方法检测精度为84.3%。以珊瑚生物为例,虽然在mAP评估指标中,存在其他模型的数值更好,但本文方法在整体上效果更好。YOLOv5的参数量最少,但是效果最差,本文方法的参数量虽然有所提高,但还是小于YOLOv8,同时精度更高。

3结语

本文针对复杂多变的水下环境以及水下目标检测通常存在的精度低等问题,提出了一种基于YOLOv11网络改进的水下图像检测结构DDYOLO,将IDWC卷积替换了C3k2模块中的常规卷积,改善了对光照敏感特征的错误提取,对通道中光照的差异采用不同的处理策略,提升了光照的鲁棒性。利用Dysample替换了原本的Upsample上采样,通过局部约束便偏移范围,避免跨区域的干扰,分组进行特征处理,进一步减少计算量,平衡速度和精度。实验结果表明,改进后的方法与YOLOv11原始结构相比,mAP达到了72.3%,参数量降低了0.2M。因此,本文方法对水下图像的识别有很好的效果,能够实现精确的目标识别,增强了模型的泛化能力,满足对水下目标识别的需求。未来可以对模型进行轻量化改进,在保持精度的同时减少参数量,进一步提高对水下图像的检测识别能力。

参考文献

[1]刘星.基于深度学习的船舶检测与监测方法[D].成都:电子科技大学,2022.

[2]WANG J,YANG H,WU M,et al.UR-YOLO:An Urban Road Small Object Detection Algorithm[J/OL].Pattern Analysis and Applications,(2024-07-18)[2025-07-15],2024,27(4),121.

[3]LI J,TANG H,LI X,et al.LEF-YOLO:A Lightweight Method for Intelligent Detection of Four Extreme Wildfires Based on the YOLO Framework[J].International Journal of Wildland Fire,2024,33(1):1-15.

[4]LI Y,ZHANG X,SHEN Z.YOLO-Submarine Cable:An Improved YOLO-V3 Network for Object Detection on Submarine Cable Images[J].Journal of Marine Science and Engineering,2022,10(8):1143.

[5]GUO T,WEI Y,SHAO H,et al.Research on Underwater Target Detection Method Based on Improved MSRCP and YOLOv3[J].2021 IEEE International Conference on Mechatronics and Automation(ICMA),Takamatsu,Japan,2021:1158-1163.

[6]XIAO Z,LI Z,LI H,et al.Multi-Scale Feature Fusion Enhancement for Underwater Object Detection[J].Sensors,2024,24(22):7201.

[7]HUA X,CUI X,XU X,et al.Underwater Object Detection Algorithm Based on Feature Enhancement and Progressive Dynamic Aggregation Strategy[J].Pattern Recognition,2023,139:109511.

[8]CAI S,LI G,SHAN Y.Underwater Object Detection Using Collaborative Weakly Supervision[J].Computers and Electrical Engineering,2022,102:108159.

[9]杨谢柳,门国文,梁文峰,等.水下图像增强复原对深度学习目标检测精度的影响研究[J].计算机工程,2023,49(11):247-256.

[10]张俊恒,司亚超,郑孟然.CO_YOLO:基于改进YOLOv5的海洋生物目标检测[J].长江信息通信,2024,37(10):69-71+82.

[11]李淇,石艳,范桃.改进YOLOv8n的O型密封圈表面缺陷检测算法研究[J].计算机工程与应用,2024,60(18):126-135.