基于 Spark 的数据中心能耗监测与可视化分析论文

2025-11-12 18:10:52 来源: 作者:xuling

摘要:针对数据中心能耗管理效率低的问题,本文提出了基于Spark与ECharts的能耗监测与可视化分析方法。通过构建Spark分布式计算框架实现能耗数据高效清洗与分析,结合ECharts动态展示数据中心实时能效指标。

摘要:针对数据中心能耗管理效率低的问题,本文提出了基于Spark与ECharts的能耗监测与可视化分析方法。通过构建Spark分布式计算框架实现能耗数据高效清洗与分析,结合ECharts动态展示数据中心实时能效指标。实验表明,该系统可监测PUE、CPU功耗等七类关键指标,目标数据中心平均PUE为1.85,较国家标准高46.0%。本文提出了负载均衡优化建议,可为节能管理提供数据支撑。

关键词:数据中心;能耗监测;Spark;ECharts;可视化

0引言

2021年,中华人民共和国工业和信息化部发布《新型数据中心发展三年行动计划》,要求新建大型数据中心电能利用效率(PUE)低于1.3[1]。据中国信息通信研究院统计,2023年全国数据中心平均PUE为1.49[2],距政策目标仍有显著差距。

传统监测系统存在数据处理效率低、可视化维度单一等问题[3]。在数据中心能耗管理中,能耗监控和数据分析成为实现节能减排、优化能源利用的关键环节。本文基于Spark框架构建分布式计算平台,对数据中心能耗进行高效、可靠的分析和处理;通过ECharts可视化框架多维度、多视角地灵活监测数据中心能耗情况,提升节能意识。同时,为职能部门管理和决策提供科学依据。

1系统设计与实现

1.1技术架构

本项目运用Scala编程语言,结合强大的Spark框架,执行去重、数据清洗、筛选、关联、合并以及计算等一系列复杂的数据处理操作。将处理完毕的数据存储在本地JSON文件中。考虑到Spark原生存储的JSON格式可能与前端的需求不完全吻合,编写Python脚本用于数据的二次处理,确保数据格式完全符合前端的调用需求。最终,前端团队使用JavaScript异步加载并获取这些数据,实现了数据的可视化展示。

系统采用Lambda架构,流程图如图1所示。

1.2核心模块

围绕“数据中心能耗分析”需求,从数据处理到结果输出划分为四层,各层作用及流程如下。

1.2.1需求层

数据中心能耗分析:作为整个流程的起点,代表业务需求,即围绕数据中心的能耗情况进行分析,驱动后续数据处理与分析工作。

1.2.2数据层

数据库(ClickHouse):存储数据,作为数据来源。

数据获取:从ClickHouse中提取能耗相关数据,为分析提供原始数据支撑。

数据整理(Python):对获取的数据进行初步整理,可能包括格式调整、缺失值处理等,确保数据符合分析要求。

1.2.3分析层

数据清洗(Spark):利用Spark对数据进行清洗,去除异常值、重复值等,提升数据质量。

指标计算(Spark):基于清洗后的数据,通过Spark计算能耗相关指标(如平均值、最大值、能耗趋势等),挖掘数据价值。

1.2.4输出层

可视化大屏(JavaScript、ECharts):将分析结果通过ECharts(结合JavaScript)可视化呈现,直观展示能耗数据(如柱状图、折线图等)。

数据报告:生成能耗分析报告,以文档形式总结分析结论,支撑决策。

整体流程:从“能耗分析”需求出发,通过ClickHouse获取数据,经Python整理后,借助Spark完成清洗与指标计算,最终通过可视化大屏和数据报告输出分析结果,形成完整的数据处理闭环。

2实验结果分析

2.1监测指标体系

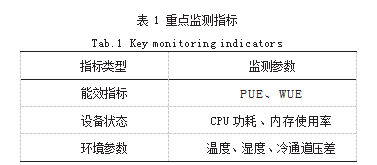

构建重点指标评估体系(如表1所示),覆盖电能、热力学及设备状态维度。

2.2能效分析

实验采集某数据中心2024年5月运行数据(样本量N=134),主要发现如下。

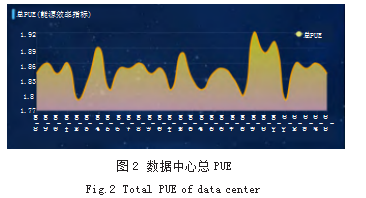

(1)总PUE。是评价数据中心能源效率的指标,是数据中心消耗的所有能源与IT负载消耗的能源的比值。PUE=数据中心总能耗/IT设备能耗(如图2所示),其中数据中心总能耗包括IT设备能耗和制冷、配电等系统的能耗,其值大于1,越接近1表明非IT设备耗能越少,即能效水平越好。该指标有助于量化数据中心直接用于计算的功率与冷却系统、电力损耗、照明和其他支持基础设施消耗的功率的比例。

观察得知,数据中心近一个月PUE在1.79到1.92之间,平均值为1.85,有较小的起伏,可能由于工作量的增加或减少,机器能耗略有改变。但是2023年度国家绿色数据中心PUE平均值为1.26,该数据中心PUE数值高于国家平均值,体现出该数据中心IT设备耗能越多,即能效水平较低,与国家平均水平还有一定差距。

(2)cpu_power(CPU功耗如图3所示)。

根据图2可知,5月20日至5月24日CPU功耗快速增长,5月25日CPU功耗达到峰值,分析得知,在这一段时间内,CPU消耗能源较多,机器负载较大,处理数据量大。

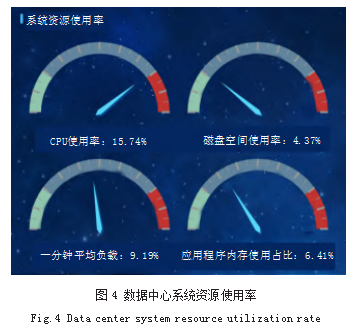

(3)系统资源使用率(如图4所示)。

根据图4可知,最近一段时间内CPU的平均使用率为15.74%,磁盘空间使用率为4.37%,一分钟平均负载为9.19%,应用程序内存使用占比为6.41%。由数据可知,部分机器使用率较低,应合理分配资源,实现负载均衡,使部分高负载机器的应用转移到低负载区,以延长设备使用寿命以及减少设备维修情况。

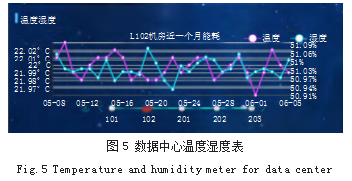

(4)机房温度湿度表(如图5所示)

通过图5可以看出,201机房平均温度最高,203机房平均湿度最高,温度与湿度整体变化趋势基本相同,由此可知,使机房恒温恒湿的设备良好,可以抵消机器所产生的热量,使得设备在良好的环境下运行。

3创新点

Spark大数据处理框架:Spark是一种基于内存计算的大数据处理框架,具有高效、快速、易用等特点。它提供了丰富的API和工具,可轻松应对各种大数据处理场景。借助Spark强大的数据处理能力,可以实现对数据中心海量能耗数据的采集、清洗、转换和可视化分析,实现能耗数据的监测和分析,为优化能耗管理提供决策依据。

可视化动态展示:基于Echart构建实时能耗监控大屏,以直观的图形化界面展示数据中心能耗状况,并动态展示能耗数据变化情况,提高运维人员的工作效率,为管理者提供决策依据。

节能效益:经线性回归预测,优化后年节电量可达28.6万kWh(置信度95%)。

4结语

本文提出的系统有效提升了数据中心能耗管理效率,相比传统方法(Hadoop MapReduce)处理速度提升5.3倍。后续工作将围绕以下内容展开。

(1)集成强化学习算法实现空调系统自适应调控。

(2)开发基于WebGL的三维可视化模块。

(3)动态能耗分析与预警:Spark的实时流处理和窗口计算功能使得系统能够对数据中心的实时能耗数据进行动态分析,如某一时间段或某个机器能耗监测、识别异常能耗峰值等。一旦发现能耗异常或超出预定阈值,系统将立即触发预警机制,通知管理人员及时采取措施调整能源分配,降低无效损耗。

(4)能耗优化:Spark通过对历史能耗数据和实时数据的联合分析,可以挖掘出数据中心能耗的内在规律和模式,进行长期能耗趋势分析与预测,例如,智能调节空调温度、照明亮度,优化设备启停策略等,从而帮助管理者提前规划和优化能源配置,实现能源使用的精益化管理,促进数据中心绿色可持续发展。

综上所述,Spark强大的数据处理能力不仅实现了数据中心能耗数据的监测和分析,也有力推动了数据中心向节能、环保、高效的智能绿色形态迈进。未来,随着技术的不断创新与发展,基于Spark的能耗数据监测与可视化将在行业中发挥更大的作用。

参考文献

[1]工业和信息化部.新型数据中心发展三年行动计划(2021-2023年)[Z].2021.

[2]中国信息通信研究院.数据中心白皮书(2023年)[R].北京,2023.

[3]李明.基于Hadoop的能耗监测系统设计[J].软件学报,2022,33(5):102-110.