基于双卷积链的贴标机械手产品中心视觉定位方法论文

2024-04-25 15:31:50 来源: 作者:hemenglin

摘要: 目前对于机械手产品视觉中心的定位主要采用的是被动双目立体视觉定位法, 但由于缺乏场景坐标的匹配与预测, 导致其 视觉定位精度较差。为此, 提出基于双卷积链

摘要: 目前对于机械手产品视觉中心的定位主要采用的是被动双目立体视觉定位法, 但由于缺乏场景坐标的匹配与预测, 导致其 视觉定位精度较差。为此, 提出基于双卷积链的贴标机械手产品视觉中心定位方法。首先, 对相机的内置参数与外置参数进行标 定, 构建视觉定位场景坐标系。然后, 利用卷积神经网络中的双卷积网络结构, 对视觉中心场景坐标进行预测。最后, 通过匹 配像素坐标与图像特征点实现贴标机械手产品中心视觉定位。在实验中, 在 40 mm×40 mm×40 mm 小规模空间场景和 180 mm× 180 mm×180 mm 大规模空间场景中对所提方法进行了定位精度的检验。实验结果表明, 采用所提方法进行贴标机械手产品中心视 觉定位时, 定位方差较小, 具备较为理想的定位精度。说明所提方法在机械手产品的定位领域具有较好的应用前景, 有助于实现 工业自动化生产。

关键词:双卷积链;机械手; 产品中心;视觉定位

Double Convolutional Chainbased Product Centre Vision Localization Method for Labeling Robots

Zhong Mingdeng ,Tong Huifen

(School of Optoelectronics and Electromechanical Engineering, Minnan University of Technology, Quanzhou, Fujian 362700. China)

Abstract: At present, the passive binocular stereo vision positioning method is mainly used for the positioning of the visual center of robotic arm products. However, due to the lack of scene coordinate matching and prediction, its visual positioning accuracy is poor. Therefore, a visual center positioning method for labeling robotic arm products based on dual convolutional chains is proposed. Firstly, the built-in and external parameters of the camera is calibrated to construct a visual positioning scene coordinate system. Then, using the dual convolutional network structure in convolutional neural networks, the visual center scene coordinates are predicted. Finally, the visual positioning of the labeling robot product center is achieved by matching pixel coordinates with image feature points. In the experiment, the positioning accuracy of the proposed method is tested in a 40 mm×40 mm×40 mm small-scale space scene and 180 mm×180 mm×180 mm. The experimental results show that when using the proposed method for visual positioning of the center of the labeling robotic arm product, the positioning variance is small and has relatively ideal positioning accuracy. The proposed method has good application prospects in the positioning field of robotic arm products, which helps to achieve industrial automation production.

Key words: double convolution chains; manipulators; product centres; visual positioning

引言

对机械手进行视觉定位优化可以使机械手能够自主 定位目标, 从而提高对机械手操控的精准性, 使其能够 代替工作人员从事危险性较高的工作。目前常规的视觉 定位算法主要依靠形状匹配实现, 即通过将目标定位物 体的形状信息输入进机械手的编程算法中, 机械手会根 据形状信息与当前场景下的物体信息进行匹配, 将匹配 度最高的结果视为目标定位物体。该种方法可以在一定 程度上实现对目标物体的有效视觉定位, 但是也存在一 定的局限性[1]。

文献[2]采用 N×N 个边长尺寸相等且已知的正方形组 成的正方形棋盘格为标定板, 应用 Harris角点检测法提取出正方形棋盘格中所有角点的像素坐标。提取待测点 像素坐标值并计算其所处特征正方形的位置, 通过调整 世界坐标和像素坐标实现二维平面上物体的定位。但是 该方法应用过程中, 若当前视野区域内, 目标定位物体 被障碍物所遮挡, 或目标物体在视野区域的边缘处产生 了变形, 都会对机械手的视觉定位效果产生影响。文献 [3]将部分级特征引入交叉视图定位中, 通过生成部分级 特征, 根据该特征实现了无人系统视觉定位。由于涉及 形状信息的精准匹配, 因此对于形状较为复杂的目标物 体, 该方法需要将物体形状拆解为多个节点组成的复杂 结果, 匹配工作量较大, 在定位效率上也无法满足机械 手的工作需求。

本文提出了一种新型的基于双卷积链的贴标机械手 产品视觉中心定位方法, 旨在提高目标图像的匹配精准 性,优化视觉定位效果。

1 方法原理

本文提出的贴标机械手产品中心视觉定位方法主要 实现顺序及内容如下:(1) 标定相机参数;(2) 匹配产 品中心特征点位置;(3) 根据匹配得到的特征位置预测 像素坐标;(4) 将像素坐标与图像特征信息进行匹配, 实现视觉定位。

2 贴标机械手产品中心视觉定位

2.1 相机参数标定

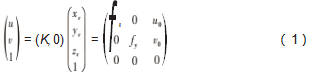

相机参数主要包括内置参数与外置参数, 假设场景 坐标系的原点位于贴标机械手产品中心点上, 则利用相 机内置参数可以求得产品中心坐标的像素转换结果, 具体转换过程如下;

式中: ( xc , yc , z c ) 为场景坐标系中某一点P 的坐标; ( u, v) 为该点的像素转换坐标;fx 和fy 为相机在水平方向和竖直 方向上的拍摄焦距; u0 和 v0 为场景坐标原点的偏置值[4]。

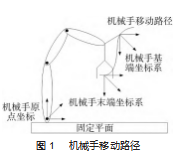

为便于后续的分析, 本文不考虑相机自身产生的畸 变情况,因此像素转换过程为常规的透视变换,即像素点 所组成的图像经变换后沿直线方向实现了等比例平移或缩小。为确定相机坐标系与图像末端坐标系之间的像素转换关系, 本文在贴标机械手的末端固定一个单孔焦距相机, 采用手眼标定方法对标定板图像进行获取, 机械手移动路径如图 1 所示。

根据规划的机械手移动路径, 对机械手进行多次移 动,在不同移动节点下使用单孔焦距相机拍摄多张图片, 以此求解出像素坐标与场景坐标的转换关系。假设在该 转换过程中, 转换矩阵 T为恒定不变量, 则随机两个节 点均满足以下表达式。

通过上述步骤即可明确相机坐标系与图像末端坐标 系之间的像素转换关系[5] ,实现对相机参数的标定, 构 建出三维回归场景。

2.2 基于双卷积链的机械手中心场景坐标预测

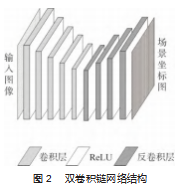

为提高贴标机械手产品中心视觉定位算法的鲁棒性, 本文通过构建双卷积编解码网络结构[6-7] ,对贴标机械手的产品中心场景坐标进行预测, 为视觉定位优化提供更多的可用匹配对象。本文设计的双卷积链网络结构如图 2 所示。

由图可知, 本文提出的双卷积链编解码网络结构主要包 括 3 个部分, 分别为卷积层、 ReLU 层以及反卷积层[8]。 其中, 贴标机械手产品中心相关图像输入进 ReLU 层中, 经编码处理得到场景坐标图。在双卷积链网络结构中, ReLU 层的编码器会根据输入图像的结构特征生成对应的 特征编码图像;特征编码图像输入进反卷积层后,会经由 解码器对图像特征进行解码[9-10]。在输入对图像进行编 码解码的过程中, 卷积层和反卷积层会根据图像分辨率 对图像进行分块处理, 最后将每个图像块得到的图像特 征数据进行重新组合,共同构成输入图像的场景坐标,实 现对机械手产品中心场景坐标的有效预测,通过上述步骤 即可构建出场景坐标回归模型。为提高坐标预测精度,本 文采用由粗到精的策略对场景坐标回归模型进行训练[11]。

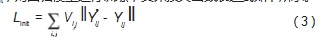

本文对于场景坐标回归模型的训练主要分为两部分, 分别为初始训练以及后期调整两个阶段。在初始训练过程 中,本文将模型预测得到的场景坐标误差值作为损失函数 Linit,对回归模型进行训练,具体损失函数表达式如下所示。

式中: Yij 为机械手产品中心图像中点的场景坐标回归参 数; Yij()为像素点pij 的实际坐标值; Vi, j 用于判断该点是否 存在客观真值, 若 Vi,j 的值为 0.则该像素点不存在客观 真值,若 Vi, j 的值为 1.则该像素点存在客观真值。

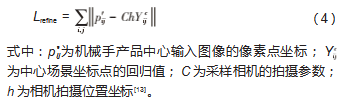

通过上述损失函数即可实现对于场景回归模型的初 始训练[12]。对于模型的后期精细化调整训练, 本文构建 的二次损失函数 Lrefine 的目标为像素节点的二次投影误差值,具体函数表达式如下所示。

在对上述场景坐标回归模型进行训练时, 先采用损 失函数 Linit 对回归模型进行初始训练[14] ,得到初始回归模 型。然后再将初始回归模型的参数进行备份, 采用二次损失函数 Lrefine 对模型进行精细化调整。待模型训练成熟 后即可对其输入机械手产品中心的拍摄图像, 得到场景 坐标预测值[15]。

通过上述步骤即可完成基于双卷积链的贴标机械手 产品中心场景坐标预测, 为后续的视觉定位提供可靠的 坐标数据。

2.3 精细化匹配定位

本文通过将上文中匹配出的像素坐标与产品中心图 像特征点进行精细化匹配, 从而实现视觉定位。由于常 规的精细化匹配算法运行时间过长,容易影响视觉定位效 率, 因此本文选用 GMS 算法[16-17]计算像素点的邻域匹配 点数, 以此判定匹配结果的正确性,具体实现过程如下。

首先将待匹配的机械手产品中心图像进行划分, 将 其划分为 20×20的网格图像,对单个网格中的图像特征点 进行统计,得到特征点总数。针对形状较为复杂且空间占 据面积较大的目标物体,可以根据具体规模选取多个图像 特征点[18]。同时,在完成对于图像网格划分后,将提取到 的图像特征网格进行拼接,以此得到仅包括主要特征点的 图像。考虑到划分完成的机械手产品中心的单个网格图像 中,其图像特征点可能会位于网格边缘[19]处,为实现视觉 定位的精准性, 本文选择对判断阈值进行界定, 假设匹 配成功与否的判断阈值为 τi ,则具体计算公式如下所示。

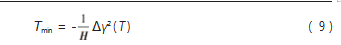

以匹配误差最小值作为视觉定位函数, 通过对该函 数进行数值迭代即可得到匹配误差的最小值, 具体函数 表达式如下所示。

式中: γ2 ( T ) 为目标函数梯度; Tmin 为匹配误差最小值; H为海森矩阵。

通过上述公式对匹配误差进行优化的迭代, 即可求 出在匹配误差最小时像素点的匹配结果, 实现机械手产 品中心的视觉优化。

3 实验论证

为了证明本文提出的基于双卷积链的贴标机械手产 品中心视觉定位方法的定位效果优于常规的机械手视觉 定位方法, 在理论部分的设计完成后, 构建实验环节, 对本文方法的实际定位效果进行检验。

3.1 实验说明

为验证本文提出的监测技术的有效性, 本次实验选 取了两种常规的机械手视觉定位方法作为对比对象,分别 为基于针孔模型的机械手视觉定位方法以及基于改进 YOLOv5 的机械手视觉定位方法。通过构建实验平台,使 用 3 种定位方法对同一台机械手进行视觉定位,对定位结 果进行分析,进而验证本文方法在定位精度上的优越性。

3.2 实验准备

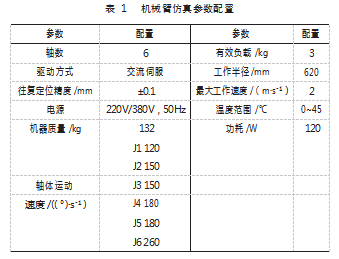

本次实验选取的实验对象为某制造工厂流水线上的 协作六轴智能机械手, 通过使用 MATLAB 软件对机械手 的参数进行调用, 实现机械手的仿真建模, 具体参数如 表 1 所示。

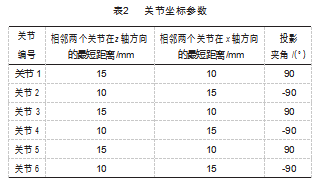

由于本次实验选取的机械臂为 6 轴机械臂, 因此需 要对 6 个关节处的坐标参数进行设定, 具体关节坐标参 数如表 2 所示。

基于上述机械臂配置参数, 构建仿真机械臂模型。 为提高实验结果的可靠性, 本文选择在两种不同空间区 域范围内进行视觉定位, 以此模拟出机械手的不同工作 场景, 空间区域范围分别定为(40 mm×40 mm×40 mm) 的小规模空间场景, 以及(180 mm×180 mm×180 mm) 的大规模空间场景。通过改变机械手产品中心的位置坐标, 以此实现对视觉定位方法的测试, 本次实验所规定 的目标定位节点移动路线如图 3 所示。由图可知, 本次实验所规划的目标定位 点在三维空间中沿 S 型 曲线移动一周, 在移动 过程中采用 3 种视觉定 位方法对目标节点进行 定位, 通过对比不同空 间场景规模下的定位跟 踪效果, 以此判定方法 的实际定位精度。

3.3 定位方差对比结果分析

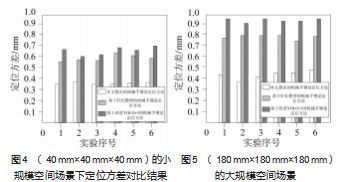

本次对比实验选取的对比指标为不同空间规模下的 定位方差值, 该值越小代表方法的定位精度就越高, 两 种空间场景规模下的定位方差对比结果如图 4~5 所示。

根据上述实验结果可以看出, 空间场景规模对于定 位精度也有着一定的影响,小规模空间场景下的定位精度 较高。根据数值上的对比可以直接看出,在两种不同规模 的空间场景下,本文提出的基于双卷积链的贴标机械手产 品中心视觉定位方法的定位方差值明显低于两种常规的视 觉定位方法, 由此可以证明本文方法能够对于目标节点 进行较为精准的定位,在定位精度上占据较大优势。

4 结束语

本文针对常规视觉定位方法精度较差的问题, 提出 了基于双卷积链的贴标机械手产品中心视觉定位方法研 究。通过结合双卷积网络结构, 对中心场景坐标进行了 有效预测, 以此为根据与产品中心图像特征点进行精细 化匹配, 实现贴标机械手产品中心视觉定位。在两种空间场景规模下按照既定定位点移动路径进行定位实验, 实验结果表明, 所提方法获取的定位方差较低, 即表明 所提方法具有较高的贴标机械手产品中心视觉定位精度, 为提高视觉定位效果提供了可靠帮助。在今后的研究工 作中, 将探讨不同定位场景对于定位效果的具体影响, 为同类型的视觉定位技术研究提供积极借鉴。

参考文献:

[1] 冷珏琳, 张哲,刘田田,等 . 基于几何矩的 CAD 模型形状匹配算 法及应用[J]. 图学学报,2021.42(4):608-614.

[2] 秦亚敏, 张雷,赵东哲,等 . 一种基于正方形内插点的二维平面 视觉定位算法[J].河北省科学院学报,2023.40(1):7-12.

[3] 李永亮 . 工业机器人视觉定位技术的应用[J].电子技术,2023. 52(1):296-297.

[4] 李佳汶,冯建航,施生生,等 . 基于空地交叉视图匹配的无人系 统视觉定位[J].指挥信息系统与技术,2022.13(6):16-22.

[5] 陈锡文 . 基于视/力觉反馈的复合定位方法研究[J].微型电脑 应用,2022.38(12):172-176.

[6] 刘艳丽,尹慧君, 张恒 . 基于自适应软重采样粒子滤波网络的 视觉定位[J].计算机工程与设计,2022.43(12):3503-3512.

[7] 李若森,雒江涛,许国良 . 面向盲去模糊的选择性内核卷积混 合连接编解码网络[J]. 重庆邮电大学学报(自然科学版),2021. 33(6):977-983.

[8] 张旭辉,杨红强, 白琳娜,等 . 基于改进 RANSAC 特征提取的掘进 装备视觉定位方法研究[J].仪器仪表学报,2022.43(12):168-177.

[9] 石建刚,任帅 . 钩托板螺栓拆装机器人的视觉定位系统设计与 研究[J].机床与液压,2022.50(21):69-74.

[10] 马礼,赵晓伟,李德江 . 一种基于多目视觉的标记点定位方法 [J]. 地理空间信息,2022.20(10):26-30.

[11] 张科昌,生绿伟,杨洋洋,等 . 基于 DSP 系统架构的轮胎吊视觉 定位方法[J].港工技术,2022.59(5):62-67.

[12] 金苇,钱巨,孟祥臻 . 基于双目视觉与目标识别拟合的三维屏 幕定位方法[J].计算技术与自动化,2022.41(3):94-99.

[13] 黄志富 ,黄俊彬 , 陈朝大 ,等 . 视觉定位激光打标装置的设计 [J]. 机电工程技术,2022.51(8):141-143.

[14] 毕松,王宇豪 . 果园机器人视觉导航行间位姿估计与果树目 标定位方法[J]. 农业机械学报,2021.52(8):16-26.

[15] 仉新,郑飂默,谭振华,等 . 基于特征编码和动态路由优化的视 觉定位方法[J]. 中国惯性技术学报,2022.30(4):451-460.

[16] 牟琦,唐洋,李占利,等 . 基于网格运动统计算法和最佳缝合线 的密集重复结构图像快速拼接方法[J]. 计算机应用,2020.40 (1):239-244.

[17] 刘帅, 芮挺,王东,等 . 基于特征匹配质量的 GMS 改进算法研 究[J]. 电光与控制,2021.28(7):31-34.

[18] 彭卫东,温力伟 . 基于机器视觉的开关操纵机械手研究[J].机 电工程技术,2021.50(3):129-131.

[19] 吴潮建,王嘉源,钱嘉栋,等 . 基于视觉定位的带电作业锁杆无 线遥控操作技术[J].计算技术与自动化,2022.41(2):51-55.

[20] 牛洪超, 白松,胡晓兵 . 基于改进 YOLOv5 的视觉定位算法[J]. 计算机工程与设计,2022.43(6):1620-1627.

[21] 万书亭,王萱,张伯麟,等 . 多幅X射线旋转图像轮廓对应点坐标提 取和匹配方法研究[J].中国工程机械学报,2022.20(5):390-395.